大多数 Amazon 数据 scraper 的痛点在于:你必须先准备好每个商品的 ASIN 或链接,才能抓到商品信息——但如果你想一次性抓取 Amazon 上成千上万的商品呢?这就开始让人抓狂了。

另一个常见问题是,很多工具都自称 “no-code”,结果还是要你配置 API、看懂 HTML 标签之类的东西。但当你想抓几百甚至几千个 Amazon 商品时,你要的根本不是这些。

这篇指南会教你如何用一个真正能干活的 AI Agent,实际落地地从 Amazon 抓取商品列表,而且还能自动翻页抓多页 Amazon 页面。

本文会带你完成:

Step 1: Amazon 商品抓取前的准备

抓 Amazon 的搜索结果时,你需要一个真的能在不同页面之间跳转、并把商品链接拿出来的工具。有人把它叫 Amazon product link extractor,我们把它叫 AI Research Agent。

要开始提取商品链接,先打开 Datablist.com 注册账号。

接着创建一个 collection:你可以在起始页点击 New Collection,或者在侧边栏点击 Create new collection。

创建完成后(给它起个名字),你会看到类似下面这样的空 collection。

💡 Datablist 是什么?

Datablist 是一个 AI 驱动的 spreadsheet(表格) 和数据管理平台,帮你采集、清洗、整理、Enrich 数据,并自动化整个数据流程——不需要任何技术背景。

可以把它理解成“升级版 Excel”:内置 data sources、enrichments 和 AI agents,让你把很多传统表格做不到的工作规模化、流程化。

打开 Amazon,复制你的搜索结果页面 URL。

以我的例子为例,URL 是:https://www.amazon.com/s?k=coffee+mug&crid=1UV1WPG69YYZM&sprefix=coffee+mug%2Caps%2C197&ref=nb_sb_noss_1

一般它会以 https://www.amazon.com/s?k=XXX 开头。

现在你应该已经完成:

- 注册 Datablist。

- 创建了一个 collection。

- 把 Amazon 的 URL 复制到剪贴板。

预备工作就到这里 🙂

接下来我会带你设置自动化流程,从 Amazon 搜索结果里批量抽取商品链接。

Step 2: 抓取 Amazon 搜索结果页

把 Datablist 的 AI Research Agent 想象成工地上的员工——它一次能搬运的数据量是有限的。所以我们会先把所有商品链接抓出来,然后再基于这些链接去抓商品详情。

回到你的 Datablist collection,点击 See all sources。

点击 AI Agent - Site Scraper。

把 Amazon 搜索链接粘贴到 Url to scrape。

接着复制下面这段 prompt,粘贴到 Prompt 字段里。别忘了按你的情况修改。

I want you to extract all links to products on this page

===Extract only the products from page {{X}} - current page - and beyond. The page is specified in the URL with the "page=X" parameter.

===Extract as many links as possible but only the product links and nothing else.

===

No Introductions

No Explanations

No Thoughts

prompt 的修改方式如下(示例):

把 {{X}} 替换成你要从第几页开始抓取,就这样。

然后点击 Enable Pagination,把 Max Pages 设置为 10。

📘 为什么只抓 10 页?

因为我们在设置里定义了起始 URL,所以先从前 10 页开始最稳妥。结果没问题的话,再从第 X + 10 页继续跑一次 AI Scraper。具体见:Resume Amazon Scraping from Another Page。

接下来我们来配置 outputs。

往下滑,然后:

- 在 Output Name 粘贴

Product Link。 - 在 Output Description 粘贴

Link to the product。 - 在 Output Type 选择

URL。

然后点击 More。

第二个 output:

- 在 Output Name 粘贴

Error Message。 - 在 Output Description 粘贴

The reason why you couldn't deliver the output (only by failure)。

然后勾选 Advanced Settings。

- 选择 OpenAI: GPT 4.1 mini。

- 把 Max iterations 设置为 10。

- Website Scraper Option: Render HTML 用于需要 JavaScript 渲染的站点;这里 可选。

点击 Continue。

点击每个 output 旁边的 ⊕ 图标,为每个 output 新增一列(column)。

点击 Run Import Now。

等待 2–10 分钟左右,你就能拿到所有商品链接。

现在 Amazon 搜索结果抓取已经完成了,下面我们来看如何从这些商品页批量提取商品详情。毕竟抓 Amazon 不只是收集链接,更关键的是把每个商品的重要信息都抓出来。

Step 3: 从 Amazon 商品页提取商品详情

我喜欢 Amazon 的一点是:它的商品页面结构对 scraper 来说非常友好,基本你想要的信息都能找到。接下来你要做的是:

- 打开你刚刚抓到的商品链接里 3–4 个商品页。

- 选出你想抓取的字段(字段=你要的商品信息),并复制 2–3 个示例。

- 按你要抓的字段去调整 prompt。

- 用 Datablist 的 AI Agent 开始批量抓取。

我们一步步来。

📘 理解 Labels(字段标签)

每个 Amazon 商品的细节不同,但同一类商品(比如手机、鞋子)通常会共享一组常见的描述项(labels/字段)。你把这些字段理清楚,就能明确告诉 AI 要抓什么。

如果你想抓价格、商品名、品牌、评分等基础信息,一般在商品页顶部就能找到。你现在要做的是:

- 复制该字段对应的内容,先粘贴到一个文档或备忘录里——等下会用到。

- 给这个字段起一个 label,并附上 2–3 个同类商品的示例。

- 确保这个 label 描述的是同一种信息类型。

示例:"- Brand (Adidas; Nike; Apple)"

如果你要更细的参数信息,需要往下滚动,找到 Amazon 展示的所有商品详情。想抓这类详情,可以按下面流程做:

- 复制左侧的 label(字段名),粘贴到你的文档。

- 复制右侧的值(字段内容),也粘贴到文档。

- 再附上 2–3 个同类商品的示例。

- 对每个你想抓的字段重复以上步骤。

示例:"- Capacity (16 ounces; 300ml;)"

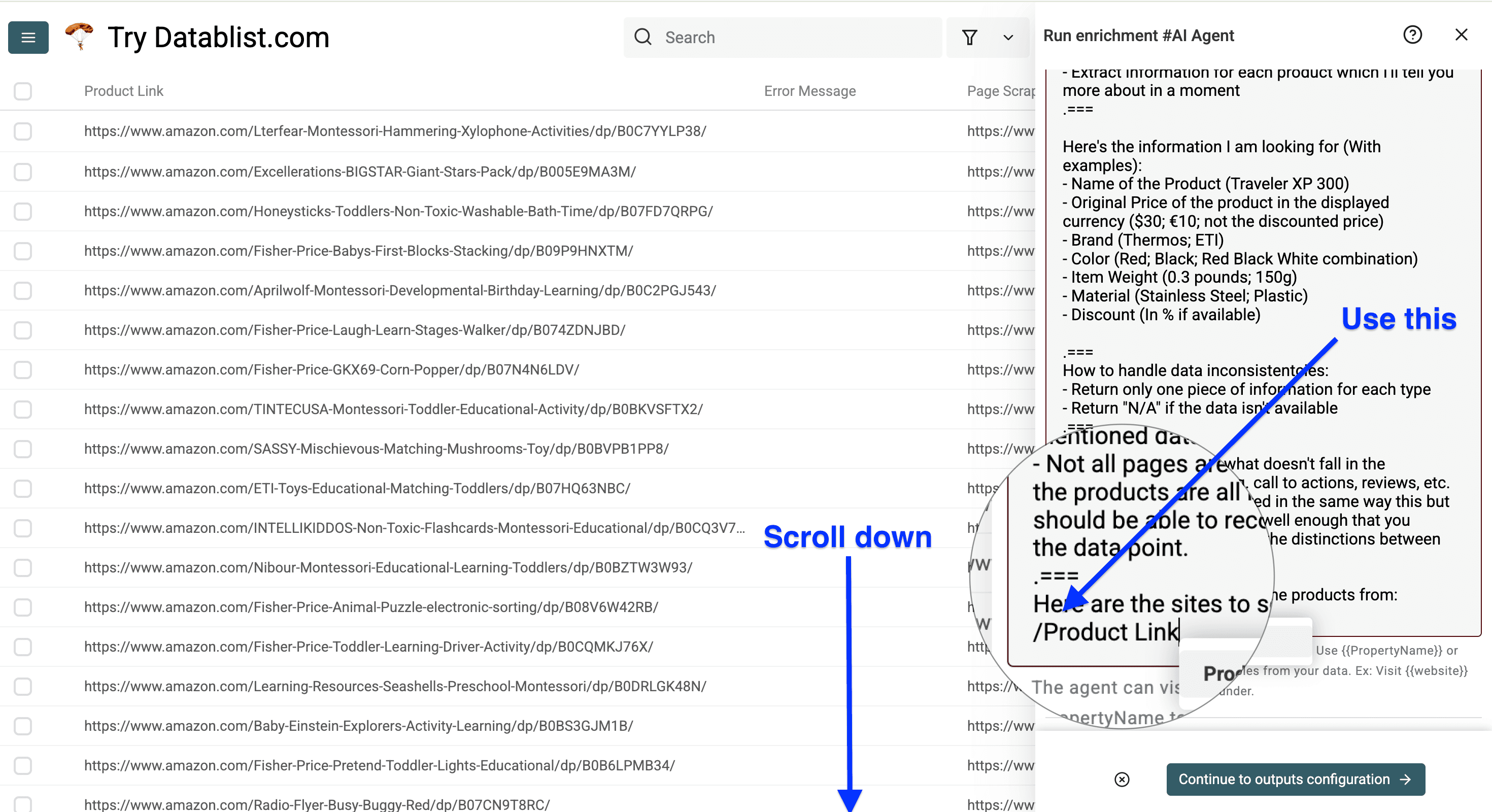

打开包含商品链接的 Datablist Collection,点击 Enrich。

进入 AI,选择 AI Agent。

复制下面这段 prompt,粘贴到 Prompt 字段。你需要按自己的字段进行修改!

My Goal: I have a list of Amazon product pages from which I need specific product information.

===

I want you to:

- Visit each page that I am going to give you the link for

- Extract information for each product which I'll tell you more about in a moment

Here's the information I am looking for (With examples):

- Name of the Product (Traveler XP 300)

- Original Price of the product in the displayed currency ($30; €10; not the discounted price)

- Brand (Thermos; ETI)

- Color (Red; Black; Red Black White combination)

- Item Weight (0.3 pounds; 150g)

- Material (Stailness Steel; Plastic)

- Discount (In % if available)

How to handle data inconsistencies:

- Return only one piece of information for each type

- Return "N/A" if the data isn't available

Mistakes to avoid:

- Don't return anything that doesn't fall in the mentioned data types e.g. call to action, reviews, etc.

- Not all pages are structured in the same way but the products are all labeled well enough that you should be able to recognize the distinctions between the data points.

Here is the site to scrape the product info from:

/ProductLink

现在,把我在 prompt 里写的字段说明,替换成你自己刚刚整理出来的字段说明。示例如下:

然后在 prompt 最后一段指定“商品链接所在的列”(也就是模板里的 /ProductLink)。

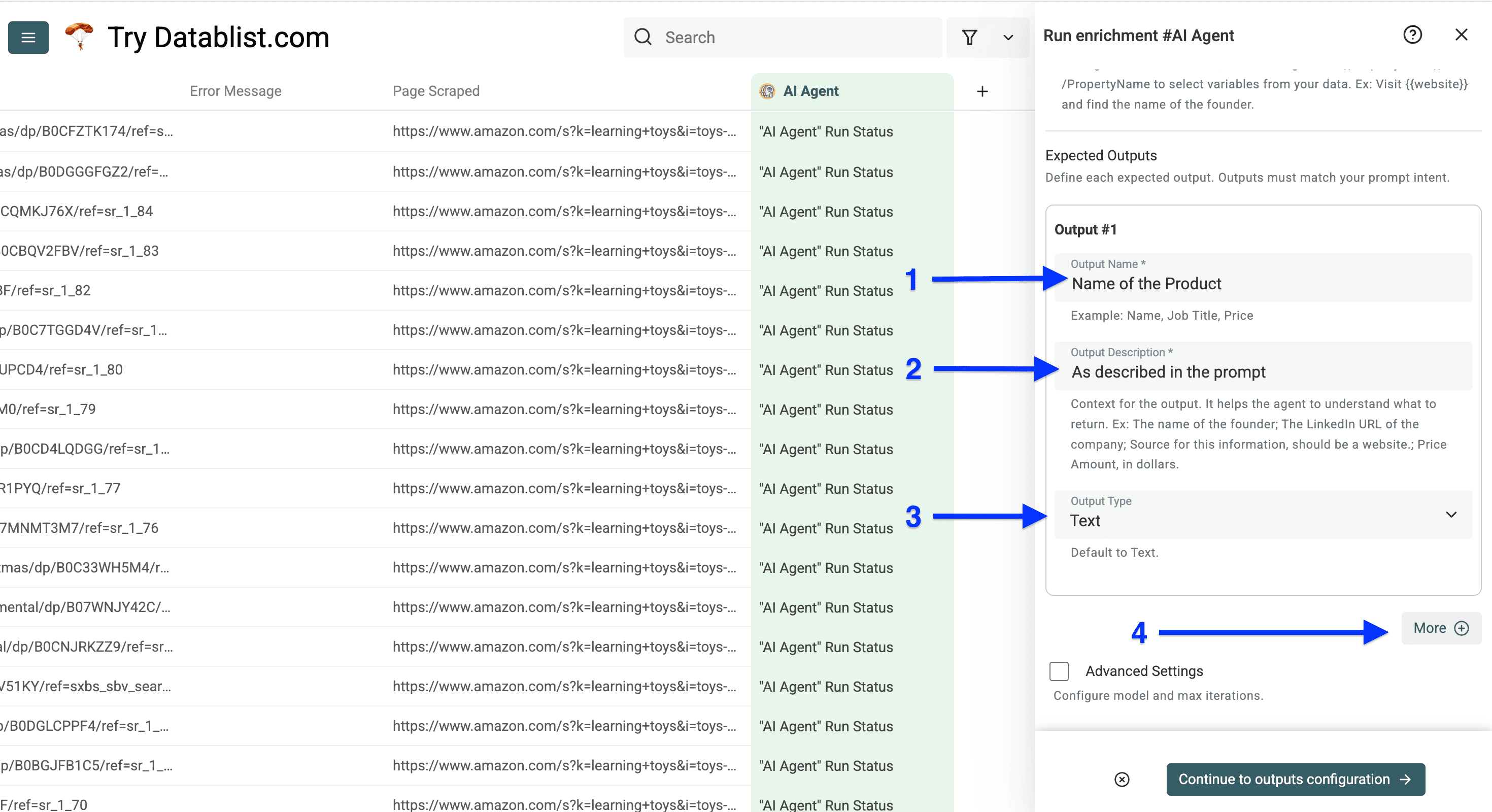

接着往下滑,配置你的 Outputs。

Outputs 的配置方法:

- 在 Output Name 填你的 label 名。

- 在 Output Description 填 “As described in the prompt”。

- 为你的数据选择合适的 Output Type。

点击 More,对每一个你要抓的字段重复上述步骤。

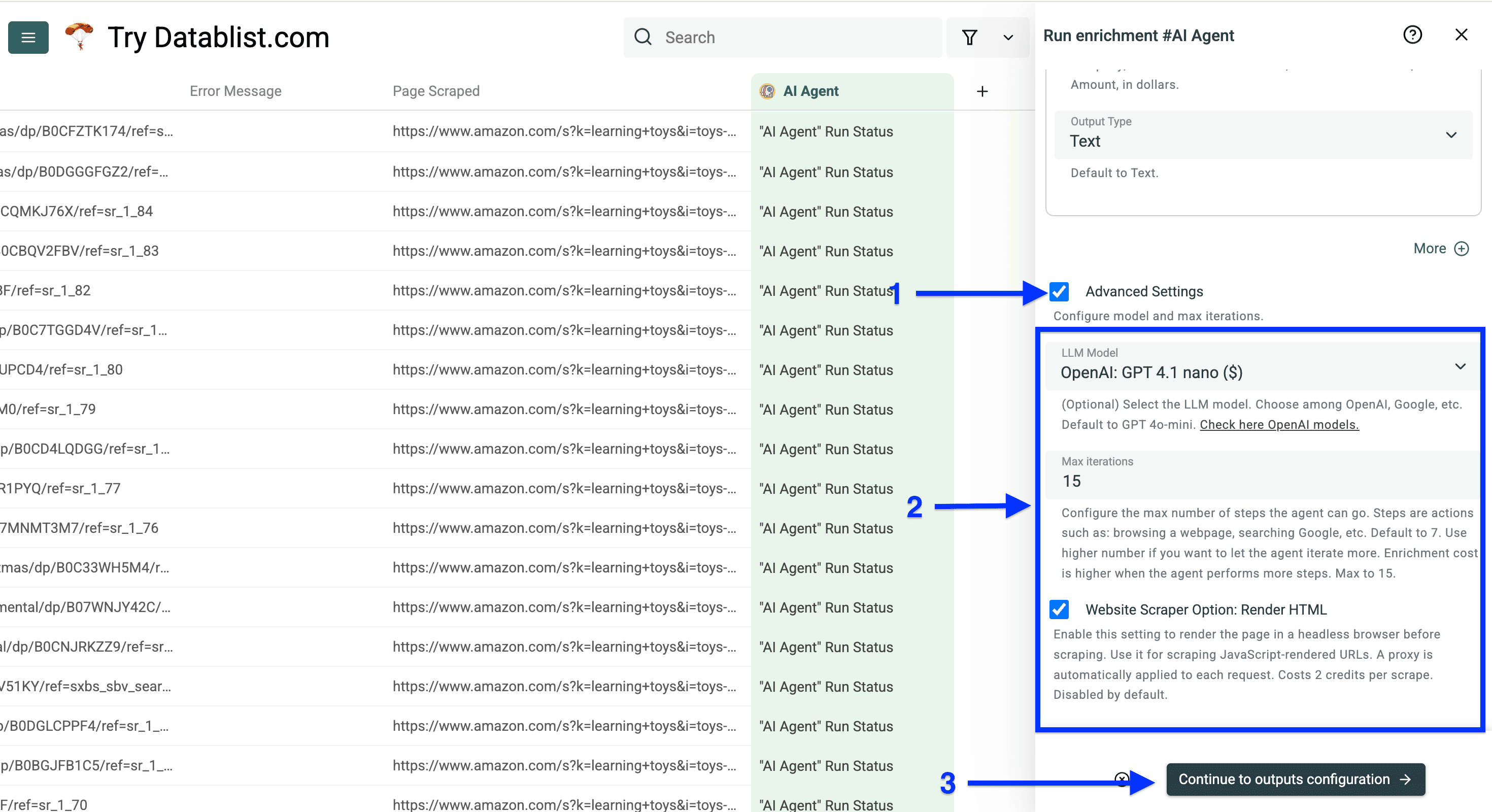

当你配置完所有 outputs 后,勾选 Advanced Settings,并使用以下设置:

- LLM Model: GPT 4.1 nano

- Max Iterations: 15

- Website Scraper Option: Render HTML: Optional

然后点击 Continue to outputs configuration。

点击 ⊕ 图标,为每个 output 新增一列。完成后,点击 Instant Run。

接下来你会看到 Run Settings,可以选择要处理的 Number of items to process。

设置好之后,点击 Run enrichment on X items,开始从 Amazon 批量抓取商品详情。

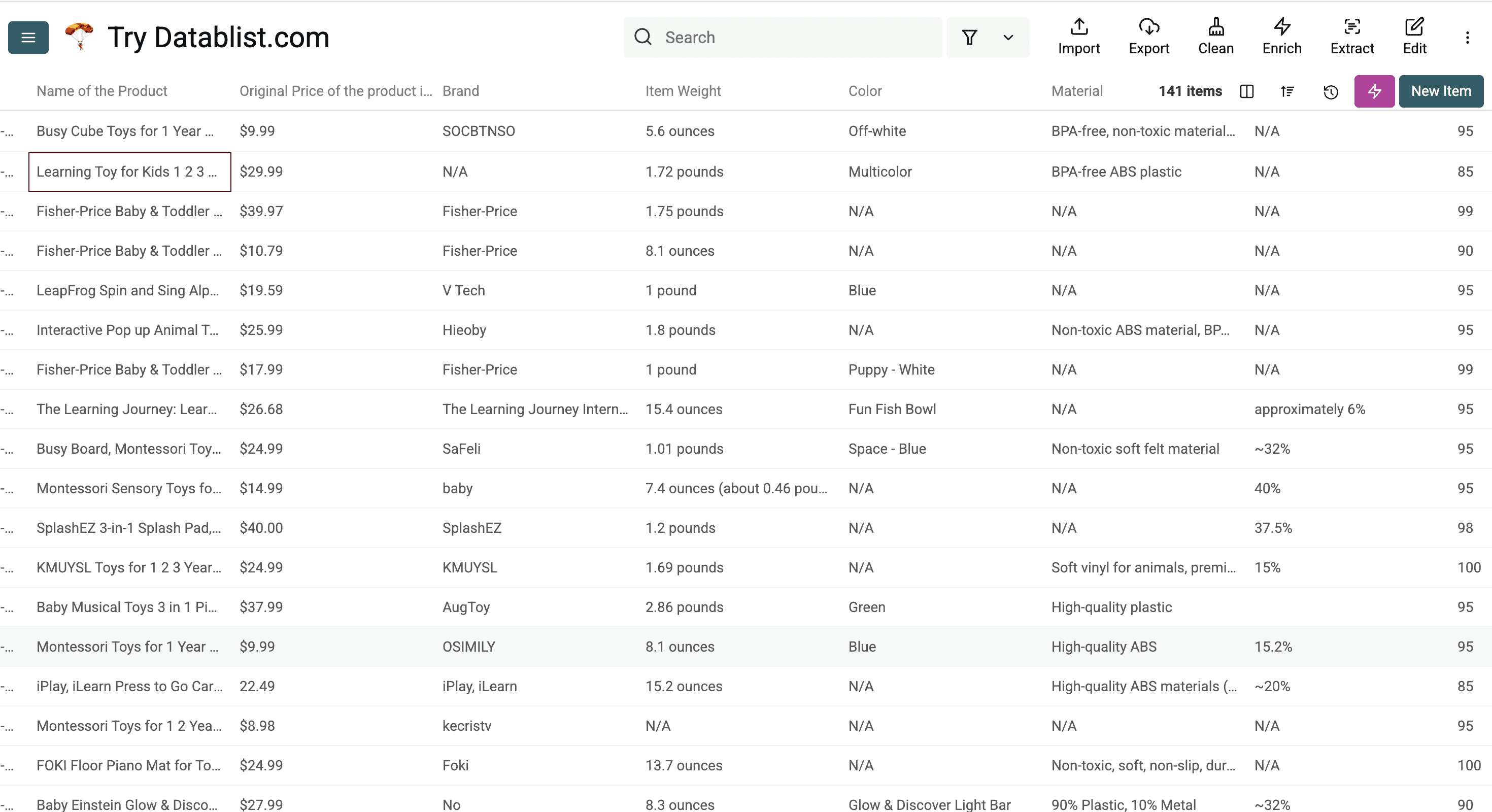

当 Datablist 的 AI Agent(也可以理解为你的 Amazon scraper)跑完后,你的 collection 里就会出现你要求的所有商品详情。

Resume Amazon 从其他页面继续抓取

抓 Amazon 搜索结果时,最稳的方式是“小步快跑”。

先抓前几页,检查链接是否正常,再从中断的地方继续。

第一次用 AI Agent scraper 跑完后,你可以直接复用同一套配置去抓下一批页面。

在 collection 右上角点击粉色的 “Saved Enrichments” 按钮。

这里会打开你保存过的 enrichments 列表。

找到你刚刚用过的 Amazon scraper,点击 “Play” 图标进入设置。

然后更新 Amazon 搜索 URL,让它从下一页开始。

比如你已经抓完第 1–10 页,只要在 URL 末尾加上 &page=11。

为了避免重复抓取,可以看看 collection 里已抓到的商品链接。

你甚至可以新增一列叫 Page Scraped,在第一次抓取时把来源 URL 存进去。

根据这些信息,决定下一次的 &page=X。

抓取、检查、继续。这样你就能稳定扩展 Amazon 抓取规模,而且不会漏掉关键数据。

Frequently Asked Questions

如何在不写代码的情况下抓取 Amazon?

你可以用 Datablist 的 AI Agent 这类 no-code 工具,在不写任何代码的前提下抓取 Amazon 商品及其详情。这类工具提供可视化操作界面,你只需要输入 URL,并选择要提取的数据字段即可。

对非技术用户来说,哪个 Amazon scraper 最好用?

对非技术用户来说,像 Datablist 这种 AI 驱动的 web scraper 非常友好:界面直观、无需编程,并且可以通过简单的点选和配置完成相对复杂的抓取任务。

抓取 Amazon 数据合法吗?

在遵守 Amazon 服务条款(terms of service)的前提下进行 web scraping 通常是合法的。关键在于尊重其 robots.txt,不要对服务器造成过载,并在使用数据时符合其相关政策要求。

从 Amazon 提取商品信息最简单的方法是什么?

最省事的方式是使用 Datablist 这类 no-code 抓取工具。它们可以通过模板和 AI 自动识别页面结构,提取价格、标题、描述、评论等信息,不需要你具备技术背景。

How to Scrape Amazon Search Results Without Code

只要使用 Datablist 的 AI Research Agent 这类工具,抓取 Amazon 搜索结果其实并不难:几分钟就能批量抓到搜索结果里的商品链接,全程不需要写一行代码。