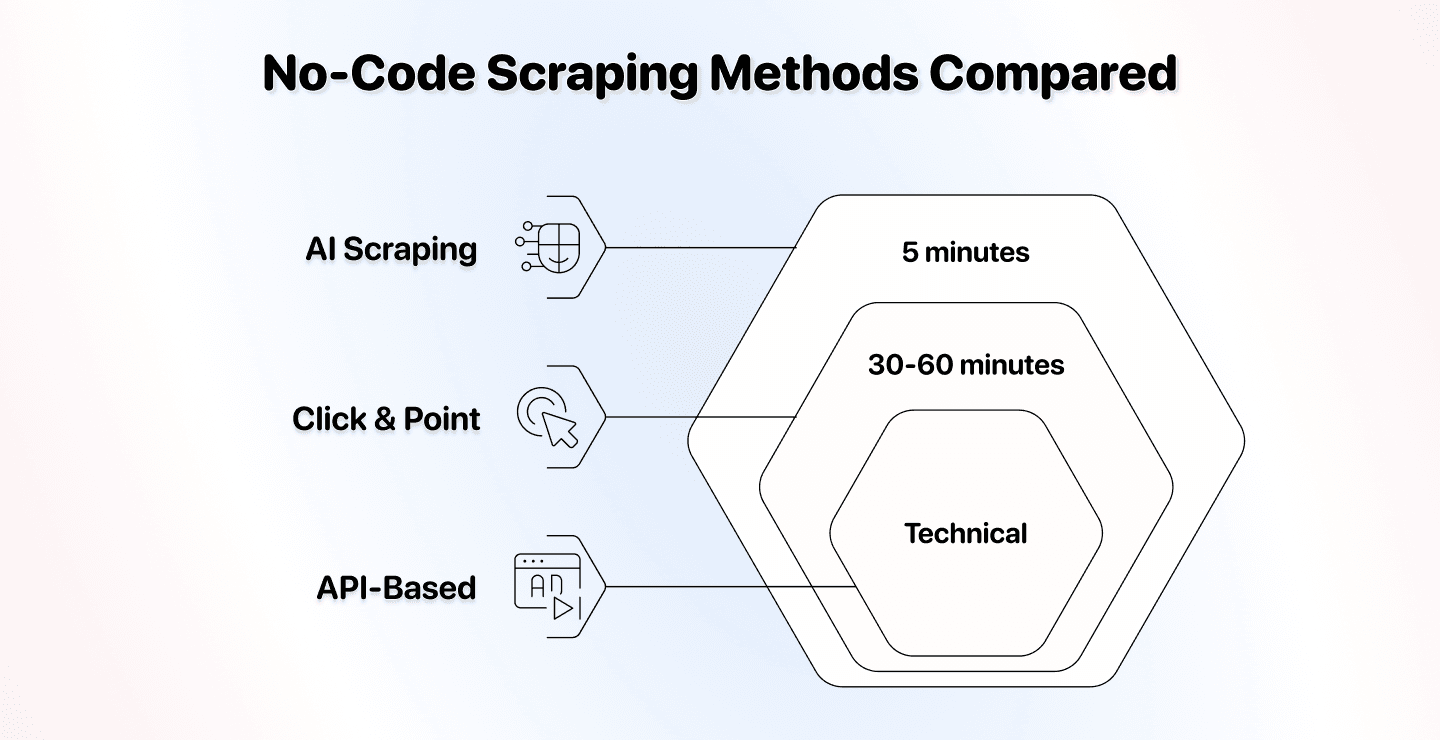

no-code scraping 这个圈子里,其实主要就三种方法,而且选错方法会让你白白浪费大量时间和预算。

我们把 AI scraping、传统 no-code scraping,以及 API-based scraping 放在一起对比,帮你看清它们真正的差异。没有废话,只讲事实:搭建时间、灵活性、价格,以及最适合的使用场景。

读完这篇,你会非常清楚哪一种方法最适合你的需求。

📌 赶时间的人先看这里:总结

这篇文章对比了三种 no-code scraping 方法,帮助你按自己的项目需求做选择。

核心问题: 你的项目应该用哪种 no-code scraping 方法?

对比维度: AI scraping、传统 click-and-point 工具、API-based scrapers 的上手难度、灵活性、价格、适用场景,以及各自更推荐的工具。

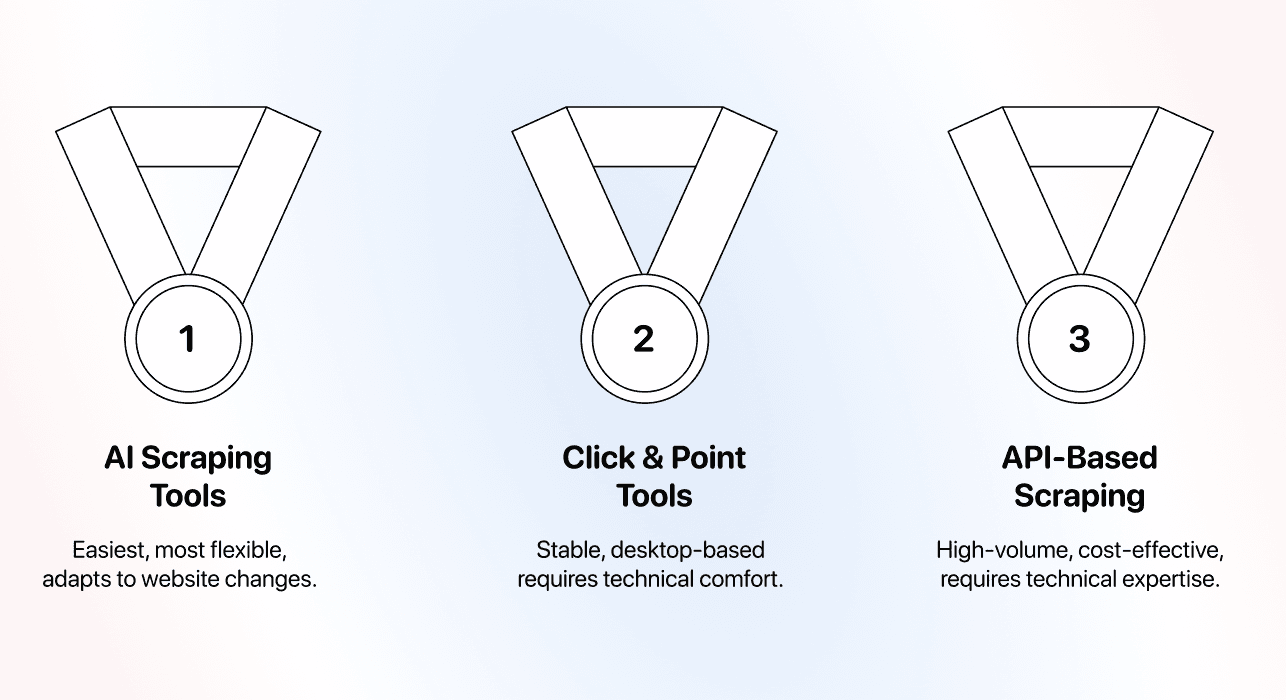

快速结论:

- AI scraping 最简单:对非技术用户最友好,也能适配网站变化

- Click-and-point 工具最适合:你需要精细控制、且网站几乎不变的场景

- API-based scraping 性价比最高:但对技术能力有要求

你将学到: 每种方法的工作原理、它们的关键差异、各自什么时候用最划算,以及哪些工具效果最好。

本文内容一览

- AI Scraping:用自然语言“说清楚”就能抓取

- 传统 No-Code Scraping:Click-and-Point 工具

- API Based Scraping:介于技术与 no-code 的折中方案

- 最终结论:到底该选哪一种?

AI Scraping

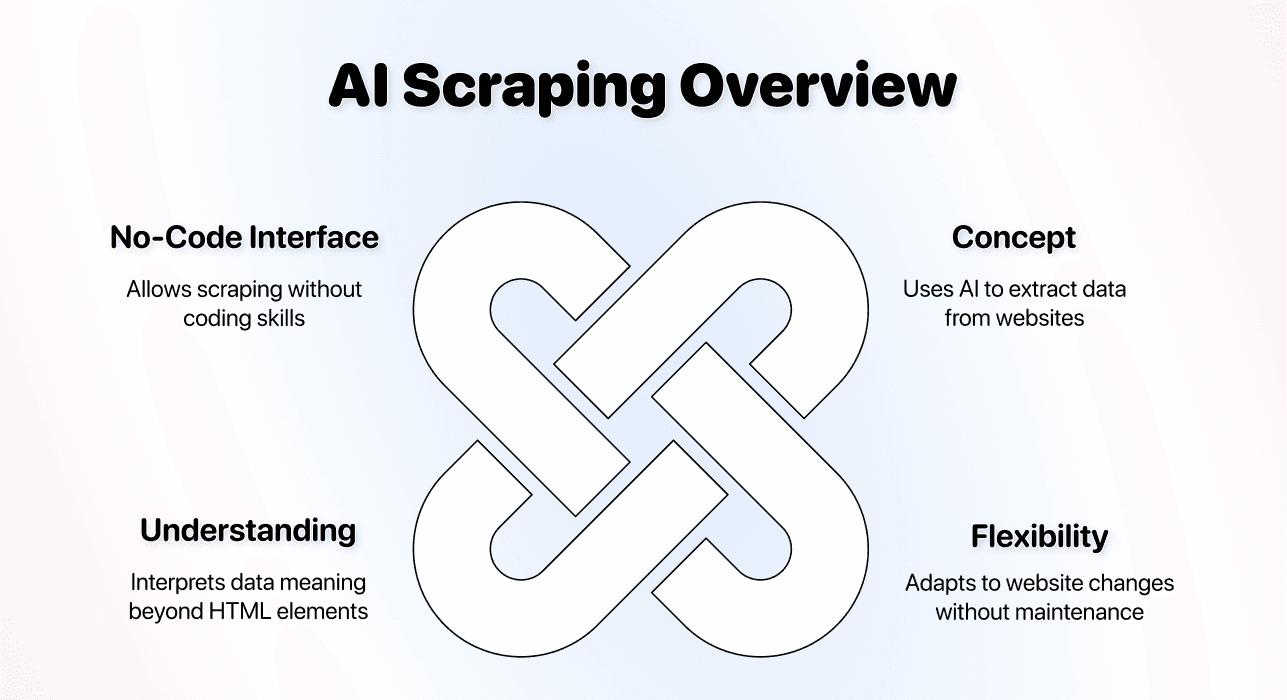

AI scraping 是目前最新一代的 no-code 数据提取方式。它用 AI 来理解你的目标,并自动判断该怎么从网页里把数据拿出来。

核心理念

AI scraping 工具通常基于大语言模型(LLM)和机器学习,从网站里抽取数据。你只需要用自然语言说明你想要什么数据,技术细节交给 AI 处理。

它有很多叫法(AI no-code scraping、AI data scraping、AI web scraping),但本质都一样:用 AI 工具抓取网页数据,不用写代码,也不用配置复杂 selector。

它和传统方式最大的不同在于:

↳ 传统 scraper 是按你制定的固定规则执行

↳↳ AI scraper 能理解上下文,并适应变化

↳↳↳ 结果就是:维护更少,灵活性更强

AI 不只是去找某个固定的 HTML 元素,它能理解“product price”指的是商品的价格信息,不管网站把价格放在什么结构里。

上手难度

在三种方法里,AI scraping 的搭建最省事。

典型流程:

- 选择你的 AI scraping 工具

- 输入目标网站 URL

- 用自然语言描述你要抓取的数据

- 运行 scraper

**时间成本:**多数网站大约 5 分钟就能搞定[1]。你不需要懂 HTML、CSS selector 或网站结构,AI 会根据你的描述自动判断从哪里取数据。

这里有个视频,演示我如何在 6.04 分钟内用 AI scraping agent 抓取一个电商网站 📺

**你最需要的能力:**表达清晰。只要你能把需求描述清楚,AI scraping 基本几分钟就能跑起来。

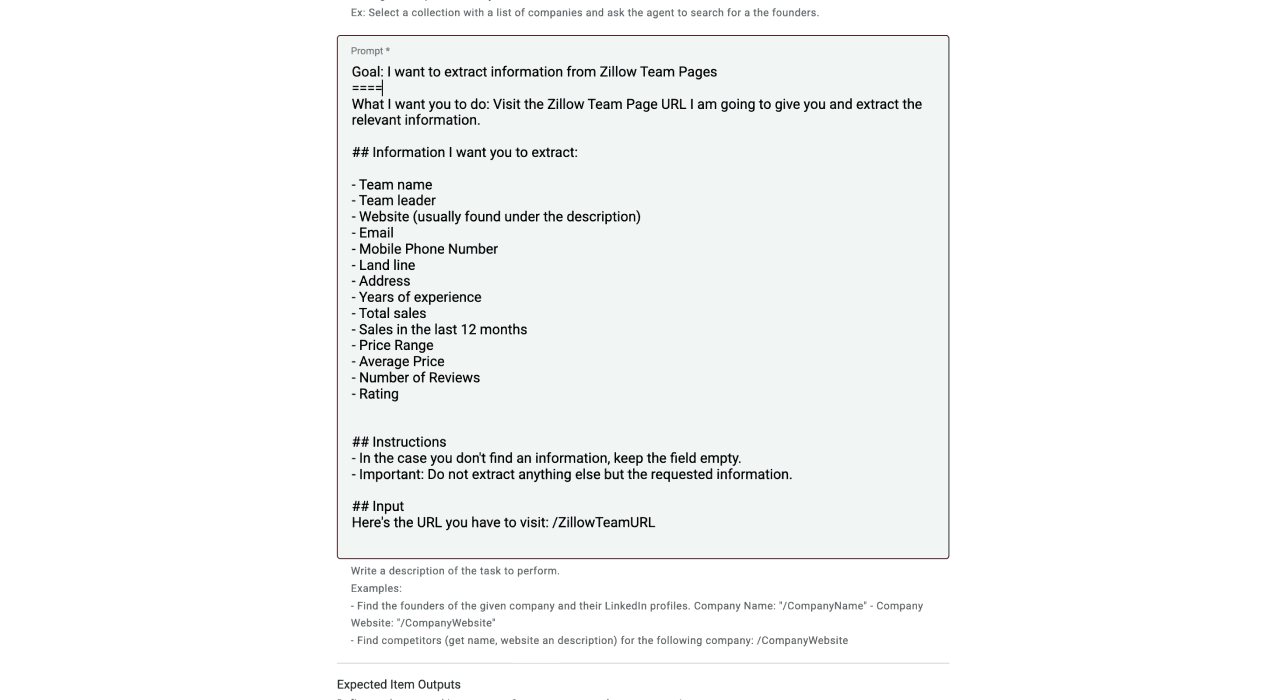

你可能会喜欢的 AI scraping 模板

我们经常为用户制作 scraping 模板 ❤️。下面这些你可能用得上:

- How to scrape the YC Startup directory

- How to scrape properties from Zillow

- How to scrape real estate agents from Zillow

- How to scrape properties from AirBnB

- How to scrape businesses from Yellow Pages

- How to scrape an e-commerce shop

- How to scrape case studies from a website

这些模板在 Datablist app 里也能直接用,真的只要点几下就能开始。如果你想让我们帮你做一个专属模板,可以在这里联系:/contact 👈🏽

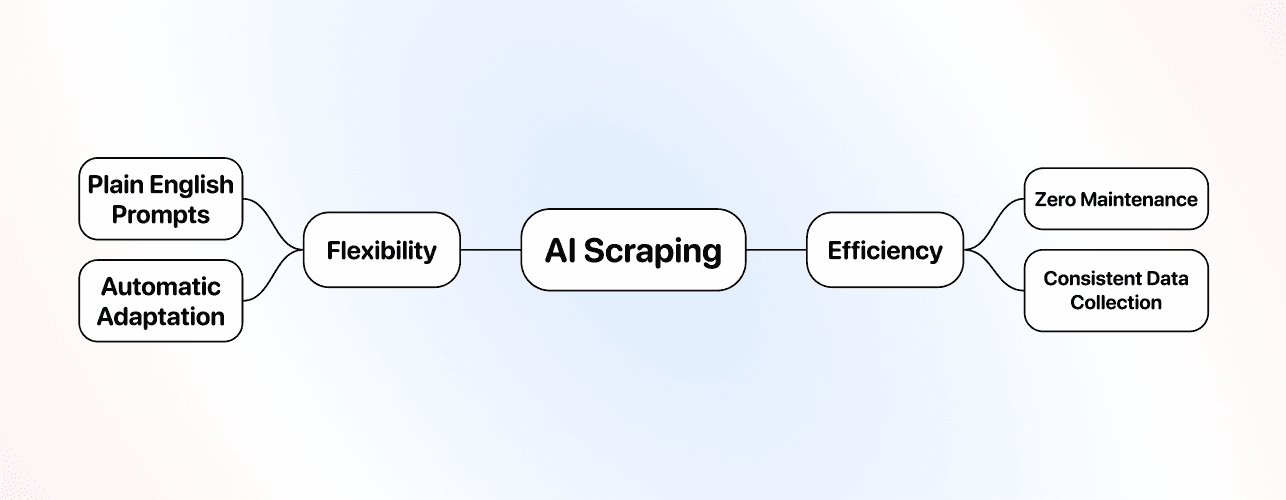

灵活性

在“灵活性”这点上,AI scraping 基本是碾压其它方案。

当出现以下情况时,AI scraping 往往能自动适配:

↳ 网站改版、布局重做

↳↳ 内容出现在意想不到的位置

↳↳↳ 不同页面用不同的 HTML 结构

传统的 no-code 或代码 scraper 会因为依赖固定 HTML 元素而“断掉”。AI scraper 关注的是“意义”,所以即便页面结构变了也更容易继续工作。这也意味着:AI scraper 一次配置好,稳定性通常更强。

**举个例子:**你要抓取多个电商站点的商品信息。每个站点的 HTML 结构都不一样。用 AI scraping 时,你可以用同一段 prompt,让 AI agent 针对不同网站自动调整。

**局限:**AI scraping 更擅长抓取公开可见的数据。对于复杂登录、强验证流程或登录墙之后的数据,它通常不如定制化 scraper 来得稳。

价格

AI scraping 通常单次操作成本更高,因为它需要算力去理解页面并处理数据。

常见计费方式:

- 订阅制(包含一定 credits)

影响成本的因素:

- JavaScript 很重的网站更贵(需要渲染)

- 翻页、多个步骤的任务会增加成本

- 简单目录页更便宜

**真实场景参考:**抓取某个目录网站里的 1,000 条企业 listing,很多 AI scraping 工具大概会消耗 500–1,000 credits。具体要看页面复杂度和你提取的数据量。

**值不值?**对非技术用户来说,通常非常值。你花钱买的是省时间、几乎零维护,以及最关键的:省心。所以 AI scraping 也可以理解为“无痛 scraping”。

使用场景与最佳实践

AI scraping 最适合用在那些“它的优势能真正发挥价值”的场景里。

最佳使用场景:

- 同时抓取多个结构不同的网站

- 你不想碰技术细节

- 维护时间很贵(人力成本高)

- 目标网站更新频繁

- 需要理解上下文的多类型数据提取

- 不想折腾传统 no-code scraper 或 API

**什么时候 AI scraping 是明智选择:**你要做市场调研,抓取多个竞品网站数据,但这些竞品网站用的建站工具和布局都不一样。AI scraping 可以用同一套 prompt 覆盖大多数情况。

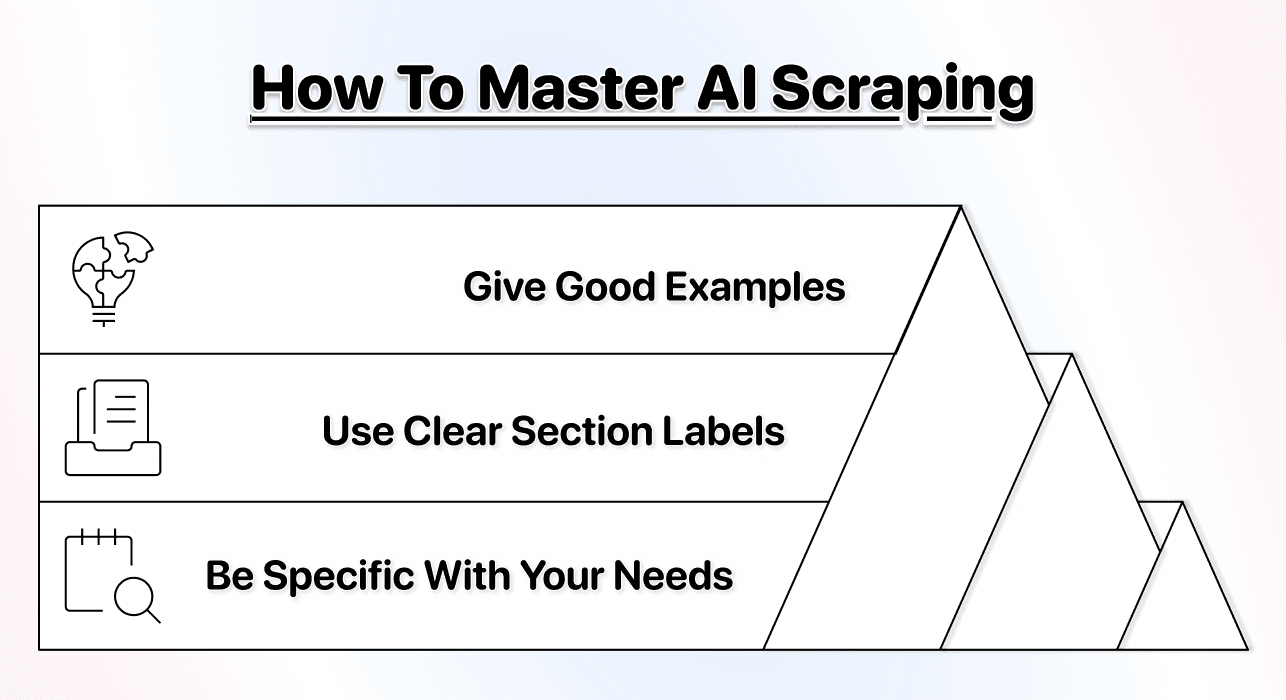

AI scraping 最佳实践:

- prompt 写得清晰、具体,明确字段与规则

- 尽量给例子,准确率会更高[2]

- 先小规模测试,再扩大到大数据量

- 在 prompt 里用分段标签(section labels)组织需求

如果你想更深入,这里有一份很实用的指南:了解 如何写好 AI agent 的 prompt 👈🏽

最推荐的工具

如果你要做 AI scraping,Datablist 对非技术用户来说是非常突出的选择[3]。

为什么 Datablist 好用:

- 真正的自然语言 prompting[4](不需要技术背景)

- 多个专用 AI agents,针对不同 scraping 任务优化[5]

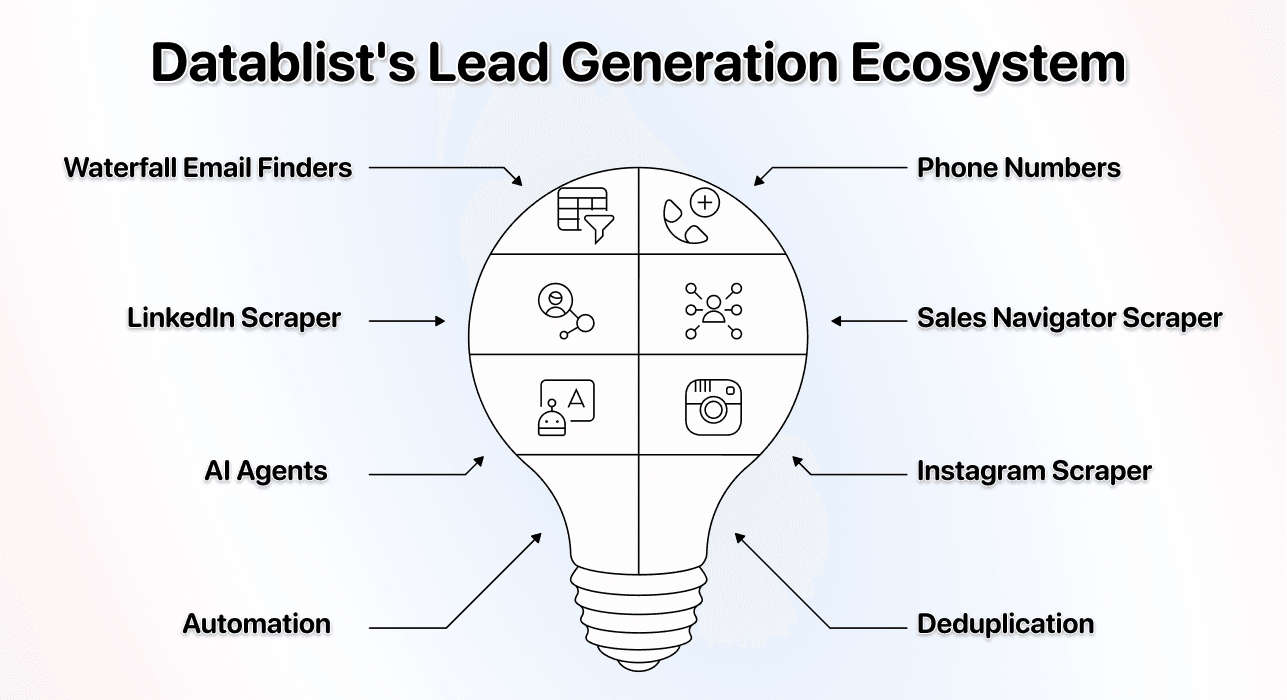

- 内置生态,包含 60+ lead generation 工具

- 自动处理 JavaScript 渲染与 pagination[6]

- 定价亲民,$25/月起

- 自带 bulk enrichment 能力

**差异点:**Datablist 不只是一个 AI scraper,而是完整的 lead generation 平台:包含 AI scraping,同时还有 email finder、sales navigator scraper 和清洗工具。你可以先 scrape 一份名单,然后立刻 enrichment 联系方式,不用在不同工具之间来回切换。

**Datablist 的核心优势:**你获得的不仅是 AI scraping,还有一套面向 data enrichment、lead list building 等工作流的自动化平台,整体成本通常比很多单一 scraping 工具更低。

📘 AI Scraping 也属于 No-Code Scraping

从定义上说,AI scraping 是 no-code scraping 的一个分支,因为你不需要任何 coding 技能。之所以它更“简单”,是因为你只要用自然语言下指令,而不是理解网页结构。

Traditional No-Code Scraping (Click-and-Point Tools)

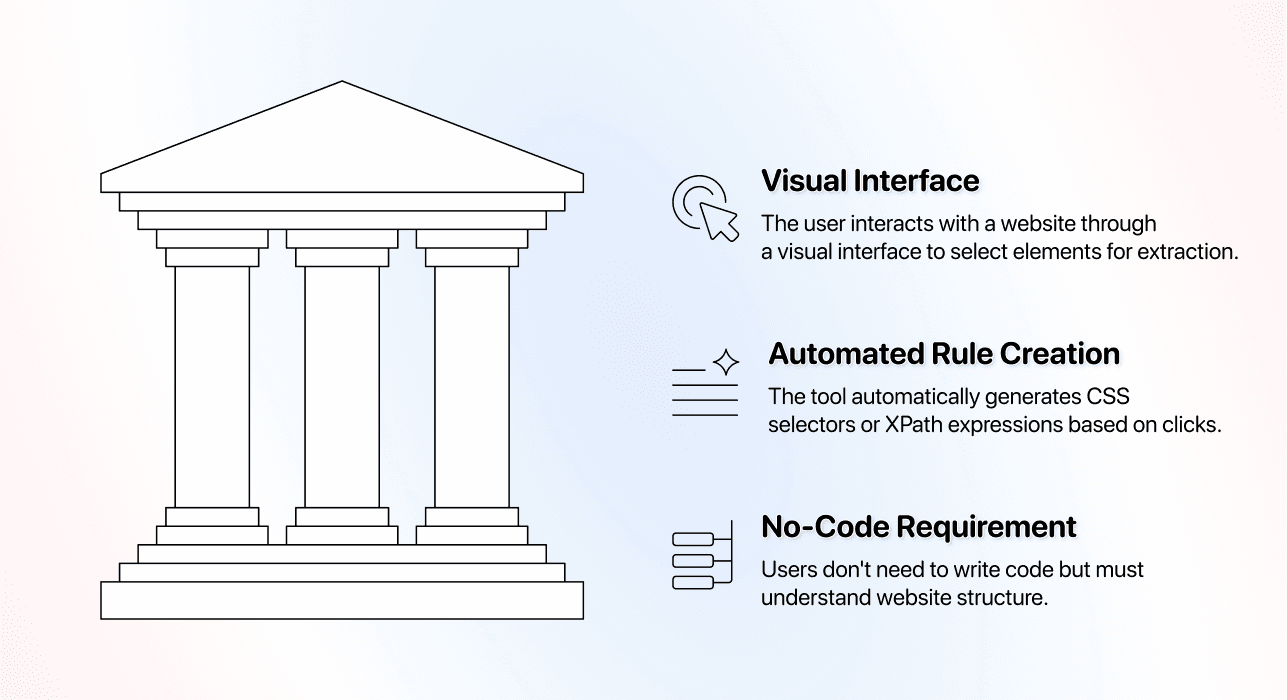

Click-and-point scraper 是最早一批“no-code”解决方案:你用鼠标在页面上点选数据,而不是写代码。在本节中,我们也把它称为“传统 no-code scraper”。

传统 No-Code Scraper 的核心理念

传统 no-code scraping 依赖可视化界面:你在网页上点击元素,告诉工具要提取什么。

**基本流程:**你在工具内打开网站,依次点击商品名、价格、描述等字段。工具会记录你的点击动作,并根据这些选择生成 scraper。

**背后发生了什么:**工具会把你的点击转换成 CSS selectors 或 XPath 规则。你虽然没写代码,但你实际上在创建一套“强依赖 HTML 结构”的硬规则。

**为什么也叫 no-code:**你不用写 Python 或 JavaScript,但你仍然需要理解网站信息是怎么组织的,有时还得排查为什么元素选不对。

上手难度

Click-and-point 工具的学习曲线属于“中等偏上”,很多新手会低估它。

搭建流程:

- 下载并安装工具(很多是桌面端软件)

- 在工具里打开目标网站

- 点选你要提取的每个数据点

- 需要的话配置 pagination 规则

- 测试抓取结果是否正确

- 元素选错时进行 debug

- 保存并运行 scraper

**时间成本:**中等复杂的网站一般要 30–60 分钟。

❗️ 注意这个坑

Click-and-point 工具有个隐藏复杂度:元素不一定能被正确选中。有时候你点的是手机号,结果选中的是整个联系信息模块,而且你还不一定能修复——因为问题可能出在网站本身的结构上,而不是你的配置。如果遇到这种情况,抓取之后通常需要再做数据清洗。

传统 no-code scraper 常见的新手挫败点:

- 点一个元素却选中了完全不相关的内容

- 不停找客服支持变成日常

- pagination 规则不按预期工作

- 数据混在一起,无法分字段

- 网站更新后 scraper 直接失效

**谁会觉得简单:**对技术比较熟、愿意看教程的人能掌握 click-and-point 工具。但通常需要花几个小时学习,才能进入高效使用状态。

灵活性

Click-and-point 工具天生就“偏刚性”:它只会按你配置的方式提取数据。

一旦网站变化会怎样:

↳ 页面改版会让 scraper 直接报废

↳↳ 很小的 CSS 调整也可能导致抓取失败

↳↳↳ 你往往得从头重建 scraper

**维护成本:**网站更新很频繁。常见电商站点可能每个季度就会变一次。每次变动都意味着你要重新配置,而这个时间通常和第一次搭建差不多。

**抓多个网站时:**你要抓 5 个竞品网站,就得做 5 套不同配置。每个网站更新都会独立导致对应 scraper 失效。

**它的优势:**当网站长期稳定(例如某些政府数据库或结构固定的目录站),click-and-point 工具一旦配置正确,确实能稳定、可重复地输出一致数据。

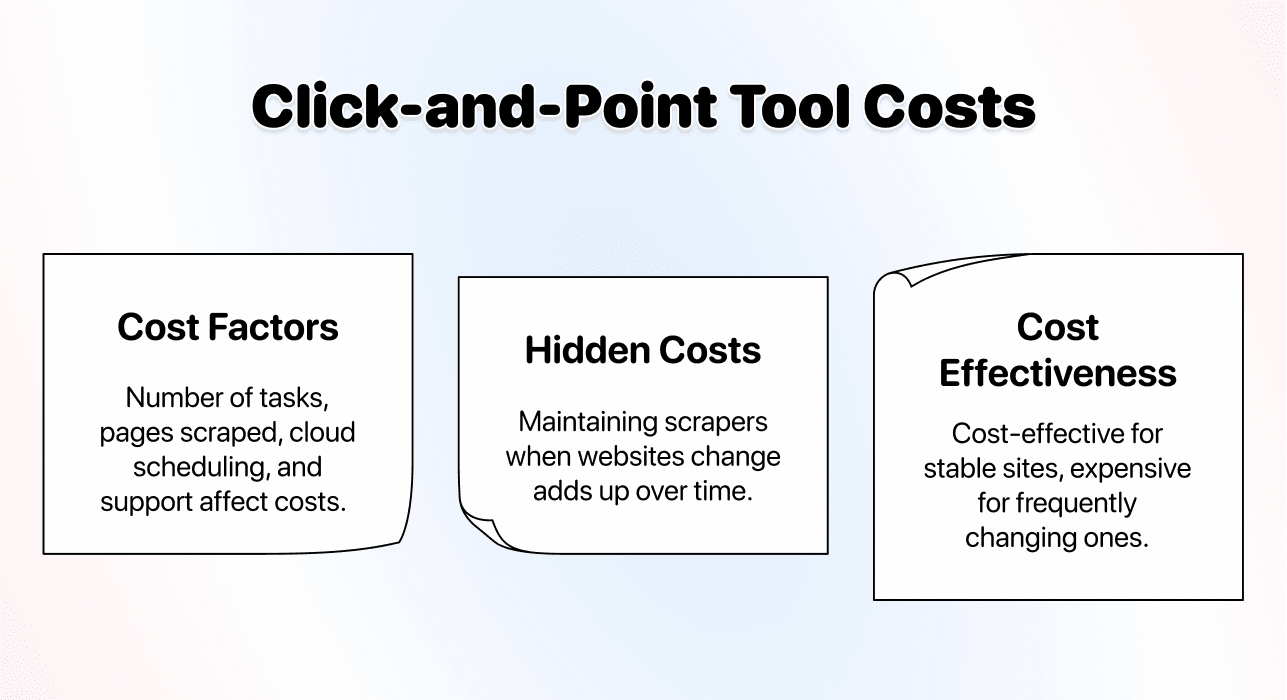

价格

Click-and-point 工具通常是订阅制,并按功能分档。

常见价格区间:

- 入门版:$50–100/月

- 专业版:$150–300/月

- 企业版:$500+/月

影响成本的因素:

- 你能创建多少个 scraping 任务

- 每月可抓取的页面数量

- 是否支持云端定时任务

- 高优先级支持与高级功能

**容易被忽略的隐性成本:**网站更新后你用于维护的时间也是真金白银。比如你每个月要花 5 小时修复坏掉的 scraper,即便订阅费不高,综合成本也会很可观。

**性价比结论:**对于很少变化的网站,click-and-point 工具在搭好后可能很划算;但对于变化频繁的网站,维护时间会让它变得昂贵。这种情况下,你可以考虑用 AI scraping agent。

使用场景与最佳实践

当场景不会触发它的短板时,click-and-point 工具表现非常好。

最佳使用场景:

- 抓取长期稳定、很少更新结构的网站

- 你需要对提取逻辑进行精细控制

- 反复抓同一个网站

- 偏桌面端工作流,不需要云端工具

**什么时候 click-and-point 是正确选择:**你要抓一个政府数据库,它每天更新数据,但页面结构几乎不变。一旦配置正确,click-and-point 工具就能每天稳定抓到新数据(前提是工具能在你点选时正确提取到你要的字段)。

最佳实践:

- 记录 scraper 配置细节,方便出问题时快速复原

- 做监控,尽早发现 scraper 停工

- 为每月维护预留时间

- 在扩大量级前彻底测试

**什么时候不要用 click-and-point:**如果你要抓多个经常更新的现代网站(例如电商),维护会非常痛苦。每次改版都需要你手动介入。

最推荐的工具

Octoparse 是市场上最成熟、最知名的 click-and-point scraping 工具之一。

另外,这里有一篇更新的文章:我对比了 最佳 no-code scrapers(按易用性、集成与定价) 👈🏽

为什么是 Octoparse:

- 界面成熟,迭代多年

- 常见场景教程非常全

- 桌面端应用,功能强

- 文档与社区支持相对完善

**代价:**Octoparse 需要投入时间学习。功能强但界面复杂。定价从 $83/月起,对个人或小团队不算便宜。

**适合谁:**有一定技术舒适度、需要经常抓稳定网站的团队,并且能接受学习成本与订阅费用。

💡 传统 Scraper 依然有它的位置

Click-and-point 工具并不差,只是现在有了 AI scraping 这种更省事的方法后,它的“黄金时代”过去了。但对于政府目录这类多年不变的网站,它依旧很好用。

API Based Scraping

API-based scraping 处在“代码”和“no-code”之间:严格来说你不需要写 scraping 逻辑,但你需要一定技术基础才能用好。

核心理念

API-based scrapers 提供预先搭好的 API endpoint,专门用于某些网站或某类场景的抓取。

**它怎么工作:**你发起一次 API 请求(带上参数,比如要抓取的 URL、需要哪些字段),服务端返回结构化数据。抓取逻辑已经写好了,你要做的是通过 API 参数进行配置。

**从定义看它接近 no-code,但你需要懂:**如何发 API 请求、处理认证 token、解析 JSON 返回,并把结果接入你的工作流。这通常需要编程能力,或者至少能熟练使用 Postman 之类工具。

常见 API scraping 方式:

- 特定网站的 API(例如某些 LinkedIn scraper APIs)

- 通用 scraping API(对任意 URL 生效)

- 模板化 API(内置热门网站的预设 scraper)

**关于命名的争议:**有人叫它 no-code(因为你没写抓取逻辑),也有人叫 low-code(因为你需要技术技能)。更准确的说法是:它介于两者之间。

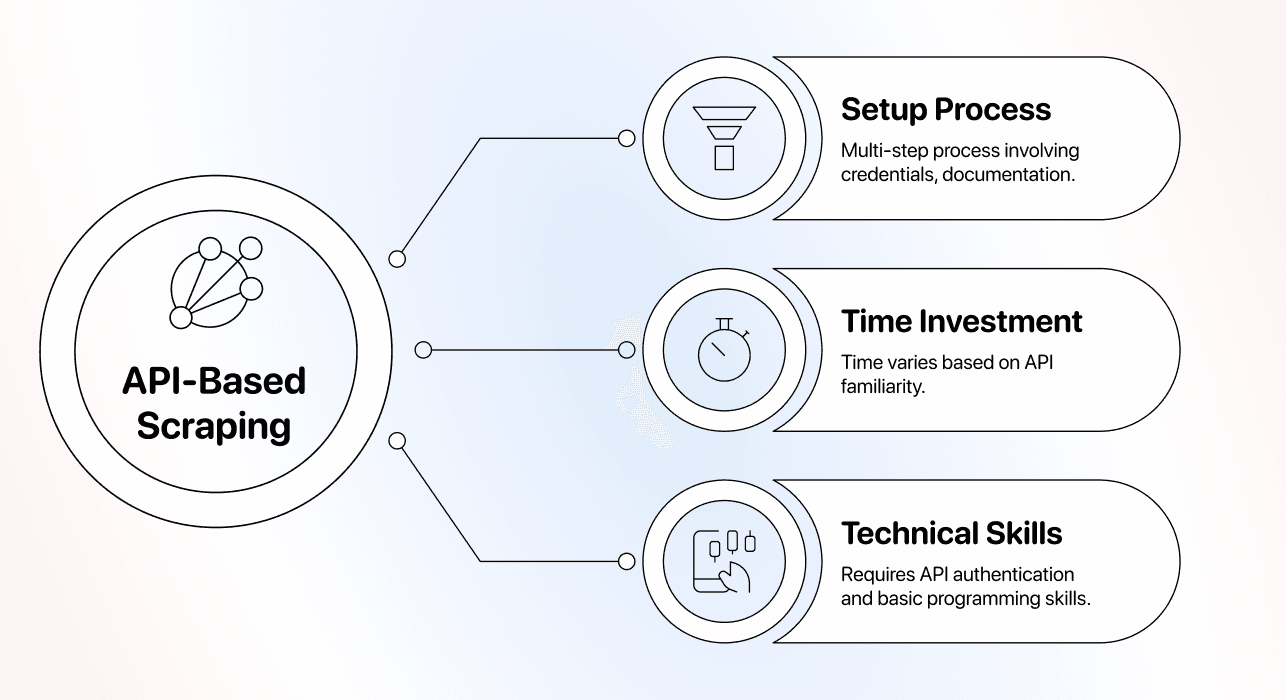

上手难度

API-based scraping 的技术门槛,通常让它很难算“纯 no-code”。

搭建流程:

- 注册并获取 API credentials

- 阅读文档,理解参数与限制

- 用 Postman 或 curl 测试请求

- 处理认证与 rate limiting

- 解析 JSON 或 XML 响应

- 把结果接入你的应用或工作流

- 为失败请求做 error handling

**时间成本:**如果你熟悉 API,大约 1–2 小时;如果边学边做,会久很多。

需要的技术能力:

- 理解 REST API 与 HTTP 请求

- 能处理 JSON 数据结构

- 会用 token、header 等认证方式

- 有基础编程能力把结果集成到流程里

灵活性

API-based scrapers 的灵活性属于“中等”,而且完全取决于服务商。

**你能控制什么:**多数 API 允许你指定提取字段、设置速率、选择输出格式,并通过参数调整部分行为。

**你控制不了什么:**底层抓取逻辑是黑盒。API 不支持某个网站或数据类型,你就没办法改它。

**网站变化时:**优秀的 API 提供商会自动维护并适配网站更新;不靠谱的提供商可能几周不更新,导致你的流程一直坏着。

**依赖风险:**你完全受制于提供商。如果对方停服、涨价、或停止维护某些 scraper,你的工作流会直接断裂。

**什么时候“灵活性”最关键:**当你要抓的网站 API 不支持,或你需要的提取方式 API 不允许,你就没有空间了。这时定制 scraper 或 AI scraping 可能更合适。

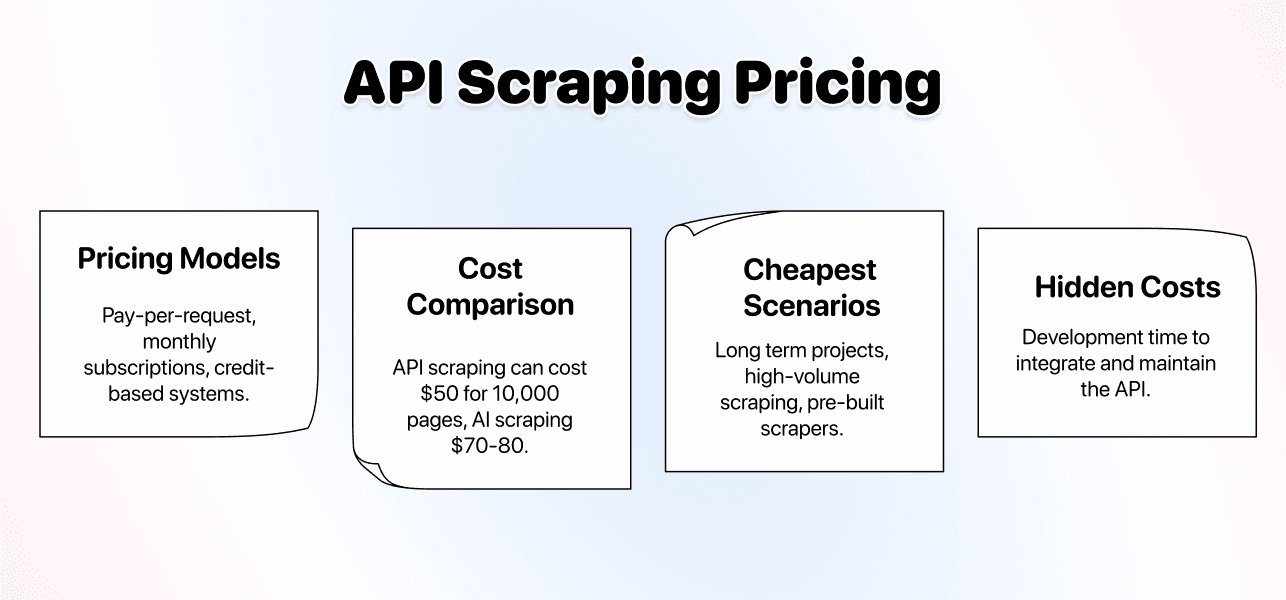

价格

对于高频、规则明确、页面简单的抓取任务,API-based scraping 往往是最省钱的。

常见计费方式:

- 按请求计费(通常每次成功抓取只要几分钱)

- 包月订阅(含一定请求量)

- credits 体系(量大有折扣)

**成本对比参考:**如果你每月抓取 10,000 个简单页面,API 方案可能只要 $50。相同量级用 AI scraping 可能是 $70–80,但搭建时间会少很多。

什么时候 API scraping 最便宜:

- 长周期项目,开发投入不是主要问题

- 大量抓取简单、稳定的网站

- 使用热门网站的预置 scraper

**什么时候会变贵:**当你需要的抓取更“定制化”,但 API 支持不好,你会在调试与试错上浪费大量时间和预算。原本“便宜”的方案,可能直接变成不可用。

**隐性成本:**集成与维护 API 的开发时间。如果你不懂技术,就得找人做,成本结构会瞬间改变。

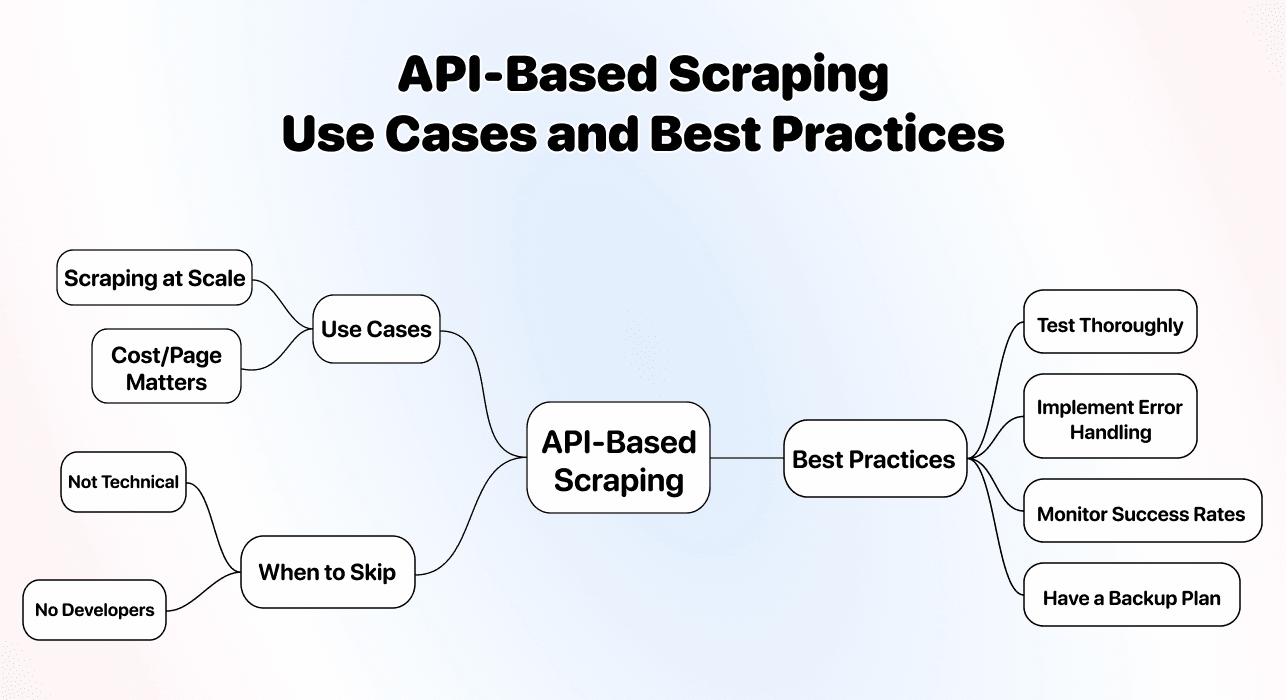

使用场景与最佳实践

API-based scraping 最适合技术团队做高频、重复性强的抓取。

最佳使用场景:

- 大规模抓取(成千上万甚至百万级页面)

- 把抓取嵌入到产品或内部系统

- “每页成本”比“易用性”更重要

最佳实践:

- 正式绑定供应商前,充分测试

- 做好失败请求的错误处理

- 监控成功率,及时发现 scraper 失效

- 准备备选方案,以防供应商停服或改条款

**什么时候别选 API scraping:**如果你不懂技术、团队也没有开发,API scraping 会让你很痛苦。你省下来的钱没有意义,因为你根本落不了地。

最推荐的工具

API-based scraper 的“最佳选择”取决于你要抓什么,但下面这些是比较稳的选项:

-

**通用 web scraping:**ScrapingBee 和 Bright Data 通常比较可靠,能自动处理 proxies、浏览器渲染和反爬策略。

-

**特定平台:**选择专门的 APIs(LinkedIn scrapers、Amazon scrapers 等)。它们会针对平台做优化,处理该站点特有的挑战。

选择时重点看:

- 文档是否清晰,示例是否完整

- 稳定性与支持响应

- 定价透明,没有隐藏费用

- 对你目标网站的成功率

**现实情况:**即便是最好的 API-based scrapers,也需要技术能力。如果“发 API 请求”听起来就很复杂,那就选 AI scraping——它通常能带来更高的可控性与更强的安心感。

💡 API Scraping 省钱但更吃技术

API-based scraping 在大规模项目里每页成本最低,但想用得好必须有技术能力。不要只因为便宜就选它——如果你实现不了,省下来的钱都是假象。记住一句老话:买得便宜,往往要付两次钱。

最终结论:到底该选哪一种?

把三种方法对比完后,你可以按下面的标准快速做决定。

选择 AI Scraping 的情况

- 你不懂技术,想要最省事的方案

- 你的维护时间很贵

- 目标网站经常改版、更新频繁

- 你希望随时调整提取字段而不想重做配置

**最适合:**非技术用户、小团队、lead list building、市场调研、竞品分析(competitive intelligence),以及“时间与易用性比每页省几分钱更重要”的项目。

**最佳工具:**Datablist(自然语言指令的真正 no-code 体验)。

选择 Click-and-Point 工具的情况

- 你抓取的网站非常稳定、很少变结构

- 你愿意学习一些技术概念

- 网站更新时你能接受做维护

- 你更喜欢桌面端应用,而不是 web-based 工具

**最适合:**具备一定技术舒适度的团队、稳定的政府/机构网站,以及“配置时间不是主要问题”的项目。

**最佳工具:**Octoparse(功能成熟,资料完善)。

选择 API-Based Scraping 的情况

- 你有技术能力,或团队里有开发

- 你需要高频抓取(每天上千页甚至更多)

- 你最关心的是每页成本

- 你需要把抓取集成到应用或系统里

**最适合:**技术团队、高并发抓取、应用集成、开发时间充足且“单位成本优先”的场景。

**推荐工具:**通用抓取选 ScrapingBee 或 Bright Data;特定平台则选专门的 APIs。

大多数人的推荐选择

**对 80% 的用户来说,AI scraping 都是最合适的选择。**它的易用性、灵活性和几乎零维护,足以抵消每页成本略高这一点。

no-code scraping 已经变了。以前要靠技术能力或花几个小时配置的事,现在只要把需求说清楚,几分钟就能跑起来。

下面是 3 个最简单的理由,说明为什么建议你优先从 AI scraping 开始:

- 上手最简单

- 灵活性最强

- 几乎不需要维护

如果后续你要把量级提升到每天 10,000+,再切换到 API-based scrapers 做成本优化也不迟。

Frequently Asked Questions

最高效的 No-Code Scraping 方法是哪一种?

“高效”要看你衡量的是哪种效率。如果你是技术团队、且需要高并发抓取,API-based scraping 在成本效率上最好。若你不懂技术,AI scraping 在搭建与维护的时间效率上最强。对大多数人来说,AI scraping 通过消除技术门槛和维护工作,提供了整体最优的效率。

AI Scraping 比 No-Code Scraping 更好吗?

AI scraping 本身就是 no-code scraping 的一种,只是更先进。大家常问的其实是:“AI scraping 比 click-and-point 工具更好吗?”大多数场景答案是肯定的。AI scraping 能自动适配网站变化,对技术要求更低,维护更少,综合成本也往往低于 click-and-point 工具。

AI Scraping 很贵吗?

AI scraping 的单页成本通常比 API-based 方法更高,但往往低于 click-and-point 工具的综合成本(尤其把维护时间算进去)。例如抓取 1,000 条目录 listing,通常会消耗 800–1,200 credits(具体取决于工具和页面复杂度)。它的价值在于几乎零维护、无需技术知识,能为非技术用户省下大量时间和人力成本。

什么是 AI No-Code Scraping?

AI no-code scraping(也就是 AI scraping)指用人工智能从网站提取数据,而不需要写代码或配置技术 selector。你用自然语言描述你要的数据,AI 理解意图并处理技术细节。它把 no-code 的易用性和 AI 的自适应能力结合起来,能自动适配不同网站结构。

可以把多种 Scraping 方法混合使用吗?

可以,而且很多团队就是这么做的。用 AI scraping 做探索性工作、新网站验证、或需要高灵活性的场景;当你确定某些任务是高频、重复、且规则稳定的,再把这些任务切到 API-based 方法来降低成本。但要考虑到:你会接触更多技术概念,也需要投入集成与维护时间。