Je vais faire une affirmation audacieuse, mais assumée.

Cet article va changer votre façon d’évaluer et de penser les scrapers no-code. Voici pourquoi :

L’IA a bouleversé tout ce que l’on savait du no-code scraping, mais la plupart des comparatifs utilisent encore d’anciens critères. Si les règles du jeu changent, les critères doivent changer aussi.

Entrons dans le vif du sujet.

📌 Résumé pour les pressés

Cet article classe les meilleurs scrapers no-code avec de nouveaux benchmarks centrés sur l’utilisateur, plutôt que de les comparer au code. Si vous êtes pressé, voici l’essentiel :

Problème : La plupart des comparatifs de scrapers no-code utilisent des critères dépassés, en les comparant au code plutôt qu’à la vraie simplicité d’usage.

Pourquoi c’est un problème : Quand vous cherchez un outil no-code, vous voulez quelque chose d’aussi simple que faire cuire des œufs, pas juste « plus simple que Python ».

Solution : De nouveaux benchmarks qui mesurent la vraie facilité d’usage (simplicité en 3 étapes), l’utilité (ce que l’outil permet réellement) et le prix (abordable pour les individus et petites équipes).

Ce que vous allez apprendre : Comment évaluer les scrapers no-code avec les bons critères, des tests détaillés des 5 meilleurs outils, et lequel convient le mieux à votre besoin.

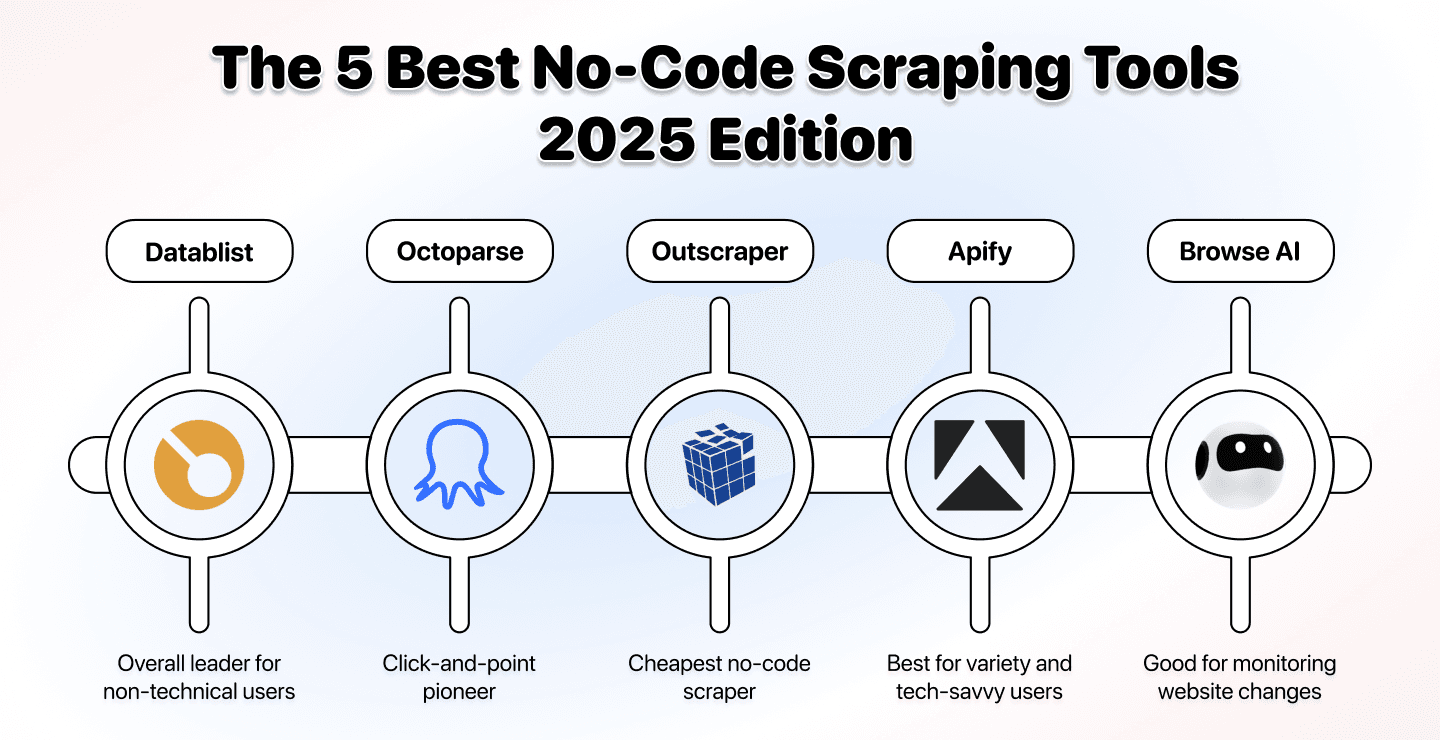

Le classement :

- Datablist - Meilleur choix global pour les non-techniques

- Octoparse - Pionnier du pointer-cliquer

- Outscraper - Entrée de gamme la moins chère

- Apify - Plus grand choix pour profils techniques

- Browse AI - Meilleur pour le monitoring des changements

Ce que couvre cet article

- Les 5 meilleurs scrapers no-code en un coup d'oeil

- Une nouvelle façon de définir « le meilleur outil »

- Tests détaillés des 5 meilleurs scrapers no-code 2025

- FAQ sur les scrapers no-code

Les 5 meilleurs scrapers no-code en un coup d'oeil

| Outil | Idéal pour | Facilité | Puissance | Prix | Atout majeur |

|---|---|---|---|---|---|

| Datablist | Scraping en anglais simple, écosystème complet, flexibilité | ●●●●● | ●●●●● | $25/mo | « Scrape this and get me emails » fonctionne vraiment |

| Outscraper | Google Maps, Pages Jaunes, option la moins chère | ●●●● | ●● | $10 | Entrée à $10, sans engagement |

| Octoparse | Interface visuelle, app desktop, tutoriels | ●●● | ●●●● | $83/mo | Meilleure interface pointer-cliquer |

| Apify | Énorme variété, flexibilité technique, presque tous les sites | ●● | ●●●● | $49/mo | 1000+ actors préconstruits |

| Browse AI | Monitoring de sites, suivi des prix, alertes | ●●● | ●●● | $49/mo | Détection des changements en temps réel |

🏆 Le vainqueur

Pour la plupart d’entre vous : Datablist l’emporte car c’est le seul outil vraiment no-code (anglais naturel), qui fonctionne sur n’importe quel site, et qui inclut 60+ outils de lead gen au meilleur prix (seulement $25/mo)

Guide d'achat: mieux choisir en redéfinissant « le meilleur outil »

Commençons par ce qui est, selon moi, la section la plus importante — et si je le dis, c’est parce qu’elle fixe le standard que devraient respecter les outils no-code.

Si vous avez déjà vos critères en tête, passez directement aux comparatifs. Sinon, prenez une minute : la plupart des articles « best no-code scraping tools » que vous lisez en ligne sont à côté de la plaque et ne sont plus à jour.

Voici le problème de fond :

↳ On a mal défini « facile à utiliser » depuis trop longtemps (le critère n°1 pour des scrapers no-code)

↳↳ La facilité d’usage ne devrait plus se comparer au code, mais à faire cuire des œufs ou lacer ses chaussures

↳↳↳ Quand vous cherchez un scraper no-code, vous ne voulez pas « plus simple que Python »

↳↳↳↳ Vous voulez quelque chose qui ne demande aucune compétence technique.

↳↳↳↳↳ AI scraping le permet en donnant des consignes en anglais naturel.

Viennent ensuite l’utilité et le prix, tout aussi clés pour déterminer le meilleur scraper no-code en 2025.

Facilité d’usage : le benchmark des œufs à la coque

Trop souvent, on compare la facilité d’usage… au code. Pour un public non technique, ça n’a pas de sens. Ici, on fait différemment : on la compare à faire cuire des œufs.

Faire cuire des œufs, c’est l’une des choses les plus simples :

- Mettre les œufs dans l’eau

- Attendre X minutes selon la cuisson souhaitée

- Sortir les œufs

Voilà : 3 étapes pour cuire des œufs.

Nouveau benchmark de facilité : 3 étapes. Au-delà, on retire des points.

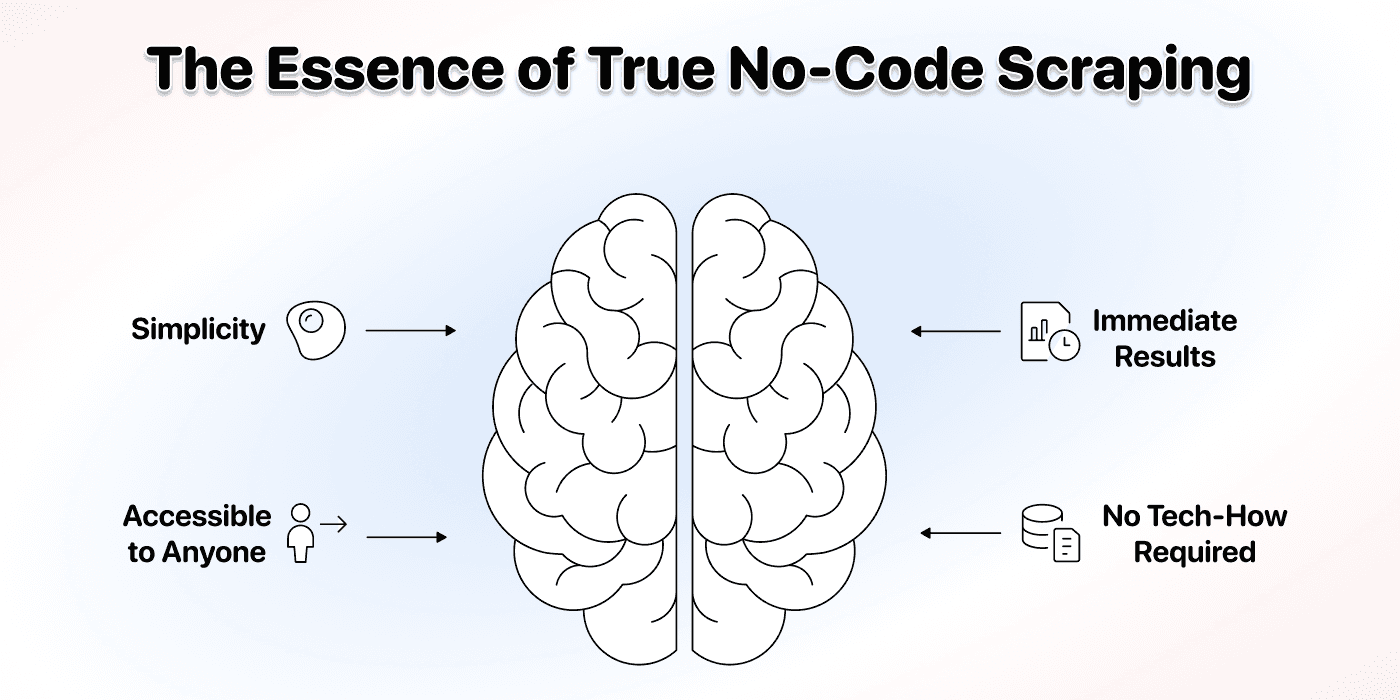

Vrai no-code ou pas ?

Deuxième volet de la facilité : devez-vous apprendre une compétence technique pour l’utiliser ?

Le vrai no-code, c’est :

- Aucun besoin de comprendre HTML, CSS ou JavaScript

- Aucun sélecteur DOM à manipuler

- Pas d’heures de tutoriels pour démarrer

- Pas de jargon technique

Si un scraper no-code vous force à comprendre l’architecture d’un site, pointer des éléments HTML, ou configurer des sélecteurs CSS, ce n’est pas du vrai no-code. C’est juste du code maquillé.

Utilité : ce que vous pouvez réellement faire

Définir l’utilité, c’est simple : que pouvez-vous faire avec l’outil ?

On évalue selon les besoins les plus fréquents :

- Scraper des sites complexes

- Récupérer beaucoup de données

- Automatiser des tâches récurrentes

Capacités avancées de scraping

L’outil sait-il gérer :

- Des sites très JavaScript qui chargent le contenu dynamiquement ?

- Des résultats paginés sur plusieurs pages ?

- Des navigations complexes et processus multi-étapes ?

Le rendu JavaScript est l’un des plus gros défis du scraping moderne, plus de 70 % des sites actuels s’appuyant dessus. Plus vous pouvez scraper de sites complexes, plus l’outil est utile.

Intégrations et écosystème

Personne ne scrape pour le plaisir ; on scrape pour faire croître son business. Il est donc logique que vous puissiez exploiter les données sans jongler entre 10 plateformes.

Les meilleurs scrapers no-code offrent :

- Une variété de scrapers selon les cas d’usage

- Des intégrations avec vos autres outils

- Des capacités d’enrichment (emails, mobiles, etc.)

Un scraper qui balance un CSV brut et vous laisse vous débrouiller est bien moins utile qu’un outil intégré à un écosystème de données complet.

Automatisations récurrentes

Vous n’avez pas envie de tout reconfigurer chaque jour.

Un bon scraper no-code doit permettre de :

- Planifier des runs automatiques

- Monitorer les sites et détecter des changements

- Construire des workflows chaînant plusieurs actions

Tarifs : pensés pour les humains, pas pour les administrations

Les meilleurs scrapers no-code ne servent à rien si leurs prix visent l’enterprise, pas les individus et petites équipes.

On évalue les tarifs selon :

- Le prix d’entrée (peut-on tester sans se ruiner ?)

- La transparence (coûts clairs ou cachés ?)

- La flexibilité (paiement à l’usage ou plans figés ?)

- La valeur (que recevez-vous pour ce prix ?)

Si un outil vous demande « contactez le sales » ou démarre à $500/mo, il n’est pas pensé pour la majorité des gens qui ont besoin de scraper.

Passons aux outils et voyons comment ils performent avec ces nouveaux benchmarks.

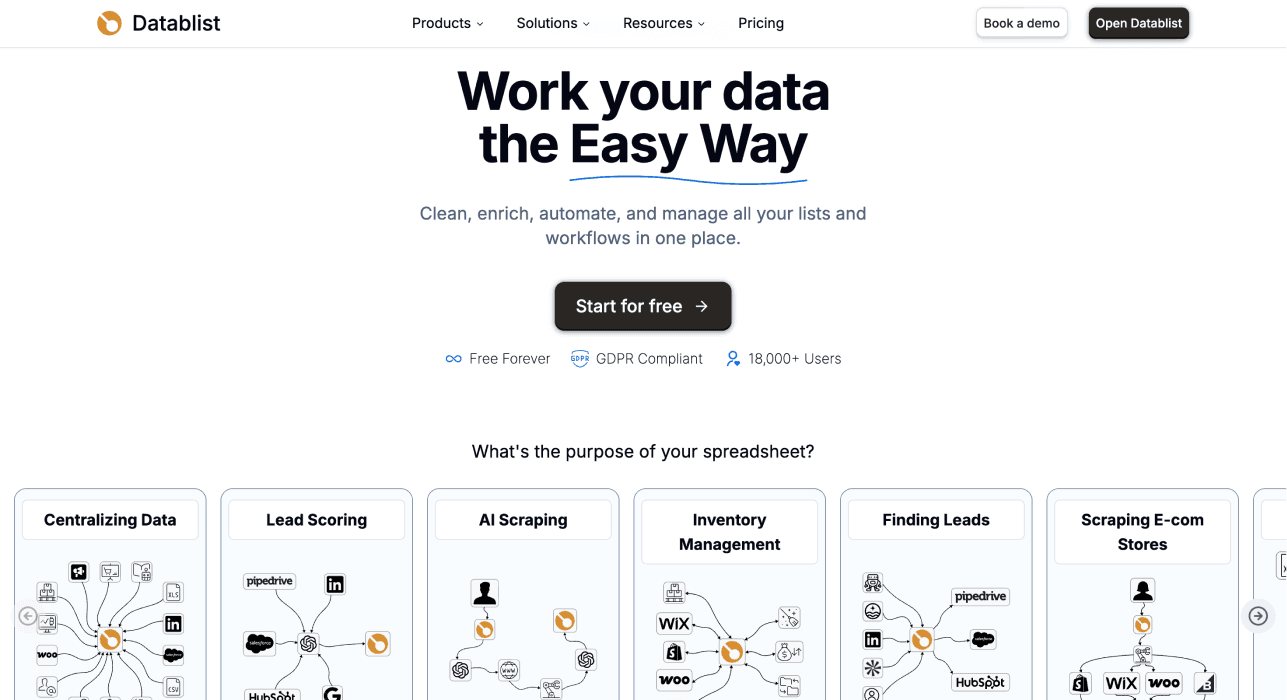

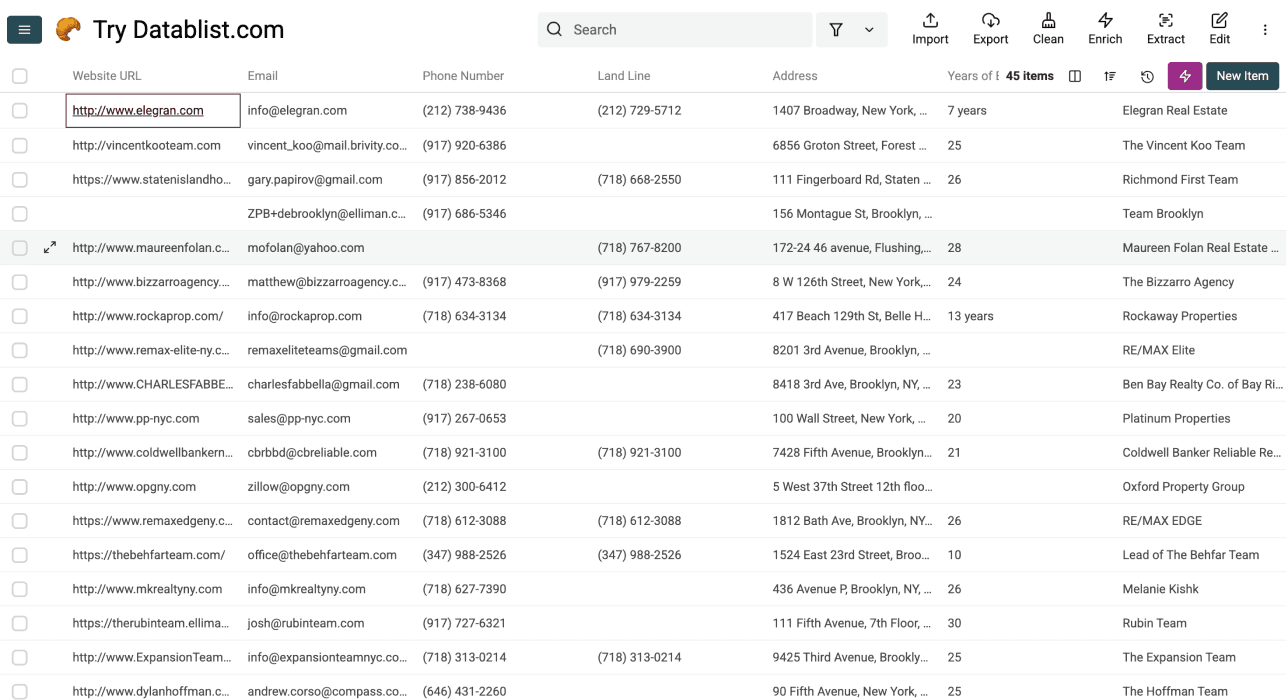

Datablist : le leader pour les non-techniques

Datablist n’est pas un scraper classique. En réalité, ce n’est même pas d’abord un scraper.

Datablist est une plateforme d’automatisation de workflows de génération de leads qui permet de trouver, clean et enrichir des données grâce à plus de 60 outils, des AI Agents aux Email Finders, en passant par les AI Processors, les Technology enrichments, et plus encore.

En plus, Datablist permet de construire des workflows automatisés qui tournent à la demande ou à la planification. Exemples adorés par les utilisateurs :

- Construire des listes de leads

- Personnaliser des emails avec l’IA

- Nettoyer et dédupliquer des CRMs

- Scraper des offres d’emploi sur 19 job boards en une fois

- Scraper des recherches LinkedIn Sales Navigator sans risquer votre compte

La différence majeure : Datablist a été conçu pour éliminer toute friction technique. Au lieu de vous faire comprendre la structure des sites ou cliquer des éléments HTML, Datablist s’appuie sur de l’IA qui comprend des consignes en anglais naturel.

📘 Résumé Datablist

Idéal pour : Les non-techniques qui veulent un vrai no-code scraping + un écosystème complet de lead generation incluant enrichment, cleaning, deduplication et automatisation.

Forces clés

- AI-powered scraping en anglais naturel, sans compétences techniques

- Plus de 60 outils de lead generation sur une plateforme

- Support rapide et réactif

Tarifs : À partir de $25/mo avec 5 000 crédits inclus chaque mois

Facilité d’usage : ⭐⭐⭐⭐ (4/5) - Sans le process d’inscription, Datablist respecte le benchmark en 3 étapes pour les cas templates. Pour les cas « custom », on est à 4 étapes.

Utilité : ⭐⭐⭐⭐⭐ (5/5) - Scrape n’importe quel site sans login, + 60+ autres outils

Prix : ⭐⭐⭐⭐⭐ (5/5) - Le plus abordable avec un système de crédits flexible

Facilité d’usage : la note de Datablist

Datablist respecte le benchmark en 3 étapes :

- Sélectionner l’AI Agent et un template préconstruit

- Définir les limites et choisir les outputs

- Lancer le scraper

Aucune compétence technique. Pas d’HTML ou de CSS. Pas de clics sur le site.

Une interface type tableur, familière dès le premier jour

Datablist utilise une interface façon tableur que toute personne ayant utilisé Excel ou Google Sheets maîtrisera immédiatement. Zéro courbe d’apprentissage côté interface.

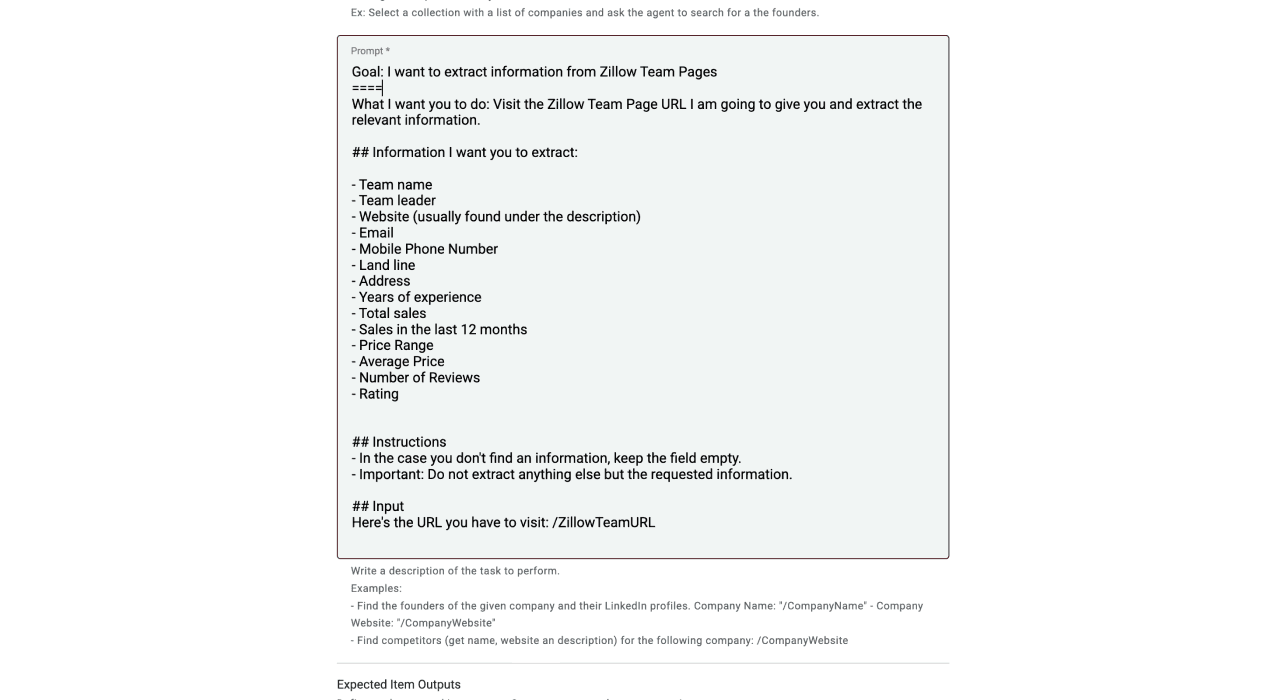

Les AI Scrapers ne demandent que du langage naturel

C’est ce qui rend l’expérience si simple. Plutôt que de configurer des sélecteurs ou cliquer des éléments, vous dites à l’IA ce que vous voulez : « Va sur ce site et extrait le nom de l’entreprise, l’adresse et l’email »

C’est tout. L’IA se charge de naviguer et d’extraire les données.

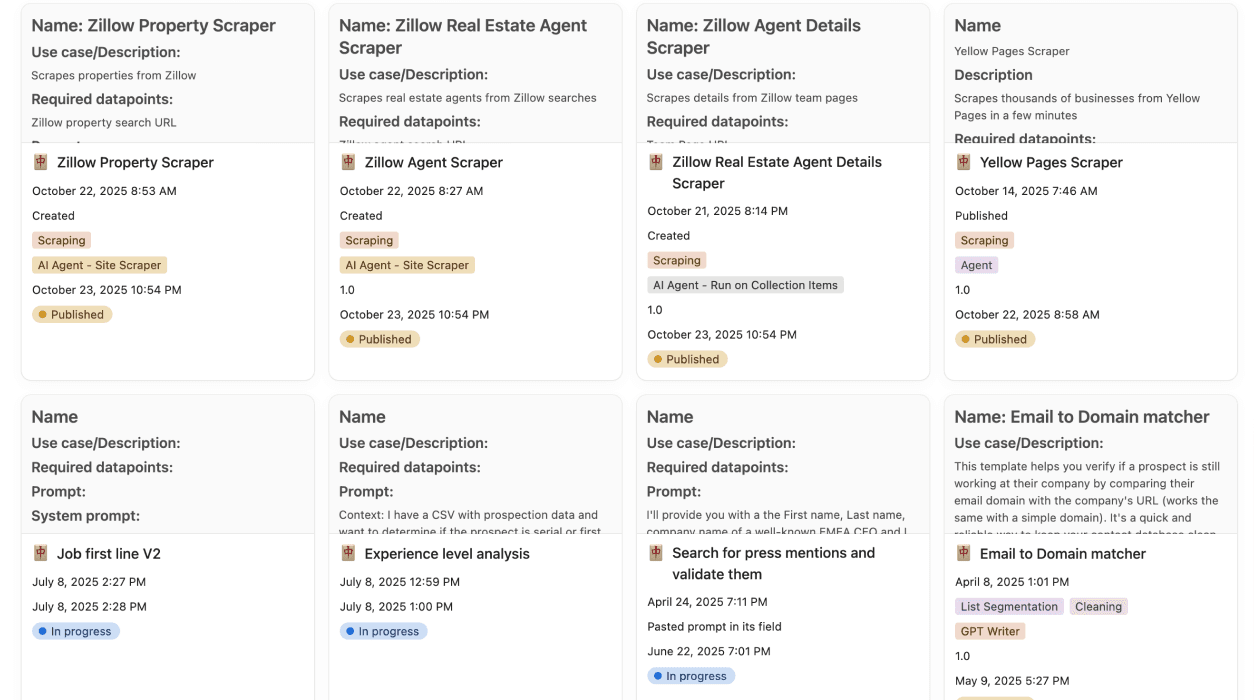

De nombreux templates prêts à l’emploi, configurables

Pour les cas fréquents, Datablist propose des templates :

- Scraper des entreprises depuis Pages Jaunes

- Scraper des biens depuis Zillow

- Scraper des biens depuis Airbnb

- Scraper des produits de boutiques Shopify

- Scraper des case studies sur des sites

Mais, contrairement aux outils 100 % templates, vous pouvez personnaliser ces templates en anglais simple si vous avez besoin d’autres champs.

Utilité : ce que Datablist permet

3 AI Agents pour des tâches différentes

Datablist propose plusieurs AI Agents optimisés selon les scénarios. Deux agents pour sourcer des données, et un agent pour rechercher, trouver, extraire, voire répondre à des questions.

- AI Scraping Agent : Optimisé pour scraper un site unique en profondeur

- **AI Research Agent:** Peut chercher sur plusieurs sources et scaler la recherche IA sur des listes

- AI Agent - Run on Collection Items : Research agent qui sourcera et recherchera des infos sur les items d’autres collections

Peut scraper n’importe quel site

Tant que le site n’est pas derrière un login, les AI Agents de Datablist gèrent :

-

Les sites très JavaScript (avec l’option « Render HTML »)

-

Les annuaires paginés

-

Les navigations complexes

-

Les catalogues e-commerce

-

Les listings d’annuaires

Enrichment, cleaning et déduplication avancée

Au-delà du scraping, Datablist propose 60+ outils :

- Waterfall Email Finders : Retrouver des emails vérifiés

- Mobile Phone Number Enrichments : Obtenir des numéros directs

- LinkedIn Scraper : Extraire des profils LinkedIn

- Sales Navigator Scraper : Scraper Sales Navigator en sécurité

- AI Processors : Transformer et clean des données avec l’IA

- Deduplication Tools : Retirer les doublons intelligemment

- Technology Enrichments : Identifier la stack technique des entreprises

Résultat : vous pouvez scraper une liste, l’enrichir avec emails et mobiles, la nettoyer et la préparer pour votre outreach, le tout sur une même plateforme.

Les enrichments de Datablist

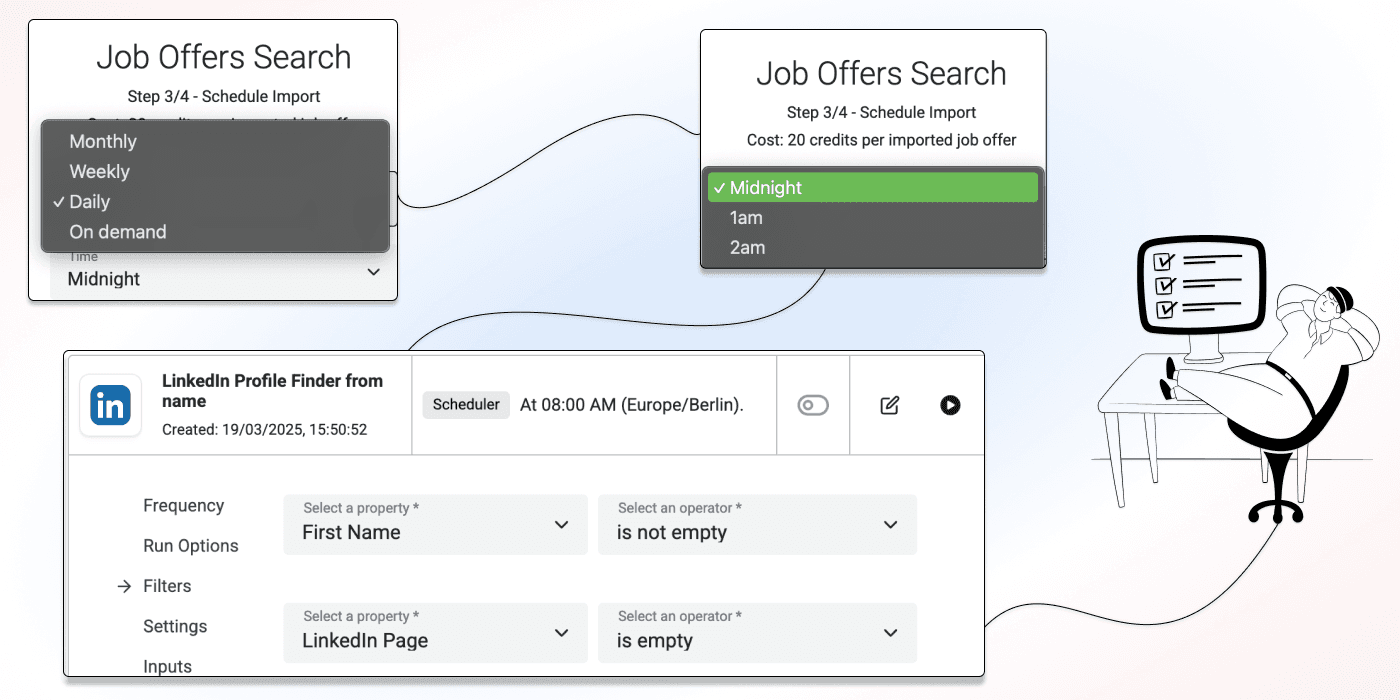

Automatisations récurrentes

Datablist vous permet de construire des workflows automatisés qui tournent selon un planning ou à la demande. Vous pouvez chaîner plusieurs actions :

- Scraper un annuaire chaque jour

- Trouver les sites des nouvelles entrées

- Enrichir avec les données entreprises

- Exporter vers votre CRM

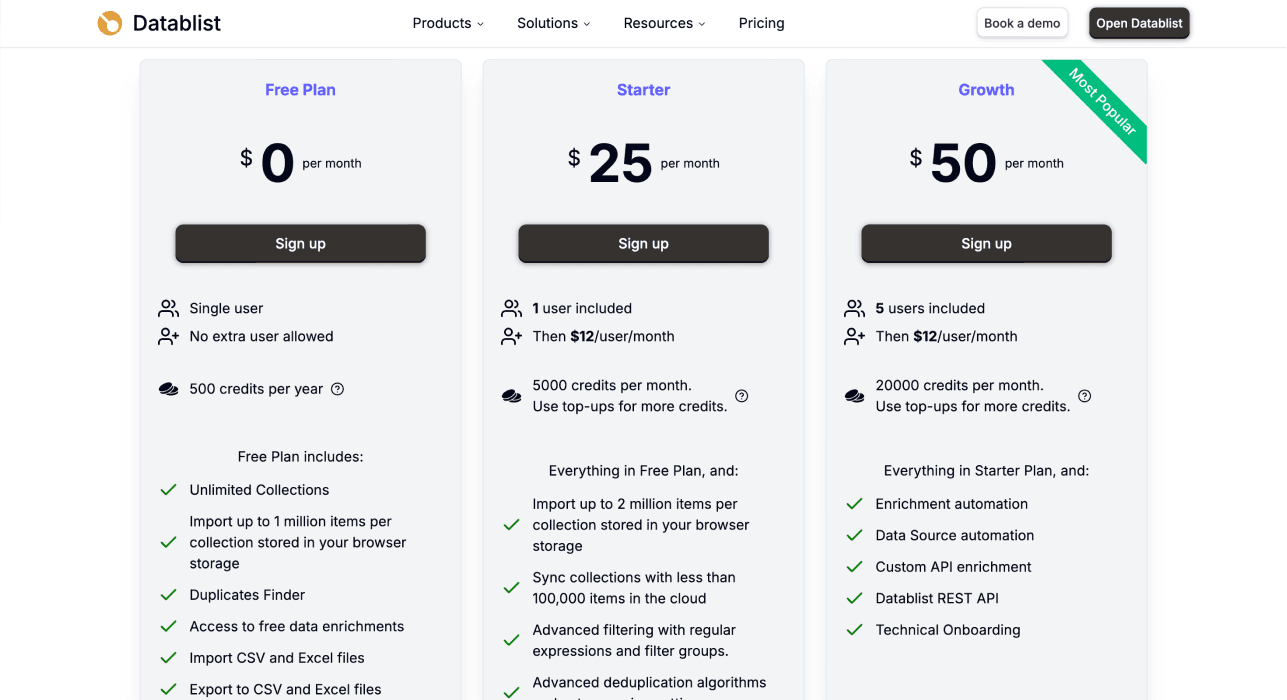

Tarifs : transparents et flexibles

Prix d’entrée : $25/mo

Ce que vous obtenez :

- 5 000 crédits gratuits inclus chaque mois

- Accès à 60+ outils de la plateforme

- Recharges flexibles de crédits (sans upgrader tout le plan)

- Pas de commerciaux insistants

Système de crédits :

- Tarification à l’usage

- Vous ne payez que les opérations réussies

- Coût variable selon la complexité (un annuaire coûte moins cher qu’un site très JS)

- Exemple : Scraper 700 propriétés Zillow coûte environ 1 000–1 500 crédits

Pourquoi ce modèle tarifaire fonctionne

Contrairement aux concurrents qui vous enferment dans des plans mensuels onéreux, le système de crédits flexible de Datablist permet :

- De démarrer petit et tester à fond

- Plus de crédits ? Achetez une recharge ponctuelle au lieu d’upgrader

- Aucun engagement long terme

Octoparse : le pionnier du pointer-cliquer

Octoparse est l’un des pionniers du web scraping visuel. C’est un outil pointer-cliquer vraiment no-code au sens où vous n’écrivez pas de code. Mais vous devez quand même comprendre la structure des sites pour bien l’utiliser.

📘 Résumé Octoparse

Idéal pour : Les utilisateurs à l’aise avec une interface visuelle et prêts à apprendre la structure des sites

Force clé : Interface point-and-click mature avec bonne doc et beaucoup de tutoriels

Tarifs : À partir de $83/mo

Facilité d’usage : ⭐⭐⭐ (3/5) - Demande de comprendre la structure des sites

Utilité : ⭐⭐⭐⭐ (4/5) - Gère la plupart des sites mais casse quand la structure change

Prix : ⭐⭐ (2/5) - Cher pour individus et petites équipes

Facilité d’usage : la courbe d’apprentissage

Octoparse ne respecte PAS le benchmark en 3 étapes. Le flux type :

- Télécharger et installer l’app desktop

- Ouvrir le site à scraper

- Cliquer les éléments à extraire pour l’« apprendre » à Octoparse

- Configurer la pagination et la navigation

- Tester et débugger

- Lancer l’extraction

La complexité cachée

Sans écrire de code, vous devez quand même :

- Identifier les bons éléments HTML

- Comprendre les variantes de pagination

- Dépanner quand la mauvaise donnée est sélectionnée

- Regarder des tutos pour assimiler les bonnes pratiques

Problème majeur : Quand le site change sa structure, vous devez tout reconfigurer. Donc re-tutoriels et re-build du scraper.

Pas de web app disponible

Il faut télécharger et installer Octoparse sur votre ordinateur. Pas d’option 100 % navigateur, ce qui ajoute de la friction au démarrage.

Utilité : ce que peut faire Octoparse

Compatible avec la plupart des sites

Octoparse peut scraper :

- Des sites HTML statiques

- Des pages très JavaScript (rendu intégré)

- Des annuaires paginés

- Des sites avec chargement AJAX

Écosystème limité

Octoparse se concentre surtout sur le scraping. Pour l’enrichment ou la recherche de contacts, il faut exporter et passer par d’autres outils.

Automatisation cloud

Les plans supérieurs incluent du cloud scraping, pour planifier des runs automatiques sans laisser votre ordinateur allumé.

Tarifs : positionnement premium

Prix d’entrée : $83/mo (facturé annuellement)

Ce que vous obtenez :

- Application desktop

- Nombre limité de tâches et de pages par mois

- Fonctionnalités d’automatisation basiques

- Cloud scraping seulement sur les niveaux supérieurs

Pourquoi ce prix est un frein

À $83/mo, Octoparse est hors budget pour beaucoup d’individus et petites équipes qui scrappent ponctuellement. La valeur existe pour les gros volumes, mais la barrière d’entrée est haute.

Outscraper : l’option template économique

Outscraper est un service de scraping basé sur des templates centré sur des plateformes populaires (Google Maps, Pages Jaunes, réseaux sociaux…). Ils proposent aussi des API.

📘 Résumé Outscraper

Idéal pour : Ceux qui ne doivent scraper que des annuaires supportés et veulent l’option la moins chère

Force clé : Prix d’entrée très abordable et templates prêts à l’emploi pour les annuaires connus

Tarifs : À partir de $10, achat de crédits ponctuel

Facilité d’usage : ⭐⭐⭐⭐ (4/5) - Très simple si votre besoin colle à un template

Utilité : ⭐⭐ (2/5) - Limité aux templates (et API) existants

Prix : ⭐⭐⭐⭐⭐ (5/5) - Meilleure entrée de gamme

Facilité d’usage : simple mais limitée

Outscraper respecte le benchmark en 3 étapes si votre cas colle à un template :

- Choisir le template de l’annuaire ciblé

- Indiquer les paramètres de recherche

- Lancer le scraper

Mais cette simplicité a une contrepartie majeure.

Vous ne pouvez scraper qu’avec leurs templates

Outscraper ne propose pas de scraping custom. S’ils n’ont pas de template pour votre site, c’est impossible. Vous ne pouvez pas scraper :

- Le site d’un concurrent

- Un annuaire niche de votre industrie

- Un site spécifique hors catalogue

Cela limite fortement l’utilité de l’outil.

Utilité : limitée aux sites pris en charge

Très bon sur certains annuaires

Outscraper dispose d’excellents templates pour :

- Les listings Google Maps

- Les Pages Jaunes

- Les avis Trustpilot

- Les résultats Google Search

- Des profils de réseaux sociaux (limités)

Aucune personnalisation ni flexibilité

Comme vous êtes limité aux templates :

- Impossible de demander d’autres champs

- Impossible de modifier la logique d’extraction

- Impossible de scraper des sites hors catalogue

Pas d’écosystème

Outscraper est un service de scraping pur. Pour l’enrichment ou les contacts vérifiés, il faut exporter ailleurs.

Tarifs : l’entrée la plus abordable

Prix d’entrée : $10 en achat de crédits ponctuel

Ce que vous obtenez :

- Paiement à l’usage

- Accès à tous les templates

- Aucun abonnement obligatoire

Pourquoi ce prix convient à certains

Si vos besoins se limitent à Google Maps ou Pages Jaunes de temps en temps, Outscraper est imbattable. La barrière d’entrée est minimale.

Mais les limites des templates-only font que la plupart des utilisateurs auront tôt ou tard besoin d’une solution plus flexible.

Apify : la marketplace pour profils techniques

Apify est une marketplace d’« actors » préconstruits (scripts d’extraction) pour des sites et cas d’usage spécifiques. C’est l’Android App Store du scraping.

📘 Résumé Apify

Idéal pour : Les profils techniques qui veulent de la variété et n’ont pas peur des réglages

Force clé : Marketplace massive avec des actors pour quasiment n’importe quel site

Tarifs : Palier gratuit, plans payants à partir de $49/mo

Facilité d’usage : ⭐⭐ (2/5) - Dépend fortement de l’actor

Utilité : ⭐⭐⭐⭐ (4/5) - Variété incroyable mais qualité inégale

Prix : ⭐⭐⭐ (3/5) - Peut être économique… ou pas, selon l’usage

Facilité d’usage : expérience inégale

Apify ne respecte PAS le benchmark en 3 étapes. L’expérience varie :

Pour les actors simples :

- Trouver l’actor souhaité

- Renseigner l’URL ou les paramètres

- Lancer l’actor

Pour les actors complexes :

- Trouver l’actor souhaité

- Lire la doc pour comprendre les options

- Configurer de multiples paramètres d’entrée

- Gérer les proxies et anti-bot

- Lancer et croiser les doigts

- Débugger au besoin

Le problème de fond

La plupart des actors ne sont pas développés/maintenus par Apify mais par la communauté. Conséquences :

- Qualité très inégale

- Documentation parfois rare ou obsolète

- Actors cassés quand les sites changent

- Support dépendant du créateur

Utilité : variété inégalée

Un actor pour presque tout

On trouve des actors pour :

- Les réseaux sociaux (Instagram, Twitter, Facebook, LinkedIn)

- L’e-commerce (Amazon, eBay, Shopify)

- Les moteurs de recherche (Google, Bing)

- Le voyage (Booking.com, Airbnb, TripAdvisor)

- Des annuaires professionnels

- Des sites d’actualité

- …et des milliers d’autres

Si un site vous intéresse, il existe probablement un actor.

Développement d’actors sur mesure

Pour les avancés, Apify permet de coder vos actors en JavaScript. Flexibilité totale… mais on sort du no-code.

Écosystème limité

Comme Octoparse et Outscraper, Apify se concentre sur le scraping. Pour exploiter vos données, branchez Zapier, Make, etc.

Tarifs : coûts variables

Prix d’entrée : Palier gratuit, plans dès $49/mo

Ce que vous obtenez :

- Accès à la marketplace

- Système à crédits

- Exécution dans le cloud

- Planification et automatisation

Pourquoi la tarification peut piéger

Le coût dépend fortement :

- Des actors utilisés (certains coûtent plus que d’autres)

- Du volume de données

- Des besoins en proxies

La facture peut grimper vite sur des extractions intensives. Le palier gratuit est généreux pour tester, mais l’usage sérieux demande un plan payant.

Browse AI : monitoring et scraping simple

Browse AI se positionne comme un scraper simple d’usage avec un focus sur le monitoring des changements dans le temps. Interface pointer-cliquer proche d’Octoparse, mais en navigateur.

📘 Résumé Browse AI

Idéal pour : Le monitoring des sites et les extractions simples avec une interface facile

Force clé : Très bon pour suivre les prix, les stocks et les modifications de contenu

Tarifs : Palier gratuit, plans dès $49/mo

Facilité d’usage : ⭐⭐⭐ (3/5) - Interface facile, mais sélection d’éléments frustrante

Utilité : ⭐⭐⭐ (3/5) - Excellent en monitoring, limité pour le scraping complexe

Prix : ⭐⭐⭐ (3/5) - Correct pour de petits usages

Facilité d’usage : facile au départ, frustrant à peaufiner

Browse AI respecte partiellement le benchmark en 3 étapes :

- Installer l’extension navigateur

- Cliquer les éléments à extraire

- Sauvegarder et lancer le robot

Mais un problème majeur demeure : la sélection des éléments.

Le problème de sélection des éléments

Quand vous cliquez sur un numéro de téléphone, Browse AI peut sélectionner :

- Toute la section contact, au lieu du numéro seul

- Un bloc parent HTML qui inclut d’autres textes

- Plusieurs données mélangées

Résultat : données mélangées à nettoyer manuellement après l’extraction. L’interface paraît simple, mais vous perdez du temps à restructurer les données ensuite.

Utilité : pensé pour le monitoring

Très bon pour détecter les changements

Browse AI excelle pour :

- Suivre les variations de prix sur des sites e-commerce

- Suivre les stocks

- Détecter des modifications de contenu chez vos concurrents

- Vous alerter dès qu’un élément change

Limité pour les extractions ponctuelles

Pour du scraping massif ou complexe, Browse AI est moins adapté :

- Problèmes de sélection d’éléments = qualité de données moyenne

- Difficile à scaler à des milliers de pages

- Pas d’enrichment intégré, mais des intégrations Make, Zapier, etc.

Tarifs : option milieu de gamme

Prix d’entrée : Palier gratuit, plans dès $49/mo

Ce que vous obtenez :

- Extension navigateur

- Monitoring planifié et alertes

- Robots cloud

- Crédits limités sur les petits plans

Proposition de valeur

Bonne valeur si votre cas principal est le monitoring des sites. Pour du scraping volumineux ou complexe, la valeur diminue à cause de la sélection d’éléments.

L’essentiel : quel outil est fait pour vous ?

Après avoir évalué les cinq outils avec nos nouveaux benchmarks, voici le bilan :

Meilleur scraper no-code global : Datablist

Datablist gagne sur les trois axes :

- Facilité d’usage : Le seul vraiment no-code, sans connaissance technique

- Utilité : Scrape n’importe quel site et propose 60+ outils de lead gen et d’automatisation

- Prix : Le plus abordable avec crédits flexibles indexés sur la valeur

Choisissez Datablist si :

- Vous voulez du no-code « en anglais naturel »

- Vous cherchez un écosystème complet au-delà du scraping

- Vous voulez le meilleur rapport qualité/prix

Meilleure option desktop : Octoparse

Octoparse est solide si la courbe d’apprentissage ne vous fait pas peur.

Choisissez Octoparse si :

- Vous êtes prêt à apprendre la structure des sites

- Vous avez besoin de scraping desktop avancé

- Le budget n’est pas votre contrainte principale

Meilleure option budget : Outscraper

Outscraper est imbattable sur certains annuaires.

Choisissez Outscraper si :

- Vous scrapez Google Maps, Pages Jaunes ou d’autres annuaires supportés

- Vous voulez l’option la plus économique

- Vous n’avez pas besoin de scraping custom

Meilleur pour la variété : Apify

La marketplace d’Apify est sans équivalent en largeur d’offre.

Choisissez Apify si :

- Vous êtes à l’aise techniquement et avec des configurations

- Vous avez un site très spécifique et un actor existe

- Vous acceptez une qualité et une doc variables

Meilleur pour le monitoring : Browse AI

Browse AI est taillé pour la détection de changements.

Choisissez Browse AI si :

- Votre objectif principal est de monitorer des sites

- Vous suivez des prix ou des stocks

- Vous n’avez pas besoin d’extraire des volumes massifs

Conclusion : il est temps de hausser le niveau

Depuis l’adoption massive de l’IA, le paysage du scraping no-code a changé — nos critères de comparaison doivent changer aussi.

L’ancienne façon d’évaluer comparait au code. Ce n’est pas ce que les utilisateurs veulent. Quand vous cherchez du no-code, vous voulez quelque chose d’aussi simple que lacer ses chaussures ou faire cuire des œufs, pas juste « plus simple que Python ».

Voici les nouveaux benchmarks :

- Facilité d’usage : Respecte-t-il la règle des 3 étapes ? Est-ce vraiment sans connaissance technique ?

- Utilité : Peut-il scraper des sites complexes ? Propose-t-il enrichment et automatisation ? Y a-t-il un écosystème ?

- Prix : Est-ce abordable pour des individus et petites équipes ?

Selon ces critères, Datablist est le grand gagnant pour la majorité, et c’est même le seul outil qui tient la promesse du vrai no-code scraping tout en offrant un écosystème complet de lead generation à un prix accessible.

FAQ sur les scrapers no-code

Quel est l’outil de scraping le plus simple ?

Datablist est l’outil le plus simple car il ne demande aucune compétence technique. Même si ce n’est pas d’abord un scraper, l’AI Agent de Datablist vous permet de décrire en anglais ce que vous voulez sans comprendre HTML, CSS ou la structure des sites. Contrairement aux autres « no-code » qui exigent encore de cliquer des éléments ou configurer des sélecteurs, Datablist est vraiment sans prise de tête.

Quels sont les meilleurs scrapers no-code ?

Les meilleurs scrapers no-code de 2025 :

- Datablist - Meilleur global pour du vrai no-code via IA et anglais naturel. Inclut 60+ outils de lead generation. Dès $25/mo.

- Octoparse - Pour les adeptes du point-and-click. Demande de comprendre la structure des sites. Dès $83/mo.

- Outscraper - Meilleure option budget pour les annuaires supportés comme Google Maps. Limité aux templates. Dès $10.

- Apify - Plus grand choix avec des milliers d’actors. Qualité variable, demande de l’aisance technique. Dès $49/mo.

- Browse AI - Meilleur pour monitorer les changements et les prix. Sélection d’éléments parfois frustrante. Dès $48/mo.

Quels sont les meilleurs scrapers pour les non-techniques ?

Parmi les scrapers no-code, Datablist est le meilleur pour les non-techniques car il supprime toute exigence technique. Vous décrivez en anglais ce que vous voulez, et l’IA s’occupe du reste. Pas d’HTML, de CSS, de sélecteurs, ni d’architecture de site.

Octoparse est le second meilleur choix pour les non-techniques prêts à investir du temps dans l’interface pointer-cliquer. On n’écrit pas de code, mais il faut comprendre la structure des sites — ce qui peut rester difficile si vous êtes vraiment non technique.

Quel est le meilleur scraper pour les sites paginés ?

Datablist est le meilleur pour les sites paginés car son AI Agent gère la pagination automatiquement, sans configuration manuelle. Vous activez la pagination, définissez le nombre de pages, et l’IA parcourt tout toute seule.

D’autres outils comme Octoparse et Apify savent aussi gérer la pagination, mais demandent souvent de configurer la logique manuellement, d’identifier les boutons « page suivante », et de dépanner quand le pattern change. L’IA de Datablist s’adapte automatiquement.