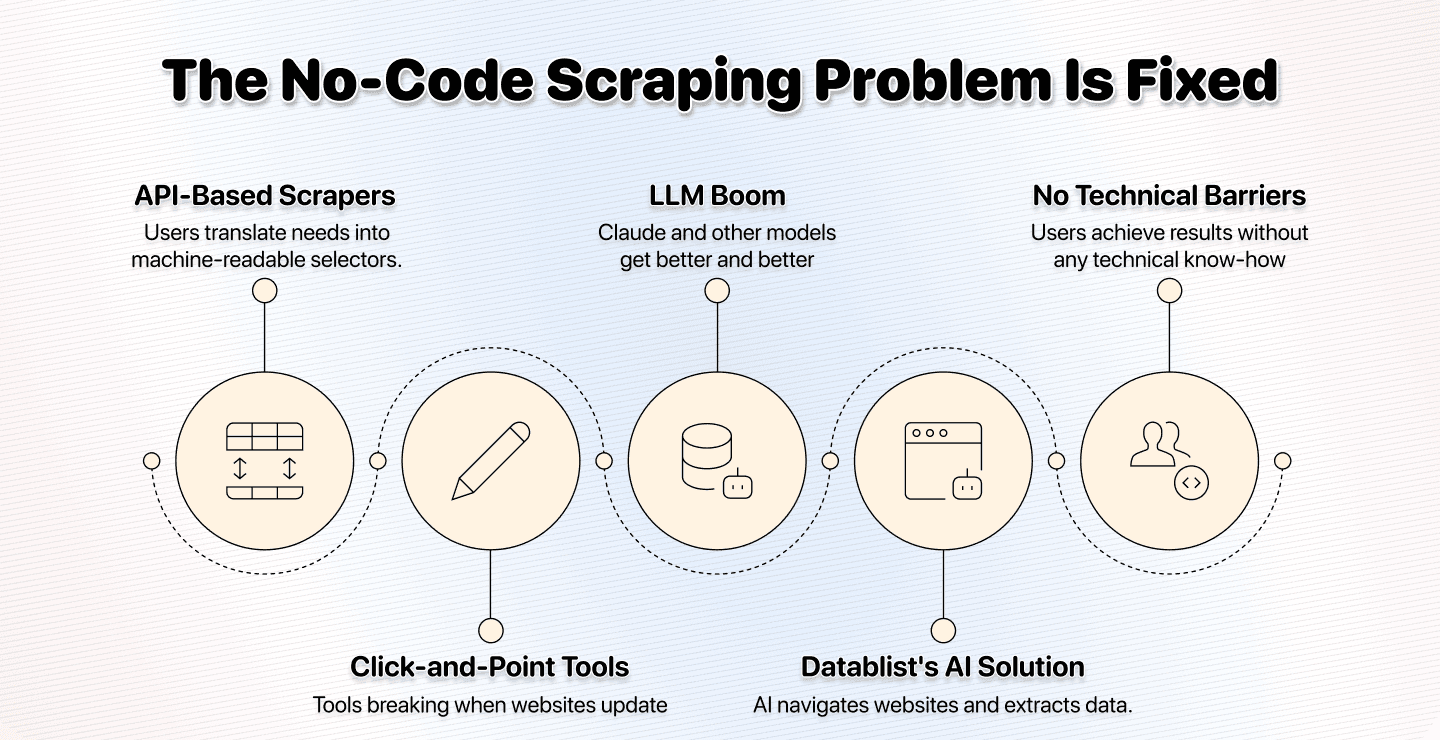

Il y a quelques mois, nous avons lancé une fonctionnalité dont nous ne soupçonnions pas la puissance.

Aujourd’hui, elle bouscule complètement le marché du no-code scraping.

La fonctionnalité en question, c’est notre source “AI Agent - Site Scraper”. Cet agent d’AI scraping peut parcourir n’importe quel site pour trouver, traiter et extraire les données dont vous avez besoin.

Quelques mois plus tard, j’ai réalisé 3 choses :

- Toute l’industrie du no-code scraping repose sur une illusion

- Nous avons construit le meilleur no-code scraper sans même nous en rendre compte

- Les AI scraping agents sont plus puissants, plus simples et plus rapides que tous les outils no-code d’avant

📌 Résumé pour les pressés

Cet article explique ce qu’est le vrai no-code scraping, sans API, CSS selectors ni savoir-faire technique. Voici l’essentiel :

Problème : Les outils « no-code » exigent encore des notions techniques, vous forcent à comprendre la structure des sites, à regarder des tutoriels, à passer des heures à configurer — et au moindre changement de site, tout casse.

Pourquoi c’est un problème : Vous ne devriez pas avoir à apprendre des API, des CSS selectors ou à regarder des heures de tutoriels juste pour extraire des données. Cela contredit l’idée même de « no-code ».

Solution : Le scraping par Datablist, propulsé par l’IA, à partir d’instructions en anglais simple. Vous décrivez ce que vous voulez, l’IA s’occupe du reste.

Ce que vous allez apprendre : Les failles du no-code scraping actuel, à quoi ressemble le vrai no-code scraping, des cas d’usage concrets et des conseils de prompting.

Pourquoi utiliser Datablist pour le no-code scraping : 3 raisons clés

- Vraiment no-code : décrivez en anglais simple

- Gère les sites complexes (JavaScript, pagination, contenu dynamique)

- S’adapte aux changements de site, contrairement aux scrapers basés sur des CSS selectors

Ce que vous allez apprendre

- Le no-code scraping et ses mensonges

- La solution facile : utilisez des mots, pas des API

- Cas d’usage et conseils pour l’AI scraping

- Foire aux questions sur le no-code scraping

Le no-code scraping et ses mensonges

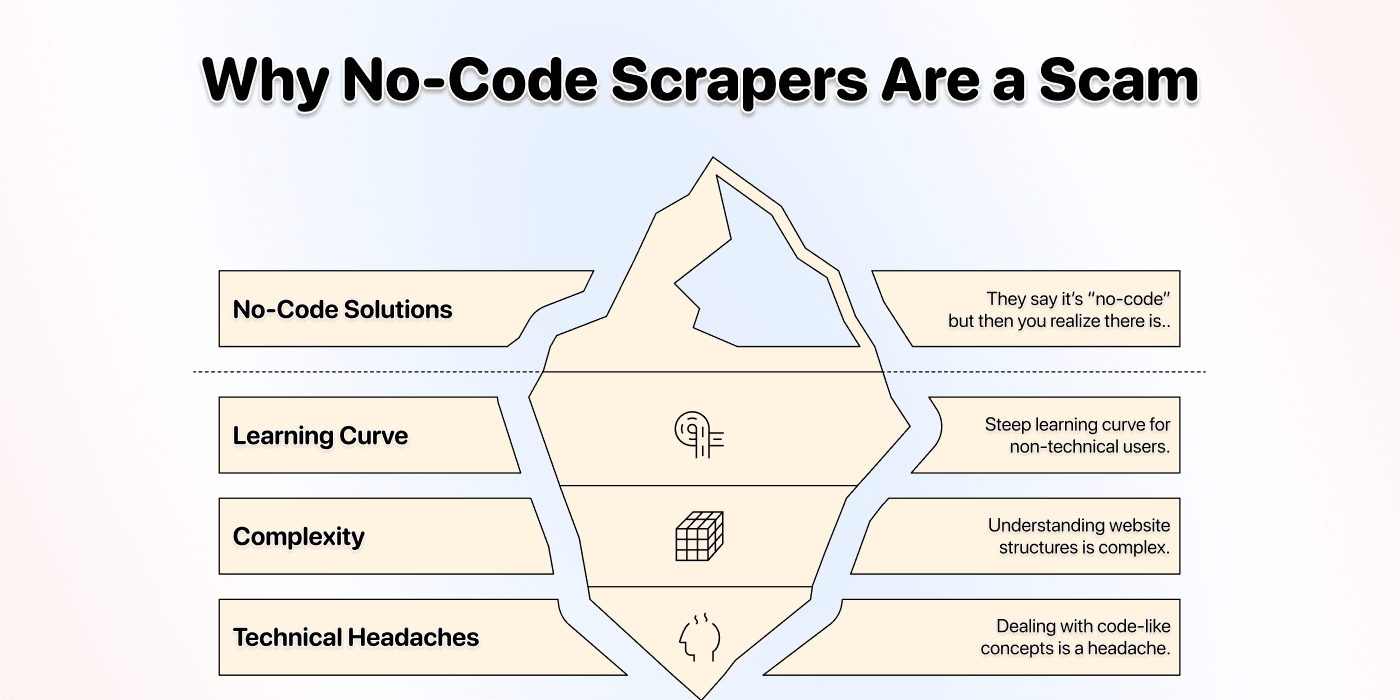

Dans cette section, on démonte les mythes et ficelles du no-code scraping. La vérité, c’est que la plupart des outils « no-code » n’en sont pas vraiment. Ils reconditionnent la complexité technique sous une autre forme.

Pourquoi le code n’a jamais été le problème

Réfléchissez un instant : le code n’était pas le problème. Si vous saviez coder, vous scraperiez en code et vous ne chercheriez pas une solution no-code.

Vous cherchez du no-code parce que vous ne voulez pas apprendre à coder juste pour scraper un site, mais des gens malins vous ont vendu une solution à moitié efficace ; une solution qui implique encore :

- Une courbe d’apprentissage raide

- Des tutoriels à la chaîne

- Comprendre la structure des sites web

Et parfois même des concepts proches du code, comme les CSS selectors.

Le vrai problème n’a jamais opposé code et no-code.

Le vrai problème, c’est la courbe d’apprentissage, la complexité et les prises de tête techniques.

Ce qu’on a essayé de vous vendre

L’industrie du no-code scraping suit trois approches principales, et aucune ne résout vraiment la complexité.

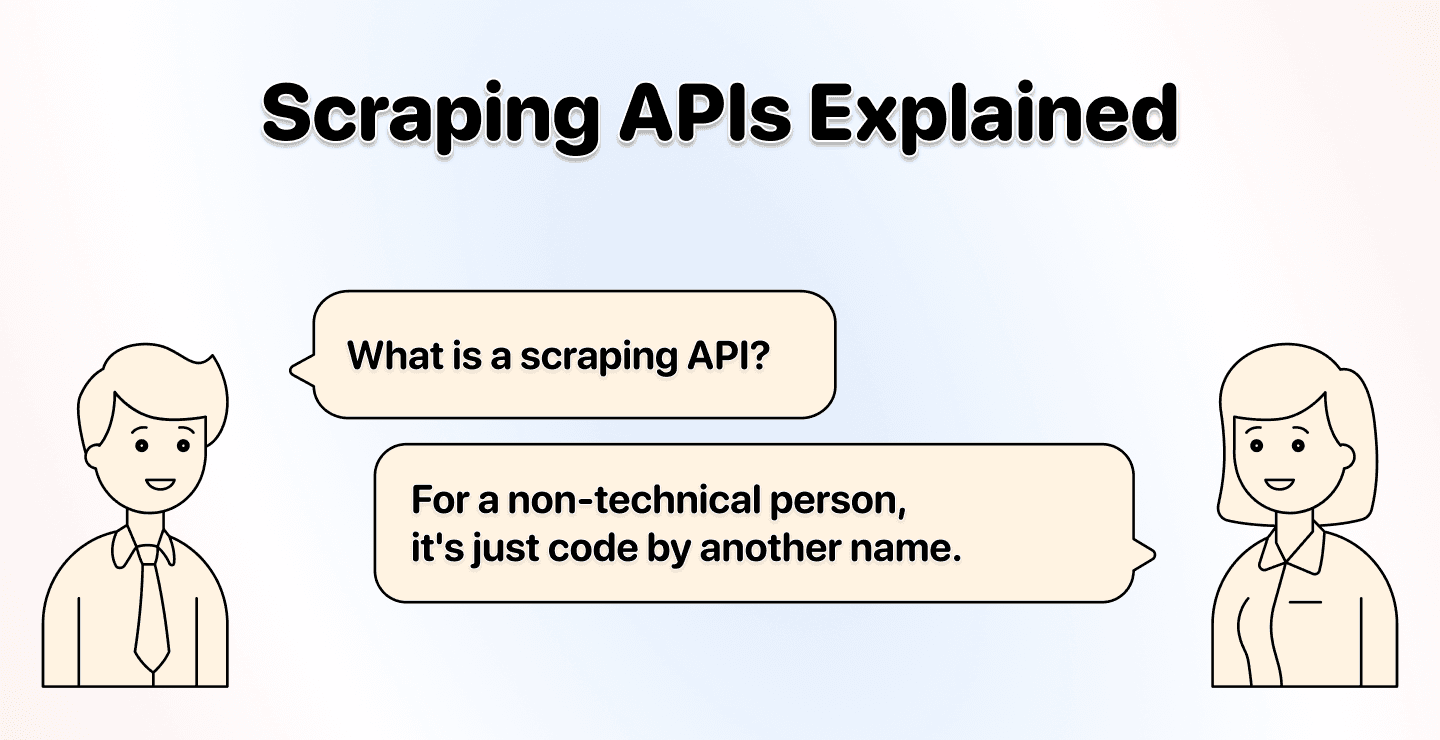

Scrapers basés sur des API

Ces outils se disent « no-code » car vous n’écrivez pas de Python ou de JavaScript. Mais on oublie de vous dire ceci :

Vous devez quand même gérer :

- Les structures DOM des sites

- Les CSS selectors

- Les balises HTML

Techniquement, vous ne codez pas, mais vous faites quelque chose d’aussi technique. Vous traduisez un besoin humain en sélecteurs lisibles par la machine, autrement dit, une forme de programmation avec des étapes en plus.

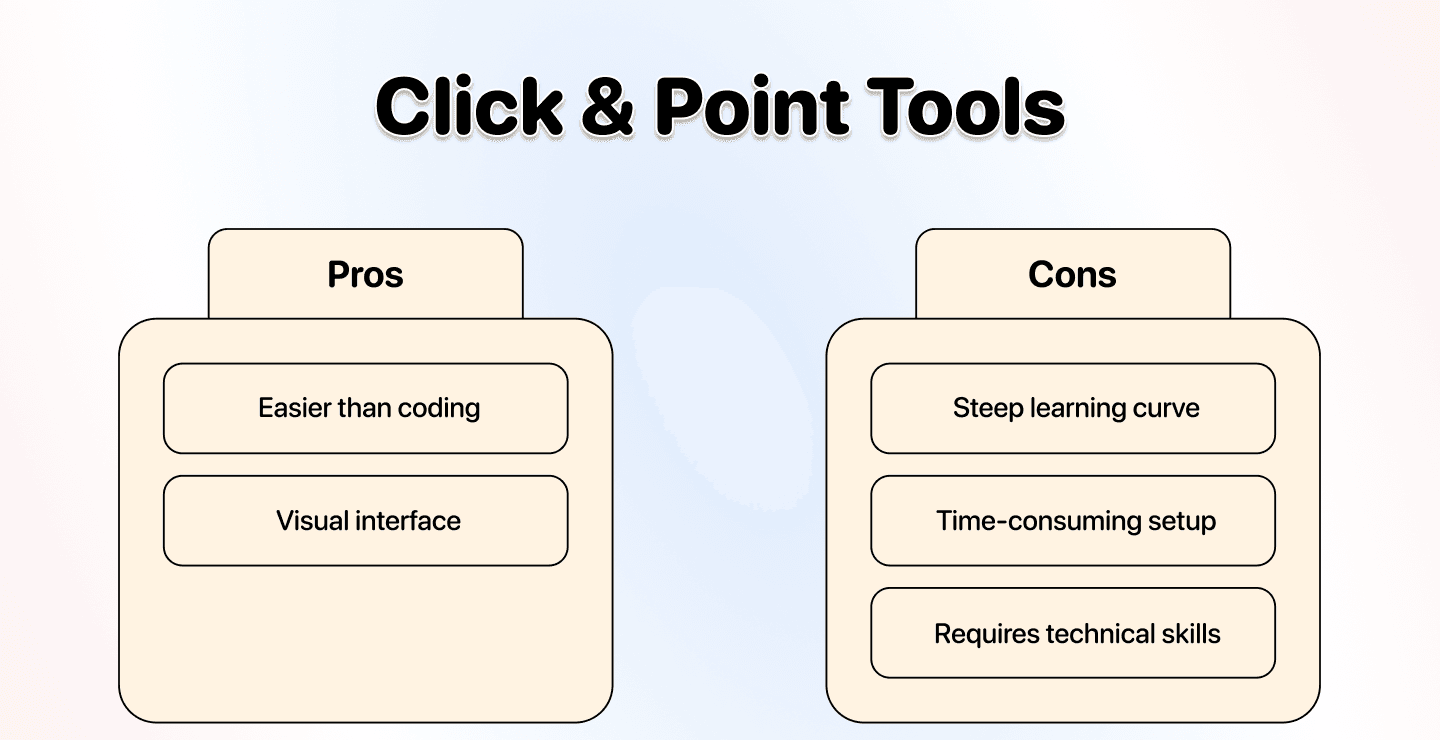

Outils click-and-point

Cette approche est plus simple, mais elle suppose toujours que vous compreniez comment le site est construit. On vous laisse cliquer sur des éléments, c’est un peu plus facile, mais loin d’être sans prise de tête.

Le vrai problème ? Au moindre changement de structure du site, vous devez tout reconfigurer de zéro. Concrètement :

- Revoir le tutoriel

- Reconfigurer tous vos sélecteurs

- Espérer que ça fonctionne cette fois

Extensions de navigateur

Ce sont des outils click-and-point qui tournent dans votre navigateur plutôt que dans une application dédiée. Beaucoup sont gratuits, comme Instant Data Scraper.

Les principaux problèmes :

- Un changement sur le site et vous recommencez tout

- Fonctionnalités et échelle limitées

- Risque de blocage d’IP

📘 Le schéma à retenir

Les trois approches vous obligent à comprendre la structure technique des sites. Elles reconditionnent la complexité dans une autre interface. Ce n’est pas résoudre le problème, c’est le déplacer.

Ce que vous voulez vraiment

Soyons honnêtes : vous voulez du scraping sans prise de tête, pas juste « no-code ». Concrètement, un scraping « sans prise de tête », c’est :

Zéro prise de tête

- Ne me forcez pas à comprendre les CSS selectors

- Ne me faites pas regarder 3 heures de tutoriels

- Ne cassez pas tout à chaque refonte de site

Zéro courbe d’apprentissage

- Je dois pouvoir démarrer immédiatement

- Sans devoir apprendre une nouvelle compétence technique

En bref, vous décrivez votre objectif en langage naturel et vous obtenez le résultat. Tout le reste, c’est de la friction inutile que le marché a normalisée.

La solution : remplacer le no-code scraping par l’AI scraping

La solution au problème du no-code scraping n’est pas une meilleure interface click-and-point ni une API plus propre. La solution, c’est de supprimer la couche technique et d’utiliser le langage naturel.

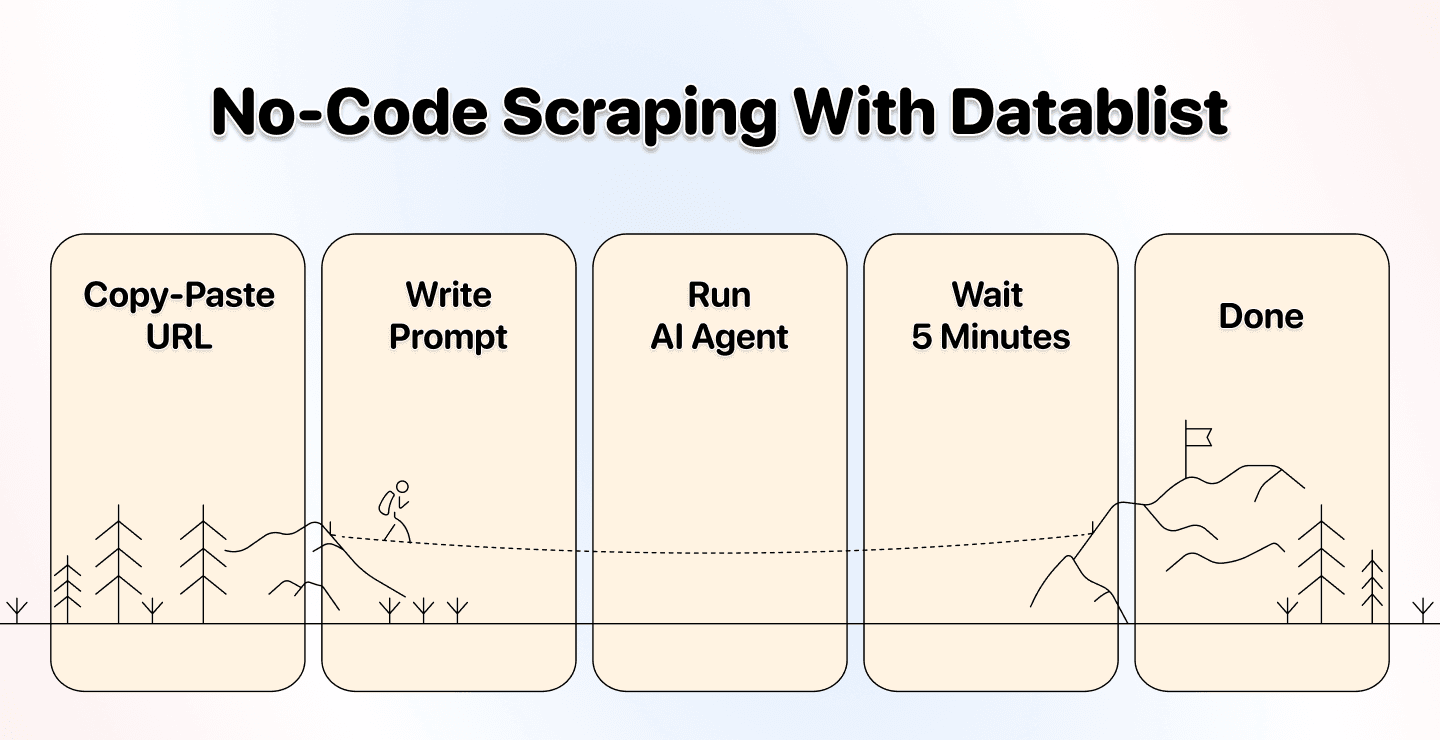

Comment l’AI scraping rend enfin le no-code scraping réellement no-code

Comme son nom l’indique, l’AI scraping laisse l’IA scraper le site, pas vous. Vous devenez le manager, pas l’opérateur technique.

Avec du no-code scraping piloté par IA, vous dites simplement au système quoi faire, comment et quand. L’IA gère toute la complexité technique en coulisses.

Inutile de connaître :

- Les CSS selectors ou la structure HTML

- L’architecture DOM des sites

- Les endpoints d’API ou la documentation technique

Vous donnez des instructions en anglais simple, et l’AI scraping agent se charge du reste. C’est comme ça que le no-code scraping aurait dû fonctionner depuis le début.

La solution portée par Datablist.com

Comme je l’expliquais, nous n’avions pas prévu de chambouler l’industrie du no-code — c’est arrivé par accident : un client devait scraper un site, nous lui avons construit une solution.

Nous lui avons conçu un AI Agent capable de :

- Comprendre des instructions en anglais simple

- Naviguer automatiquement sur des sites complexes

- Gérer des pages très chargées en JavaScript

- Traiter du contenu paginé

- Extraire les données intelligemment

- …

La vraie avancée n’a pas été de fabriquer un meilleur scraper.

Elle a été de supprimer totalement le besoin de connaissances techniques.

Vous dites à l’IA ce que vous voulez, elle trouve comment l’obtenir.

Pas de CSS selectors. Pas d’inspection du DOM. Pas de tutoriels.

Qu’est-ce que Datablist

Datablist est une plateforme d’automatisation pour la lead generation, l’enrichment et le cleaning de données, pensée pour les non-tech (sales, marketing, recrutement).

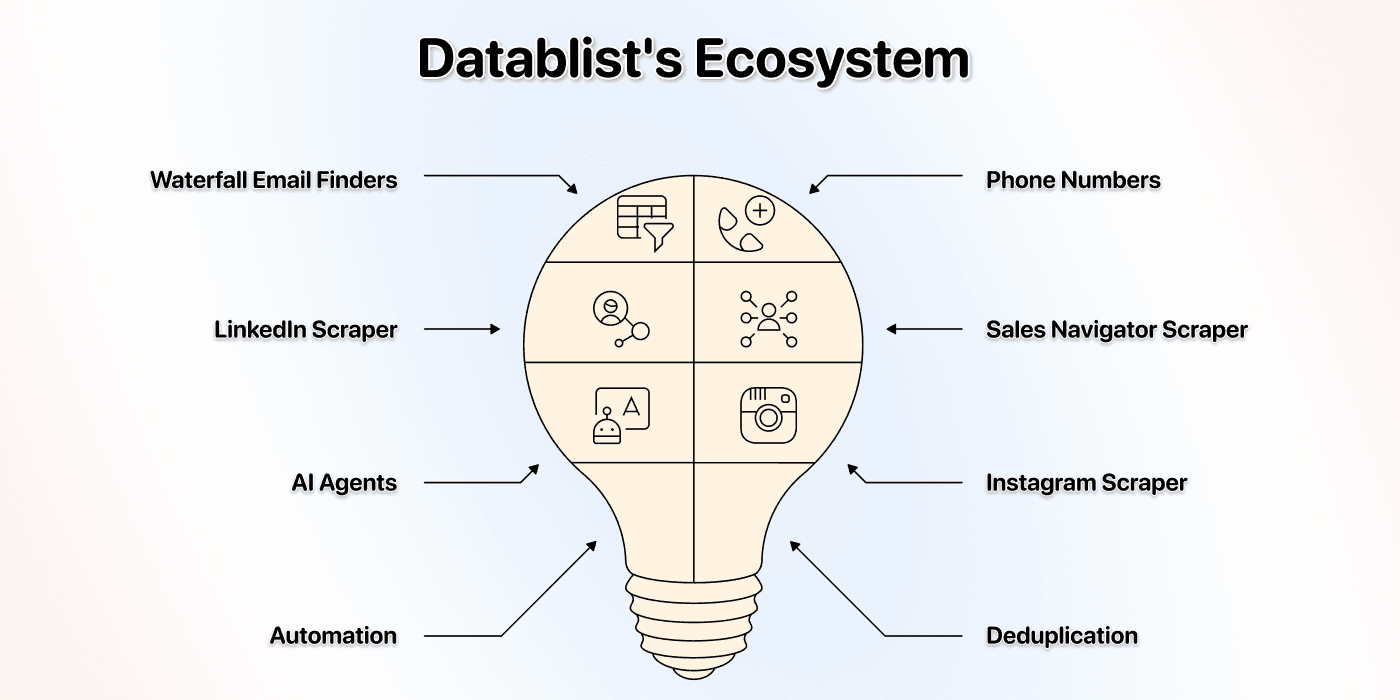

Elle permet de trouver, nettoyer et enrichir des données grâce à plus de 60 outils, des AI Agents aux Email Finders, en passant par les AI processors, les Technology enrichments, et bien d’autres.

Datablist vous permet aussi de créer des workflows automatisés, planifiés ou à la demande. Quelques cas d’usage appréciés par nos clients :

- Construire des listes de leads

- Personnaliser des emails avec l’IA

- Nettoyer et dédupliquer un CRM

- Scraper des offres d’emploi sur 19 job boards d’un coup

- Scraper des milliers d’entreprises depuis Pages Jaunes

- Scraper des recherches LinkedIn Sales Navigator sans risquer votre compte

Vous l’avez compris : si vous devez collecter, nettoyer, enrichir des données, ou automatiser des workflows data — simplement, vite et de façon fiable — Datablist est la bonne adresse.

En prime, Datablist a résolu par accident le problème du no-code web scraping.

💡 Datablist en 35 mots

Datablist est une plateforme d’automatisation pour la lead generation, avec plus de 60 outils : AI Agents, Waterfall Enrichment pour trouver emails et téléphones, data cleaning pour la déduplication, et plus encore.

Pourquoi choisir Datablist

L’approche de Datablist en no-code scraping est différente, car nous n’avons jamais vendu des « maux de tête bien emballés » ; nous avons opté pour l’AI scraping.

Concrètement, pour vous, ça veut dire :

Un vrai no-code

- Zéro connaissance technique requise

- Pas besoin de comprendre HTML ou CSS

- Vos automatisations ne cassent pas à chaque mise à jour du site

Vous n’avez qu’à rédiger un prompt

- Écrivez ce que vous voulez en anglais simple

- L’IA comprend le contexte et l’intention

Des templates pour de nombreux scrapers

- Prompts préconçus pour les cas d’usage courants

- Templates pour scraper des annuaires

- Templates pour scraper l’e-commerce

- Templates pour extraire des case studies

La solution la plus simple pour scraper un annuaire

- Fonctionne sur Pages Jaunes, Yelp, TripAdvisor, Alibaba

- Gère la pagination automatiquement

Plus besoin de jouer à l’export–import entre 10 outils

- Les données arrivent directement dans une interface de type spreadsheet

- Éditez, filtrez et enrichissez au même endroit

- Accédez à tout un écosystème de lead generation

Cas d’usage et conseils

Avec Datablist, scraper des sites, des annuaires ou faire de la recherche IA à grande échelle est simple : la méthode est toujours la même. Décrivez précisément ce que vous voulez.

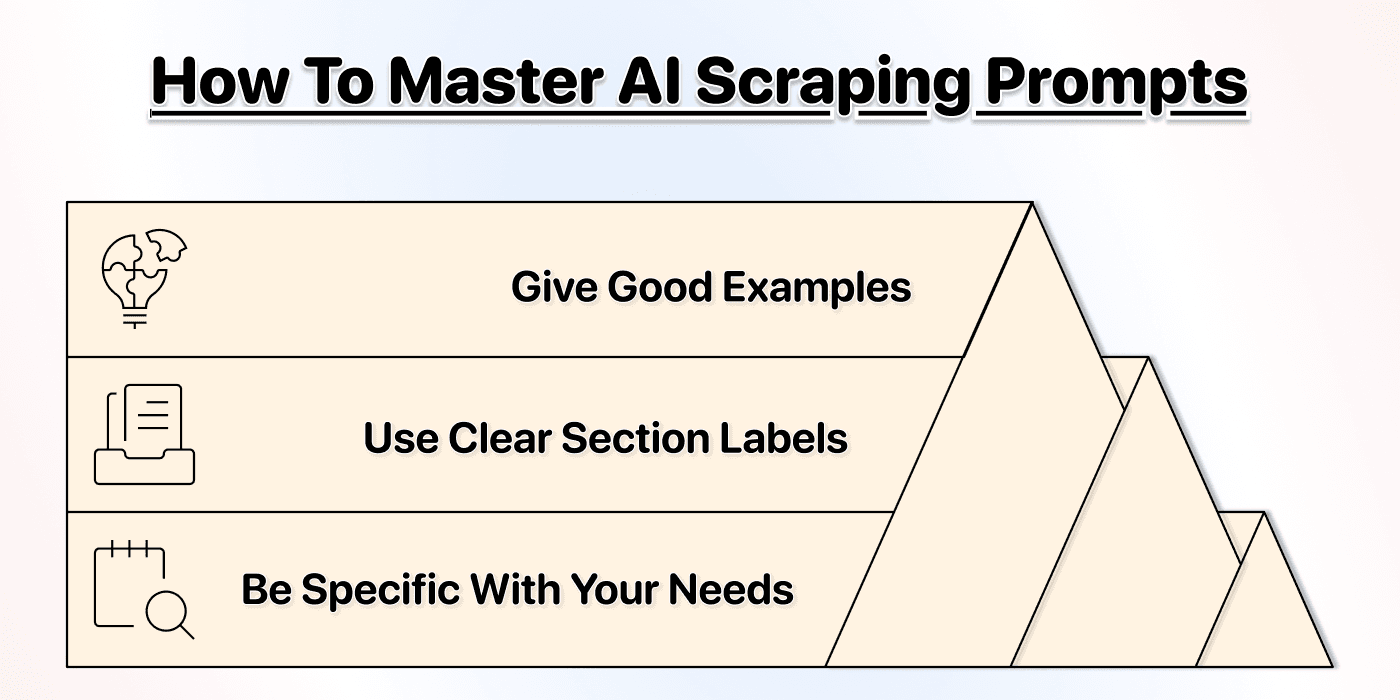

Prompting 101 : le résumé express

Avant d’explorer les cas d’usage de l’AI scraping agent, voici à quel point il est simple à piloter.

Règles de prompting :

Un bon prompt, c’est simple. Pas besoin d’être expert ; il suffit d’être clair. Voici quelques conseils pour de meilleurs prompts :

Soyez précis

- Ne dites pas « récupérer les infos produit »

- Dites « récupérer nom du produit, prix, disponibilité »

- Ajoutez des exemples quand c’est possible

Cela garantit d’obtenir exactement les données voulues, sans mauvaise interprétation de l’agent.

Structurez en sections

- Organisez votre prompt en parties claires

- Goal : ce que vous cherchez à accomplir

- Data Points : les informations précises à extraire

- Format : la structure attendue des données

- Constraints : ce qu’il faut éviter ou inclure

Les sections aident l’agent à comprendre votre intention. Ce n’est pas obligatoire, mais nous constatons une nette hausse de précision.

Donnez des exemples

L’agent n’est pas omniscient. Certains sites sont complexes. En donnant des exemples, vous évitez les faux positifs, augmentez la précision et réduisez le coût.

Voici un guide détaillé pour écrire un prompt efficace 👈🏽

💡 Pro tip : gérer la pagination

L’AI Agent de Datablist gère automatiquement le contenu paginé. Il suffit d’activer la pagination dans les paramètres et de fixer un nombre maximum de pages. L’agent parcourra toutes les pages et en extraira les données.

===

Data Points I Need:- Product Name (example: "Classic T-Shirt")

- Price (example: "$29.99")

- Product URL (full link)

- Availability (In Stock / Out of Stock)

===

Format:- Return one row per product

- Use "N/A" if data is missing

===

Constraints:- Skip promotional banners

- Only get actual products, not category pages

Cas d’usage du no-code scraping

Les possibilités sont quasi infinies. Voici les cas d’usage d’AI scraping les plus populaires et efficaces :

Annuaires

- Scraper des entreprises depuis Pages Jaunes

- Scraper des restaurants sur Yelp

- Scraper des propriétés sur AirBnB

- Scraper des hôtels sur TripAdvisor

- Scraper des catalogues de fournisseurs sur Alibaba

- Scraper des biens sur Zillow

- Scraper des agents immobiliers sur Zillow

Sites e-commerce

Autres

- Scraper tous les case studies d’un site

- Extraire les exposants de sites de salons

📘 Comment scraper plusieurs sites

Si vous avez une liste de sites similaires à scraper, vous pouvez aussi utiliser Datablist’s AI Research Agent pour scraper un ensemble de sites. Cet agent sait également lancer une AI search à grande échelle.

Conclusion : on devrait renommer le no-code scraping

Le no-code scraping devrait s’appeler « scraping sans prise de tête », car c’est ce que vous cherchez vraiment. Vous ne tapez pas « no-code scraping » parce que vous ne pouvez pas coder ; vous le tapez parce que vous ne voulez pas apprendre des compétences techniques juste pour extraire des données.

Donc si le scraping n’est pas votre activité principale, vous ne devriez pas y perdre des heures. La solution n’est pas une API « plus propre » ni une interface click-and-point plus jolie.

La solution, c’est de supprimer la couche technique. Autrement dit, l’AI scraping.

Avec Datablist, vous faites exactement cela, et vous pouvez :

- Obtenir des résultats en minutes, pas en heures

- Passer d’un site à des milliers

- Décrire vos besoins en anglais simple

- Vous adapter automatiquement aux changements des sites

Le problème du no-code scraping est enfin résolu. Et nous l’avons fait par accident.

Foire aux questions sur le no-code scraping

Datablist peut-il scraper des annuaires ?

Oui, l’AI Scraping Agent de Datablist scrape très efficacement les annuaires et gère la pagination automatiquement, ce qui vous permet d’extraire des milliers de fiches sans configuration manuelle.

Par exemple, nous avons déjà extrait avec succès :

- Des avis, hôtels, restaurants, etc. sur TripAdvisor

- Des fiches d’entreprises sur Pages Jaunes

- Des catalogues de propriétés sur Airbnb

- Des bases de fournisseurs sur Alibaba

- Des informations d’entreprises sur Yelp

- … et bien d’autres

Puis-je extraire des données automatiquement sur plusieurs pages ?

Oui, l’AI Scraping Agent de Datablist gère la pagination automatique. Définissez le nombre maximum de pages dans la configuration, et l’agent parcourra toutes les pages pour en extraire les données, sans intervention.

Cela fonctionne pour :

- Des catalogues produits e-commerce

- Des listings d’annuaires sur plusieurs pages

- Des résultats de recherche paginés

- Des archives de blogs

- …

Quel est le coût d’utilisation du Scraping Agent de Datablist ?

La tarification des AI agents de Datablist est basée sur l’usage et varie selon la complexité de la tâche. Pour des annuaires comme Pages Jaunes, le coût est plus faible : scraper 1000 fiches revient généralement entre 800 et 1000 crédits. Pour des sites très chargés en JavaScript (ex. boutiques Shopify), le coût peut être plus élevé.

Qu’est-ce que le no-code scraping ?

Le no-code scraping consiste à extraire des données de sites sans écrire de code ni mobiliser de compétences techniques. Le vrai no-code scraping signifie que vous décrivez votre besoin en anglais simple et obtenez un résultat, sans comprendre HTML, CSS selectors ni API.

Datablist gère-t-il les sites très chargés en JavaScript ?

Oui, l’AI Agent de Datablist peut scraper des sites lourds en JavaScript. Activez l’option "Render HTML" dans les paramètres avancés pour que l’agent attende le chargement JavaScript avant d’extraire les données.

C’est essentiel pour les sites modernes en React, Vue ou Angular qui chargent le contenu après l’ouverture de la page.

Quelle différence entre no-code scraping et web scraping traditionnel ?

Le scraping traditionnel requiert des compétences de code (Python, JavaScript) ou techniques (CSS selectors, XPath). Le no-code scraping supprime cette exigence en proposant des interfaces visuelles ou, chez Datablist, la compréhension du langage naturel.

En quoi l’AI scraping diffère-t-il des scrapers basés sur des CSS selectors ?

Les scrapers à base de CSS selectors dépendent de la structure exacte du HTML. Au moindre changement de layout, le scraper casse.

L’AI scraping comprend le sens du contenu, pas juste sa position. Il reconnaît « ceci est un prix produit » même si les classes HTML changent. C’est plus robuste et sans maintenance.

Le no-code scraping est-il légal ?

La légalité du scraping dépend de ce que vous scrapez et de l’usage que vous en faites. Le scraping de données publiques est généralement légal, mais vous devez :

- Respecter les fichiers robots.txt

- Éviter de scraper derrière des zones de login

- Utiliser les données de manière éthique et conforme aux lois de confidentialité

- Ne pas surcharger les serveurs avec des requêtes excessives