Ich mache jetzt eine steile, aber ziemlich sichere Ansage.

Dieser Artikel wird verändern, wie Du No-Code-Scraping-Tools bewertest und über sie nachdenkst. Und zwar aus einem einfachen Grund:

AI hat alles verändert, was wir über No-Code Scraping zu wissen glaubten – aber die meisten vergleichen Tools immer noch nach den alten Maßstäben. Wenn sich das Spiel ändert, müssen sich die Regeln mitändern.

Lass uns ins Detail gehen.

📌 Kurzfassung für alle, die wenig Zeit haben

Dieser Artikel rankt die besten No-Code-Scraping-Tools anhand neuer, nutzerzentrierter Benchmarks – statt sie ständig mit „Coding“ zu vergleichen. Wenn Du es eilig hast, hier die Kurzfassung:

Problem: Die meisten Vergleiche nutzen veraltete Benchmarks und messen No-Code-Tools daran, wie viel „einfacher als Programmieren“ sie sind – nicht daran, wie einfach sie wirklich sind.

Warum das ein Problem ist: Wenn Du ein No-Code-Tool suchst, willst Du etwas, das so simpel ist wie Eier kochen – nicht etwas, das nur „leichter als Python“ ist.

Lösung: Neue Benchmarks, die echte Benutzerfreundlichkeit (3-Schritte-Simplicity), Nutzen (was kann das Tool wirklich) und Preis (bezahlbar für Einzelpersonen und kleine Teams) messen.

Was Du lernst: Wie Du No-Code-Scraping-Tools nach den richtigen Kriterien bewertest, detaillierte Reviews der Top 5 Tools und welches Tool am besten zu Deinem Use Case passt.

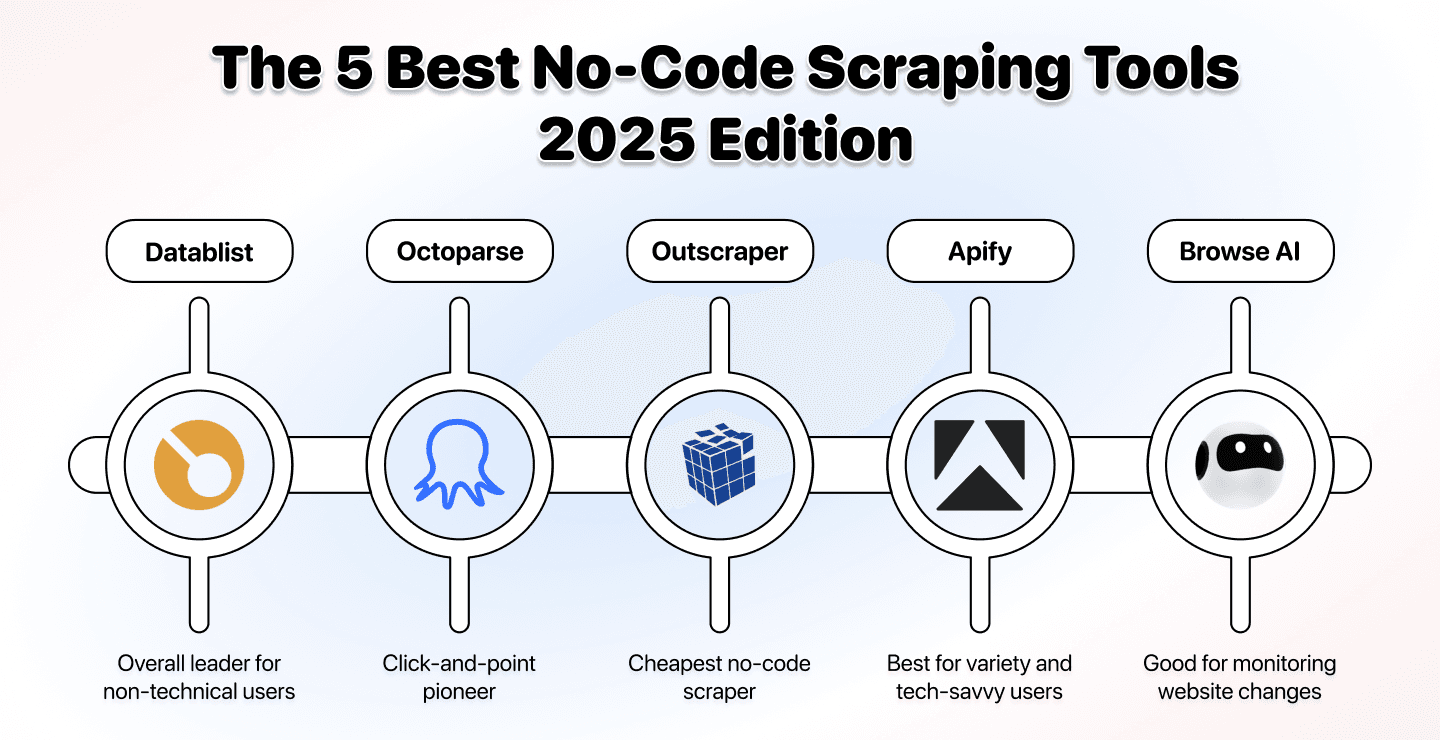

Das Ranking:

- Datablist – Bestes Gesamtpaket für Non-Technical User

- Octoparse – Click-and-Point-Pionier

- Outscraper – Günstigster Einstieg

- Apify – Größte Auswahl für Tech-Savvy User

- Browse AI – Am besten fürs Monitoring von Website-Änderungen

Was Dich in diesem Artikel erwartet

- Die 5 besten No-Code Scraper im Überblick

- Buyer Guide: „Bestes Tool“ neu definieren

- Detaillierte Reviews der Top 5 No-Code-Scraping-Tools 2025

- FAQ zu No-Code-Scraping-Tools

Die 5 besten No-Code Scraper im Überblick

| Tool | Am besten für | Ease | Power | Preis | Killer Feature |

|---|---|---|---|---|---|

| Datablist | Scraping in Klartext, komplettes Ökosystem, Flexibilität | ●●●●● | ●●●●● | $25/mo | „Scrape das und hol mir Emails“ funktioniert wirklich |

| Outscraper | Google Maps, Yellow Pages, günstigste Option | ●●●● | ●● | $10 | $10 Einstieg, keine Bindung |

| Octoparse | Visuelles Interface, Desktop-App, Tutorials | ●●● | ●●●● | $83/mo | Bestes Click-and-Point-Interface |

| Apify | Riesige Auswahl, technische Flexibilität, fast jede Website | ●● | ●●●● | $49/mo | 1000+ fertige Actors |

| Browse AI | Website-Monitoring, Price Tracking, Alerts | ●●● | ●●● | $49/mo | Change Detection in Echtzeit |

🏆 Der Gewinner

Für die meisten: Datablist gewinnt, weil es als einziges Tool wirklich No-Code ist (Klartext), auf praktisch jeder Website funktioniert und außerdem ein Ökosystem aus 60+ Lead-Gen-Tools zum besten Preis bietet (nur $25/mo).

Buyer Guide: Bessere Entscheidungen durch eine neue Definition von „das beste Tool“

Wir starten mit dem Abschnitt, den ich für den wichtigsten im ganzen Artikel halte. Und das ist er deshalb, weil er Dir zeigt, wie der Standard für No-Code-Tools eigentlich aussehen sollte.

Wenn Du Deine eigenen Entscheidungskriterien schon parat hast, kannst Du direkt zu den Tool-Vergleichen springen. Wenn nicht, dann denk kurz darüber nach: Die meisten „best no-code scraping tools“-Artikel, die Du online findest, sind am Ende nicht wirklich hilfreich und kommen mit der Realität nicht mehr mit.

Hier ist das Grundproblem:

↳ Wir definieren „einfach zu bedienen“ seit Jahren falsch (und genau das ist bei No-Code-Scrapern das Wichtigste)

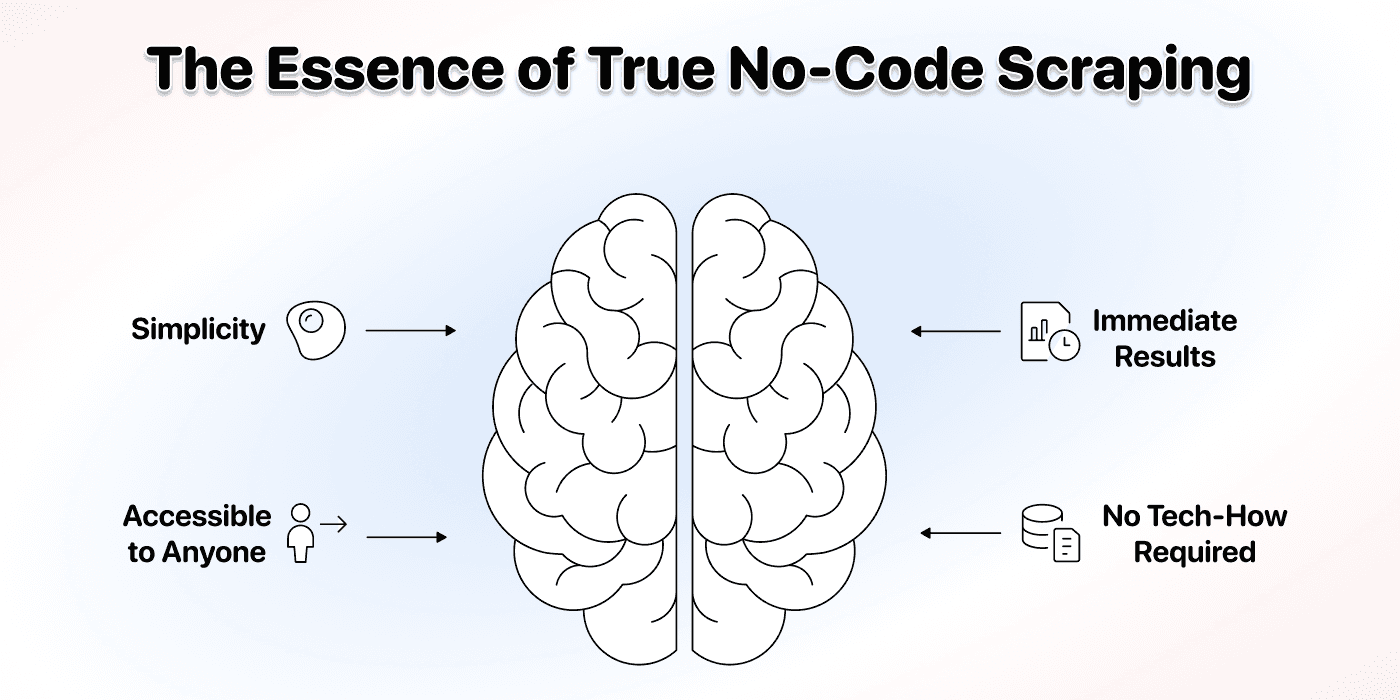

↳↳ Ease of use sollte man nicht mehr gegen Coding vergleichen, sondern gegen Dinge wie Eier kochen oder Schuhe binden

↳↳↳ Wenn Du nach No-Code-Scraping-Tools suchst, willst Du nicht „leichter als Python“

↳↳↳↳ Du willst etwas, das wirklich null technisches Know-how braucht.

↳↳↳↳↳ Genau das ermöglicht AI Scraping: Du scrapest in normalem Klartext.

Dann gibt’s natürlich noch Nutzen und Preis – die sind auch entscheidend, wenn wir bestimmen wollen, welches Tool 2025 wirklich das beste No-Code-Scraping-Tool ist.

Benutzerfreundlichkeit: Der Eierkochen-Benchmark

Meistens wird Benutzerfreundlichkeit damit begründet, dass etwas „einfacher als Programmieren“ ist. Für Non-Technical User ist das kein sinnvoller Vergleich. In diesem Artikel mache ich es anders: Ich vergleiche Ease of use mit Eier kochen.

Eier kochen ist eine der einfachsten Sachen überhaupt:

- Eier ins Wasser legen

- X Minuten warten, je nachdem wie hart Du sie willst

- Eier rausnehmenDas sind 3 Schritte, um Eier zu kochen.

Das ist der neue Benchmark für Benutzerfreundlichkeit: 3 Schritte – alles darüber bekommt einen Punkt abgezogen.

Wirklich No-Code oder nicht?

Der zweite Teil von Benutzerfreundlichkeit ist die Frage, ob Du erst eine neue technische „Skill“ lernen musst, um das Tool sinnvoll zu nutzen.

Echtes No-Code heißt:

- Kein Verständnis von HTML, CSS oder JavaScript nötig

- Kein Lernen von DOM-Strukturen oder Selectors

- Keine Stunden an Tutorials, nur um überhaupt loszulegen

- Kein unnötiges Tech-Gelaber

Wenn Dich ein No-Code-Scraping-Tool zwingt, Website-Architektur zu verstehen, auf HTML-Elemente zu klicken oder CSS-Selectors zu konfigurieren, ist es nicht wirklich No-Code. Dann ist es einfach Code – nur mit hübscher Oberfläche.

Nutzen: Was kannst Du damit wirklich machen?

Nutzen ist eigentlich simpel: Was bringt Dir das Tool im Alltag?

Wir bewerten nach den typischen Anforderungen, wegen denen Leute sich überhaupt ein Scraping-Tool holen:

- Komplexe Websites scrapen

- Viele Daten ziehen

- Wiederkehrende Aufgaben automatisieren

Advanced Scraping Capabilities

Kann das Tool Folgendes:

- JavaScript-lastige Websites, die Inhalte dynamisch nachladen?

- Paginierte Ergebnisse über mehrere Seiten?

- Komplexe Navigation und Multi-Step-Prozesse?

JavaScript-Rendering ist eine der größten technischen Hürden im modernen Web Scraping, weil über 70% moderner Websites Inhalte dynamisch per JavaScript laden. Je komplexer die Seiten, die Du scrapen kannst, desto nützlicher ist das Tool.

Integrations & Ecosystem

Niemand scraped Daten „zum Spaß“ – Du scrapest, um Dein Business zu pushen. Deshalb ist es nur logisch, dass Du die Daten aus dem Tool direkt weiterverwenden können solltest, ohne 10 Plattformen jonglieren zu müssen.

Gute No-Code-Scraping-Tools bieten deshalb:

- Unterschiedliche Scraper für verschiedene Use Cases

- Integrationen in Deinen Workflow

- Enrichment (Emails, Telefonnummern usw.)

Ein Scraper, der Dir nur eine CSV ausspuckt und Dich dann alleine lässt, ist deutlich weniger wert als einer, der in ein echtes Daten-Ökosystem eingebettet ist.

Wiederkehrende Automations

Du willst nicht jeden Tag wieder bei null anfangen.

Gute No-Code-Scraper sollten Dir ermöglichen:

- Scraping-Jobs automatisch zu planen

- Websites auf Änderungen zu überwachen

- Workflows zu bauen, die mehrere Aktionen aneinanderreihen

Pricing: Für Menschen optimiert – nicht für Behörden

Die besten No-Code-Scraping-Tools bringen Dir nichts, wenn ihre Preise auf Enterprise-Budgets optimiert sind – statt auf Einzelpersonen und kleine Teams.

Wir bewerten Pricing nach:

- Einstiegspreis (kannst Du es bezahlbar testen?)

- Transparenz (klar oder versteckt?)

- Flexibilität (zahlst Du nach Nutzung oder wirst Du in teure Pläne gezwungen?)

- Value (was bekommst Du fürs Geld?)

Wenn Du „contact sales“ klicken musst oder es bei $500/Monat losgeht, ist das Tool nicht für die breite Masse gebaut, die Daten scrapen will.

Schauen wir uns jetzt die Tools im Detail an – und wie sie gegen diese neuen Benchmarks abschneiden.

Datablist: Der Gesamtsieger für Non-Technical User

Datablist ist kein typisches Scraping-Tool. Eigentlich ist es nicht mal primär ein Scraping-Tool.

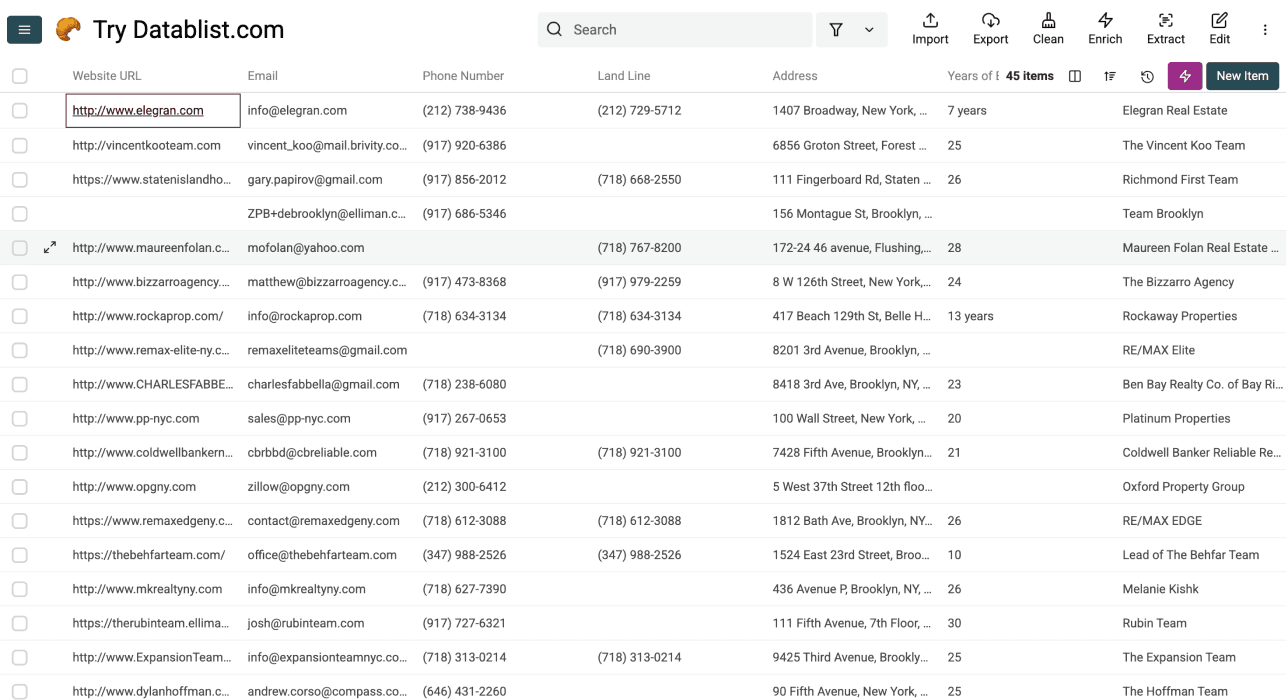

Datablist ist eine Plattform, mit der Du Lead-Generation-Workflows automatisierst und Daten finden, bereinigen und anreichern kannst – mit über 60 Tools: von AI Agents über Email Finders, AI processors, Technology enrichments und mehr.

Außerdem kannst Du in Datablist automatisierte Workflows bauen, die nach Zeitplan oder on demand laufen. Ein paar praktische Use Cases, die Datablist-User feiern:

- Lead-Listen bauen

- Cold Emails mit AI personalisieren

- CRMs bereinigen und deduplizieren

- Job-Postings von 19 Boards gleichzeitig scrapen

- LinkedIn Sales Navigator scrapen, ohne Deinen Account zu riskieren

Was Datablist wirklich anders macht: Es wurde von Grund auf so gebaut, dass technische Reibung komplett wegfällt. Statt dass Du Website-Strukturen verstehen oder auf HTML-Elemente klicken musst, nutzt Datablist AI, die Klartext-Anweisungen versteht.

📘 Datablist Zusammenfassung

Best For: Non-Technical User, die wirklich No-Code Scraping plus ein komplettes Lead-Generation-Ökosystem wollen – inklusive Data Enrichment, Cleaning, Deduplication und Automation.

Key Strengths

- AI-powered scraping in Klartext – ohne technisches Know-how

- 60+ Lead-Generation-Tools in einer Plattform

- Schneller, wirklich hilfreicher Support

Pricing: Ab $25/Monat inkl. 5.000 free Credits pro Monat

User Friendliness: ⭐⭐⭐⭐ (4/5) – Ohne den Sign-up Schritt trifft Datablist den 3-Step-Benchmark bei Template-Use-Cases. Für komplett eigene Use Cases sind’s eher 4 Schritte.

Usefulness: ⭐⭐⭐⭐⭐ (5/5) – Kann praktisch jede Website ohne Login scrapen, plus 60+ weitere Tools

Pricing: ⭐⭐⭐⭐⭐ (5/5) – Sehr günstig und flexibel dank Credit-System

Benutzerfreundlichkeit: So schneidet Datablist ab

Datablist erfüllt den 3-Step-Benchmark:

- AI Agent und ein fertiges Template auswählen

- Limits setzen und Outputs auswählen

- Scraper starten

Kein technisches Know-how nötig. Kein HTML/CSS-Verständnis. Kein Rumklicken auf Websites.

Spreadsheet-Interface: Ab Tag 1 vertraut

Datablist nutzt ein Spreadsheet-Interface, das jeder sofort versteht, der schon mal mit Excel oder Google Sheets gearbeitet hat. Die Oberfläche selbst hat praktisch keine Lernkurve.

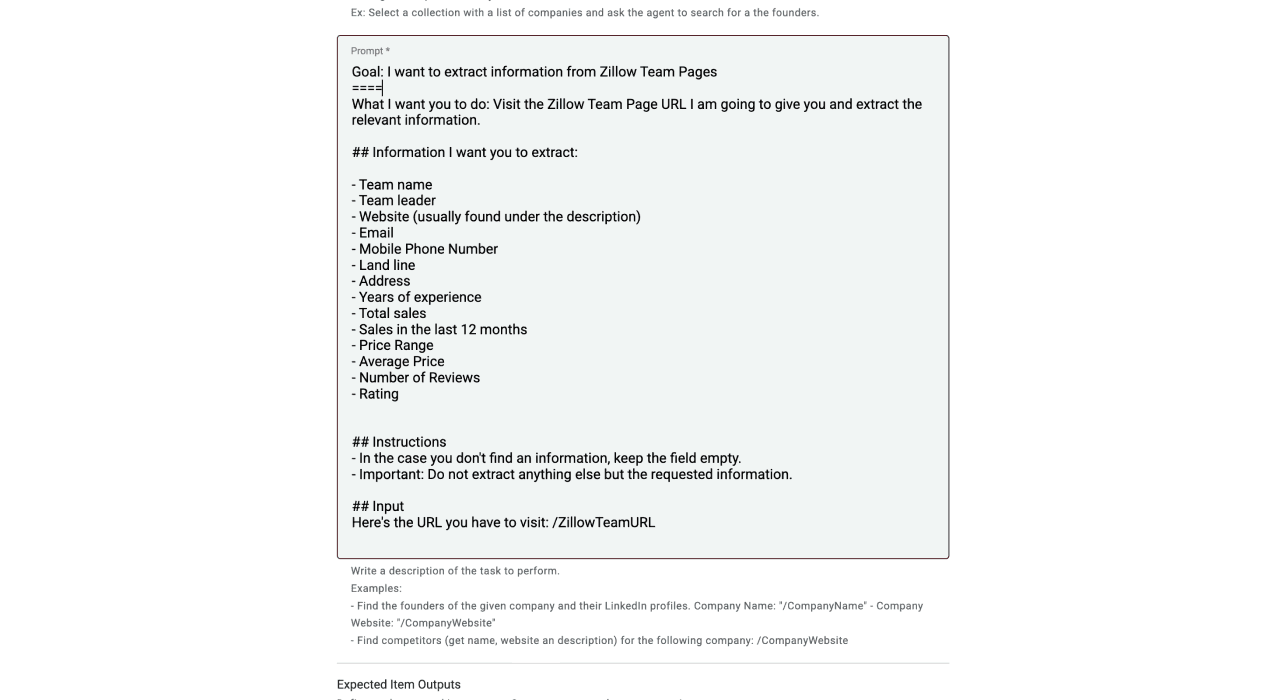

AI Scraper brauchen nur Anweisungen in natürlicher Sprache

Genau das macht es so einfach. Statt Selectors zu konfigurieren oder Elemente anzuklicken, sagst Du der AI einfach, was Du brauchst: „Geh auf diese Website und extrahiere Firmenname, Adresse und Email“

Mehr ist es nicht. Die AI checkt selbst, wie sie durch die Website navigieren muss und wie sie die Daten sauber extrahiert.

Viele sofort nutzbare Templates (mit Konfigurationsoptionen)

Für häufige Use Cases hat Datablist fertige Templates:

- Businesses aus Yellow Pages scrapen

- Immobilien von Zillow scrapen

- Unterkünfte von Airbnb scrapen

- Produkte aus Shopify Stores scrapen

- Case Studies von Websites scrapen

Aber anders als bei vielen Template-only-Tools kannst Du diese Templates bei Bedarf in Klartext anpassen, wenn Du andere Datenpunkte brauchst.

Nutzen: Was Datablist kann

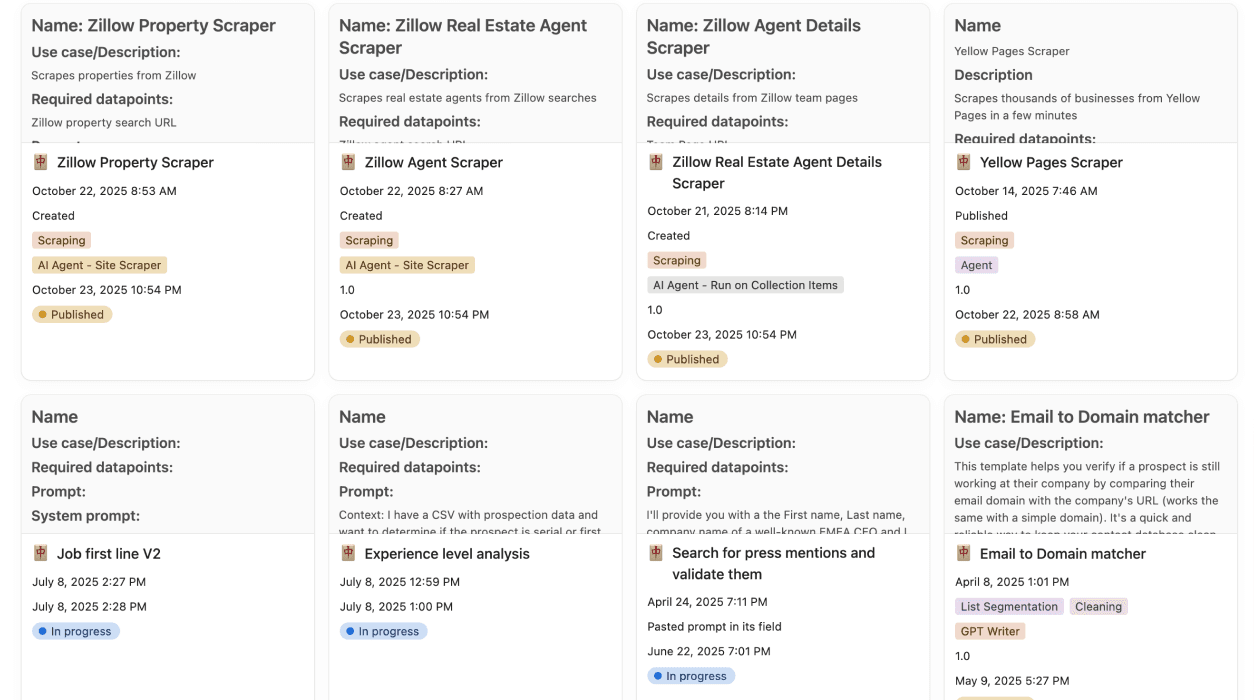

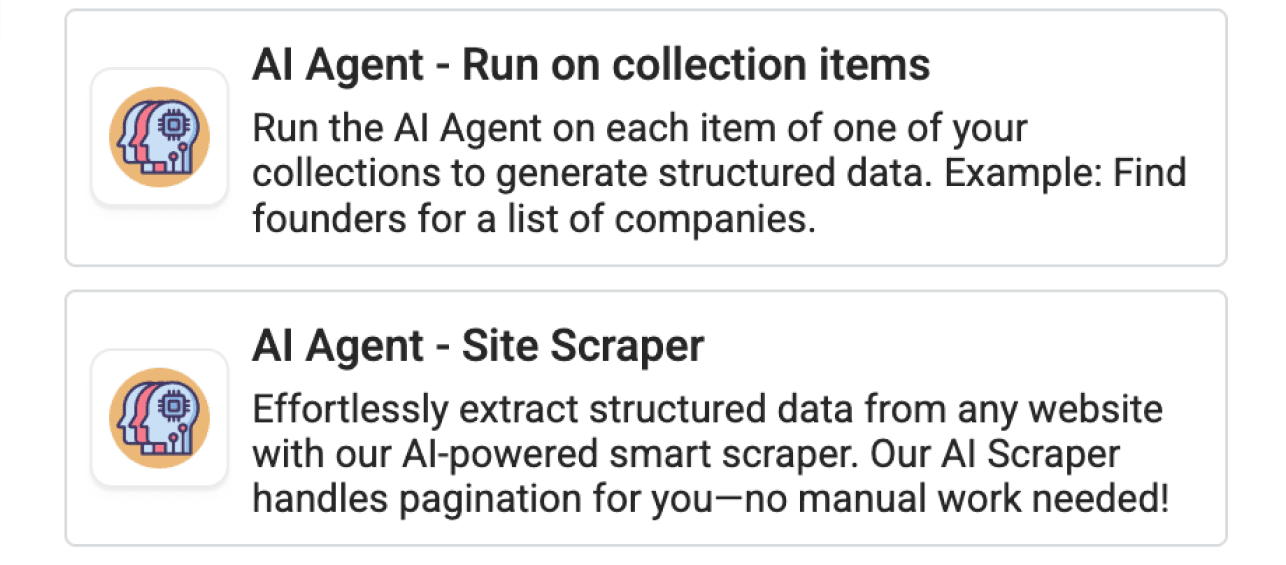

3 AI Agents für unterschiedliche Aufgaben

Datablist bietet mehrere AI Agents, die für unterschiedliche Szenarien optimiert sind. Wir haben 2 Agents fürs Sourcing und einen Agent, der Dir beim Recherchieren, Finden, Extrahieren – oder sogar beim Beantworten von Fragen – hilft.

- AI Scraping Agent: Optimiert, um eine einzelne Website sehr tief zu scrapen

- **AI Research Agent:** Kann mehrere Quellen durchsuchen und AI Search über Listen skalieren

- AI Agent - Run on Collection Items: Research Agent, der Daten sourced und Infos zu Items in anderen Collections recherchiert

Kann praktisch jede Website scrapen

Solange die Website nicht hinter einem Login hängt, kommen Datablist AI Agents damit klar:

- JavaScript-heavy Sites (mit der Option „Render HTML“)

- Paginierte Verzeichnisse

- Komplexe Navigation

- E-Commerce-Kataloge

- Directory-Listings

Data Enrichment, Cleaning und Advanced Deduplication

Über Scraping hinaus bietet Datablist über 60 Tools:

- Waterfall Email Finders: Verifizierte Email-Adressen finden

- Mobile Phone Number Enrichments: Direkte Telefonnummern bekommen

- LinkedIn Scraper: Daten aus LinkedIn-Profilen extrahieren

- Sales Navigator Scraper: Sales Navigator sicher scrapen

- AI Processors: Daten mit AI transformieren und bereinigen

- Deduplication Tools: Duplikate smart entfernen

- Technology Enrichments: Herausfinden, welchen Tech Stack Firmen nutzen

Heißt: Du kannst eine Liste scrapen, sie mit Emails und Telefonnummern anreichern, die Daten säubern und für Outbound vorbereiten – alles in einer Plattform.

Datablist’s enrichments

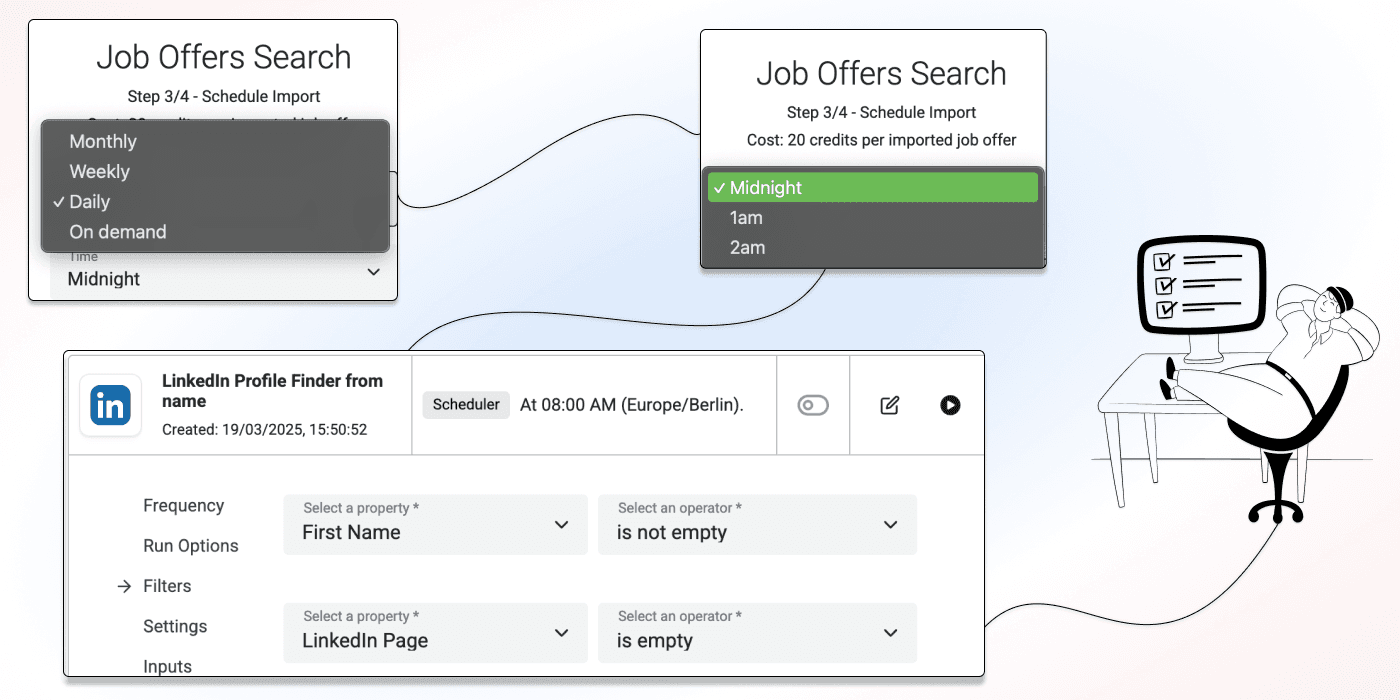

Wiederkehrende Automations

Mit Datablist kannst Du automatisierte Workflows bauen, die nach Zeitplan oder on demand laufen. Du kannst mehrere Aktionen miteinander verketten:

- Täglich ein Directory scrapen

- Websites für neue Einträge finden

- Mit Firmendaten enrichen

- Ins CRM exportieren

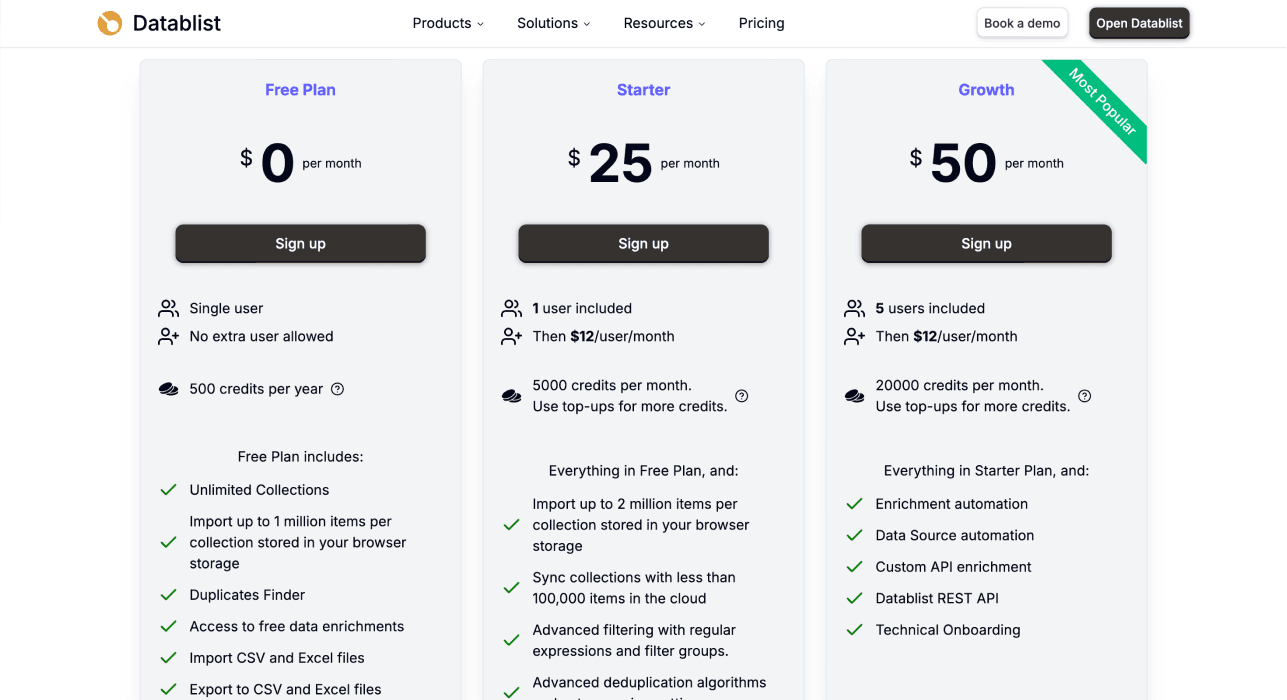

Pricing: Transparent und flexibel

Starting Price: $25/month

Was Du bekommst:

- 5.000 free Credits jeden Monat inklusive

- Zugriff auf alle 60+ Tools der Plattform

- Flexible Credit-Top-ups (Du musst nicht direkt Deinen ganzen Plan upgraden)

- Keine aufdringlichen Sales Calls „zum Einchecken“

Credit-System:

- Usage-based Pricing

- Du zahlst nur für erfolgreiche Operations

- Kosten variieren je nach Komplexität (Directories sind günstiger als JavaScript-heavy Sites)

- Beispiel: 700 Zillow-Properties scrapen kostet ca. 1.000–1.500 Credits

Warum dieses Preismodell funktioniert

Während Wettbewerber Dich oft in teure Monatspläne drücken, sorgt Datablist’s flexibles Credit-System dafür:

- Du kannst klein starten und in Ruhe testen

- Credits leer? Dann kaufst Du einmalig nach, statt upgraden zu müssen

- Keine langfristigen Verträge oder Commitments

Octoparse: Der Click-and-Point-Pionier

Octoparse gehört zu den Pionieren beim visuellen Web Scraping. Es ist ein Click-and-Point-Tool, das im Sinne von „Du schreibst keinen Code“ tatsächlich no-code ist. Trotzdem musst Du verstehen, wie Websites aufgebaut sind, um wirklich effizient damit zu arbeiten.

📘 Octoparse Zusammenfassung

Best For: User, die visuelle Interfaces mögen und Zeit investieren wollen, um Website-Strukturen zu verstehen

Key Strength: Reifes Point-and-Click-Interface mit guter Doku und vielen Tutorials

Pricing: Ab $83/Monat

User Friendliness: ⭐⭐⭐ (3/5) – Erfordert Verständnis für Website-Strukturen

Usefulness: ⭐⭐⭐⭐ (4/5) – Kommt mit den meisten Websites klar, bricht aber bei Strukturänderungen

Pricing: ⭐⭐ (2/5) – Teuer für Einzelpersonen und kleine Teams

Benutzerfreundlichkeit: Die Lernkurve

Octoparse erfüllt den 3-Step-Benchmark NICHT. Der typische Workflow sieht so aus:

- Desktop-App herunterladen und installieren

- Die Website öffnen, die Du scrapen willst

- Elemente anklicken, um Octoparse „beizubringen“, was extrahiert werden soll

- Pagination und Navigation konfigurieren

- Scraper testen und debuggen

- Extraction laufen lassen

Die versteckte Komplexität

Auch wenn Du keinen Code schreibst, machst Du am Ende trotzdem Tech-Arbeit:

- Du lernst, die richtigen HTML-Elemente zu erkennen

- Du verstehst, warum Pagination auf manchen Seiten anders funktioniert

- Du troubleshootest, wenn die falschen Daten ausgewählt werden

- Du schaust Tutorials, um Best Practices zu verstehen

Das größte Problem: Wenn eine Website ihre Struktur ändert, musst Du oft alles neu konfigurieren. Heißt: wieder Tutorials, wieder neu bauen.

Keine Web App verfügbar

Du musst Octoparse lokal installieren. Es gibt keine browserbasierte Alternative – das macht den Einstieg unnötig „hakelig“.

Nutzen: Was Octoparse kann

Kommt mit den meisten Websites klar

Octoparse kann scrapen:

- Statische HTML-Seiten

- JavaScript-heavy Pages (mit integriertem Browser-Rendering)

- Paginierte Verzeichnisse

- Sites mit AJAX-Loading

Begrenztes Ecosystem

Octoparse ist primär auf Scraping fokussiert. Für Data Enrichment oder Contact Data musst Du exportieren und mit anderen Tools weiterarbeiten.

Cloud-Based Automation

In höheren Plänen gibt’s Cloud Scraping. Damit kannst Du Jobs planen, ohne dass Dein Computer laufen muss.

Pricing: Premium-Positionierung

Starting Price: $83/month (jährliche Abrechnung)

Was Du bekommst:

- Desktop-App

- Begrenzte Anzahl an Tasks und Pages pro Monat

- Basic Automation Features

- Cloud Scraping erst in höheren Tiers

Warum dieses Pricing ein Hindernis ist

Mit $83/Monat ist Octoparse für viele Einzelpersonen und kleine Teams zu teuer, wenn sie nur gelegentlich Daten scrapen. Für Power-User passt das, aber die Einstiegshürde ist hoch.

Outscraper: Die günstige Template-Option

Outscraper ist ein template-basierter Scraping-Service, der sich auf Daten aus bekannten Directories und Plattformen wie Google Maps, Yellow Pages und Social Media fokussiert (sie bieten auch API’s).

📘 Outscraper Zusammenfassung

Best For: User, die nur aus unterstützten Directories scrapen müssen und die günstigste Option suchen

Key Strength: Sehr günstiger Einstieg und fertige Templates für populäre Directories

Pricing: Ab $10, einmaliger Credit-Kauf

User Friendliness: ⭐⭐⭐⭐ (4/5) – Easy, wenn Dein Use Case zum Template passt

Usefulness: ⭐⭐ (2/5) – Beschränkt auf Templates (und API’s)

Pricing: ⭐⭐⭐⭐⭐ (5/5) – Günstigster Einstieg

Benutzerfreundlichkeit: Einfach, aber limitiert

Outscraper erfüllt den 3-Step-Benchmark, wenn Dein Use Case zu einem Template passt:

- Template für das Directory auswählen

- Suchparameter eingeben

- Scraper starten

Nur: Diese Einfachheit hat eine ziemlich harte Grenze.

Du kannst nur über ihre Templates scrapen

Outscraper bietet kein Custom Scraping. Wenn es kein fertiges Template für Deine Website gibt, hast Du Pech. Du kannst damit nicht scrapen:

- Die Website Deiner Konkurrenz

- Ein Nischen-Directory in Deiner Branche

- Beliebige Custom-Websites

Das begrenzt den Nutzen extrem.

Nutzen: Beschränkt auf unterstützte Sites

Stark bei bestimmten Directories

Outscraper hat sehr gute Templates für:

- Google Maps Business Listings

- Yellow Pages

- Trustpilot Reviews

- Google Search Results

- Social Media Profiles (eingeschränkt)

Keine Customization oder Flexibilität

Weil Du in Templates festhängst, kannst Du nicht:

- Andere Datenfelder anfordern

- Die Extract-Logik anpassen

- Sites scrapen, die nicht in ihrem Katalog sind

Kein Ecosystem

Outscraper ist ein reiner Scraping-Service. Für Enrichment oder verifizierte Contact Data musst Du exportieren und andere Tools nutzen.

Pricing: Der günstigste Einstieg

Starting Price: $10 einmaliger Credit-Kauf

Was Du bekommst:

- Pay-as-you-go Credit-System

- Zugriff auf alle fertigen Templates

- Kein Monthly Commitment

Warum dieses Pricing für manche perfekt ist

Wenn Du nur ab und zu Google Maps oder Yellow Pages scrapen willst, ist Outscraper schwer zu schlagen. Die Eintrittshürde ist minimal.

Aber: Weil es nur Template-Scraping ist, werden die meisten irgendwann ein flexibleres Tool brauchen.

Apify: Der Marketplace für Tech-Savvy User

Apify ist ein Marketplace für fertige „Actors“ (einzelne Scraping-Skripte) für bestimmte Websites und Use Cases. Stell Dir das wie einen App Store fürs Web Scraping vor.

📘 Apify Zusammenfassung

Best For: Tech-Savvy User, die Auswahl wollen und kein Problem damit haben, an Konfigurationen zu schrauben

Key Strength: Riesiger Marketplace mit Actors für fast jede Website, die Dir einfällt

Pricing: Free Tier verfügbar, Paid Plans ab $49/Monat

User Friendliness: ⭐⭐ (2/5) – Schwankt stark je nach Actor

Usefulness: ⭐⭐⭐⭐ (4/5) – Unfassbare Auswahl, aber inkonsistente Qualität

Pricing: ⭐⭐⭐ (3/5) – Kann günstig oder teuer sein, je nach Nutzung

Benutzerfreundlichkeit: Inkonsistente Experience

Apify erfüllt den 3-Step-Benchmark NICHT. Die Experience hängt extrem vom Actor ab:

Bei einfachen Actors:

- Actor finden

- URL oder Suchparameter eingeben

- Actor starten

Bei komplexen Actors:

- Actor finden

- Doku lesen, um die Optionen zu verstehen

- Mehrere Input-Parameter konfigurieren

- Proxy-Settings und Anti-Bot-Maßnahmen verstehen

- Actor starten und hoffen, dass es läuft

- Debuggen, wenn nicht

Das Kernproblem

Die meisten Actors werden nicht von Apify gebaut oder gepflegt, sondern von der Community. Bedeutet:

- Qualität schwankt stark

- Doku ist manchmal dünn oder veraltet

- Actors brechen, wenn Websites sich ändern

- Support hängt vom Creator ab

Nutzen: Unschlagbare Auswahl

Für fast alles gibt’s einen Actor

Im Marketplace gibt’s Actors für:

- Social Media Scraping (Instagram, Twitter, Facebook, LinkedIn)

- E-Commerce (Amazon, eBay, Shopify)

- Search Engines (Google, Bing)

- Travel Sites (Booking.com, Airbnb, TripAdvisor)

- Business Directories

- News Sites

- ...und tausende mehr

Wenn Du eine Website scrapen willst, gibt’s ziemlich wahrscheinlich einen Actor dafür.

Custom Actor Development

Für fortgeschrittene User erlaubt Apify, eigene Actors in JavaScript zu bauen. Das ist maximale Flexibilität – aber es hebelt den No-Code-Gedanken natürlich aus.

Begrenztes Ecosystem

Wie Octoparse und Outscraper ist Apify stark aufs Scraping fokussiert. Für die Nutzung Deiner Daten brauchst Du meist andere Tools, auch wenn Du es an Zapier, Make etc. anbinden kannst.

Pricing: Variable Kosten

Starting Price: Free Tier verfügbar, Paid Plans ab $49/Monat

Was Du bekommst:

- Zugriff auf den Actor Marketplace

- Credit-basiertes System

- Cloud-Ausführung

- Scheduling und Automation

Warum Pricing tricky sein kann

Apify’s Kosten hängen stark ab von:

- Den Actors, die Du nutzt (manche sind deutlich teurer)

- Der Datenmenge

- Proxy-Anforderungen

Bei datenintensiven Jobs kann das schnell teuer werden. Zum Testen ist der Free Tier super – für ernsthafte Nutzung brauchst Du meistens einen Paid Plan.

Browse AI: Monitoring und simples Scraping

Browse AI positioniert sich als einfaches Scraping-Tool mit Fokus auf Monitoring von Website-Änderungen. Es arbeitet wie Octoparse mit Point-and-Click, aber browserbasiert.

📘 Browse AI Zusammenfassung

Best For: Website-Änderungen monitoren und einfache Scraping-Tasks mit einem einfachen Interface

Key Strength: Stark bei Price Tracking, Stock-Updates und Content-Änderungen

Pricing: Free Tier verfügbar, Paid Plans ab $49/Monat

User Friendliness: ⭐⭐⭐ (3/5) – Einfaches Interface, aber Element-Auswahl kann nerven

Usefulness: ⭐⭐⭐ (3/5) – Top fürs Monitoring, limitiert bei komplexem Scraping

Pricing: ⭐⭐⭐ (3/5) – Fair für Light Usage

Benutzerfreundlichkeit: Schnell gestartet, schwer sauber gemacht

Browse AI erfüllt den 3-Step-Benchmark teilweise:

- Browser-Extension installieren

- Elemente anklicken, die extrahiert werden sollen

- Robot speichern und starten

Allerdings gibt’s ein echtes Problem bei der Element-Auswahl.

Das Problem mit der Element-Auswahl

Wenn Du z. B. eine Telefonnummer anklickst, kann es passieren, dass Browse AI auswählt:

- Den kompletten Kontaktbereich statt nur die Nummer

- Ein Parent-Element, das zusätzlichen Text enthält

- Mehrere Datenpunkte, die zusammen „verklebt“ sind

Dadurch bekommst Du häufig gemischte Ergebnisse, die nach dem Scrape manuell bereinigt werden müssen. Das wirkt am Anfang leicht – kostet Dich am Ende aber Zeit beim Nacharbeiten.

Nutzen: Für Monitoring gebaut

Stark bei Change Detection

Browse AI ist sehr gut für:

- Preisänderungen in Shops monitoren

- Inventory-/Stock-Updates tracken

- Content-Änderungen bei Wettbewerbern erkennen

- Alerts, wenn sich bestimmte Elemente ändern

Limitiert für One-Time Scraping

Für große oder komplexe Scraping-Projekte ist Browse AI weniger geeignet:

- Element-Auswahl-Probleme führen zu Data-Quality-Issues

- Skalierung auf tausende Seiten ist mühsam

- Kein Data Enrichment, aber Integrationen mit Make, Zapier etc.

Pricing: Mid-Range-Option

Starting Price: Free Tier verfügbar, Paid Plans ab $49/Monat

Was Du bekommst:

- Browser-Extension

- Geplantes Monitoring und Alerts

- Cloud-basierte Robots

- Begrenzte Credits in niedrigeren Tiers

Value Proposition

Browse AI lohnt sich, wenn Monitoring Dein Haupt-Use-Case ist. Für große Datasets oder komplexe Websites sinkt der Value wegen der Element-Auswahl-Probleme.

Fazit: Welches Tool passt zu Dir?

Nach der Bewertung aller fünf Tools anhand der neuen Benchmarks ergibt sich dieses Bild:

Bester No-Code Scraper insgesamt: Datablist

Datablist gewinnt in allen drei Benchmarks:

- User Friendliness: Die einzige Lösung, die wirklich No-Code ist und kein technisches Wissen verlangt

- Usefulness: Kann praktisch jede Website scrapen und bietet 60+ Lead-Gen- & Automation-Tools

- Pricing: Das günstigste und flexibelste Credit-System mit klarem Value

Nimm Datablist, wenn:

- Du wirklich No-Code Scraping in Klartext willst

- Du mehr willst als „nur Scraping“ (Lead Gen, Enrichment, Cleaning, Automation)

- Du das beste Preis-Leistungs-Verhältnis suchst

Beste Desktop-Option: Octoparse

Octoparse ist solide, wenn Dich die Lernkurve nicht abschreckt.

Nimm Octoparse, wenn:

- Du bereit bist, Zeit in Website-Struktur und das Tool zu investieren

- Du Desktop-basiertes Scraping mit erweiterten Features brauchst

- Budget nicht Dein Hauptkriterium ist

Beste Budget-Option: Outscraper

Outscraper ist unschlagbar günstig – aber nur für bestimmte Directories.

Nimm Outscraper, wenn:

- Du nur Google Maps, Yellow Pages oder andere unterstützte Directories scrapen willst

- Du den absolut günstigsten Einstieg suchst

- Du kein Custom Scraping brauchst

Am besten für Auswahl: Apify

Apify’s Marketplace ist in der Breite schwer zu schlagen.

Nimm Apify, wenn:

- Du tech-savvy bist und mit Konfiguration klarkommst

- Du eine sehr spezifische Website scrapen musst und es dafür einen Actor gibt

- Du mit schwankender Qualität und Doku leben kannst

Am besten fürs Monitoring: Browse AI

Browse AI ist genau für Change Detection gebaut.

Nimm Browse AI, wenn:

- Du Websites vor allem auf Änderungen monitoren willst

- Du Price Tracking oder Inventory Alerts brauchst

- Du keine großflächige Data Extraction brauchst

Schluss: Die Messlatte muss höher

Seit AI breit eingesetzt wird, hat sich in der No-Code-Scraping-Welt viel verändert – und damit sollten sich auch die Benchmarks ändern, nach denen wir die besten No-Code Scraper vergleichen.

Die alte Bewertungslogik hat Tools gegen Coding verglichen. Das ist nicht das, was User wirklich wollen. Wenn Du nach einer No-Code-Lösung suchst, willst Du etwas, das so einfach ist wie Schuhe binden oder Eier kochen – nicht etwas, das nur „leichter als Python“ ist.

Dieser Artikel hat neue Benchmarks eingeführt:

- User Friendliness: Trifft das Tool den 3-Step-Benchmark? Brauchst Du wirklich keinerlei technisches Wissen?

- Usefulness: Kann es komplexe Sites scrapen? Gibt es Enrichment und Automation? Gibt es ein Ecosystem?

- Pricing: Ist es bezahlbar für Einzelpersonen und kleine Teams?

Nach diesen Benchmarks ist Datablist für die meisten Nutzer der klare Sieger – und ehrlich gesagt das einzige Tool, das das Versprechen von echtem No-Code Scraping einlöst und gleichzeitig ein komplettes Lead-Generation-Ökosystem zu einem bezahlbaren Preis liefert.

FAQ zu No-Code-Scraping-Tools

Welches Scraping-Tool ist am einfachsten zu bedienen?

Datablist ist das am einfachsten zu bedienende Scraping-Tool, weil Du dafür wirklich zero technisches Know-how brauchst. Auch wenn Datablist nicht primär ein Scraper ist, kannst Du mit dem AI Agent in Klartext beschreiben, was Du willst – ohne HTML, CSS oder Website-Strukturen verstehen zu müssen. Während andere „No-Code“-Tools Dich immer noch auf Elemente klicken lassen oder Selectors verlangen, ist Datablist tatsächlich stressfrei.

Welche No-Code Scraper sind die besten?

Die besten No-Code Scraper 2025 sind:

- Datablist – Bestes Gesamtpaket für wirkliches No-Code Scraping mit AI und Klartext. Plus 60+ Lead-Generation-Tools. Ab $25/Monat.

- Octoparse – Am besten für alle, die mit Point-and-Click gut klarkommen. Erfordert Verständnis für Website-Strukturen. Ab $83/Monat.

- Outscraper – Beste Budget-Option für unterstützte Directories wie Google Maps. Beschränkt auf Templates. Ab $10.

- Apify – Beste Auswahl mit tausenden fertigen Actors. Qualität schwankt, braucht technische Sicherheit. Ab $49/Monat.

- Browse AI – Am besten fürs Monitoring von Website-Änderungen und Price Tracking. Element-Auswahl kann nerven. Ab $48/Monat.

Welche Scraper sind am besten für Non-Technical User?

Unter den No-Code-Scrapern ist Datablist die beste Option für Non-Technical User, weil es alle technischen Hürden entfernt. Du beschreibst einfach in Klartext, welche Daten Du willst – und die AI erledigt den Rest. Kein HTML, kein CSS, keine Selectors, keine Website-Architektur.

Octoparse ist die zweitbeste Option für Non-Technical User, die bereit sind, Zeit in ein Point-and-Click-Tool zu investieren. Es braucht kein Coding – aber es verlangt, dass Du verstehst, wie Websites strukturiert sind. Und genau das ist für viele wirklich Non-Technical User der Knackpunkt.

Welches Tool ist am besten für paginierte Websites?

Datablist ist das beste Tool für paginierte Websites, weil der AI Agent Pagination automatisch handhabt – ohne dass Du Logik manuell konfigurieren musst. Du aktivierst Pagination, setzt die Anzahl Seiten und die AI navigiert automatisch durch alles durch.

Andere Tools wie Octoparse und Apify können Pagination auch, aber Du musst die Logik oft manuell bauen, „Next Page“-Buttons identifizieren und troubleshootten, wenn sich Muster ändern. Datablist’s AI passt sich automatisch an.