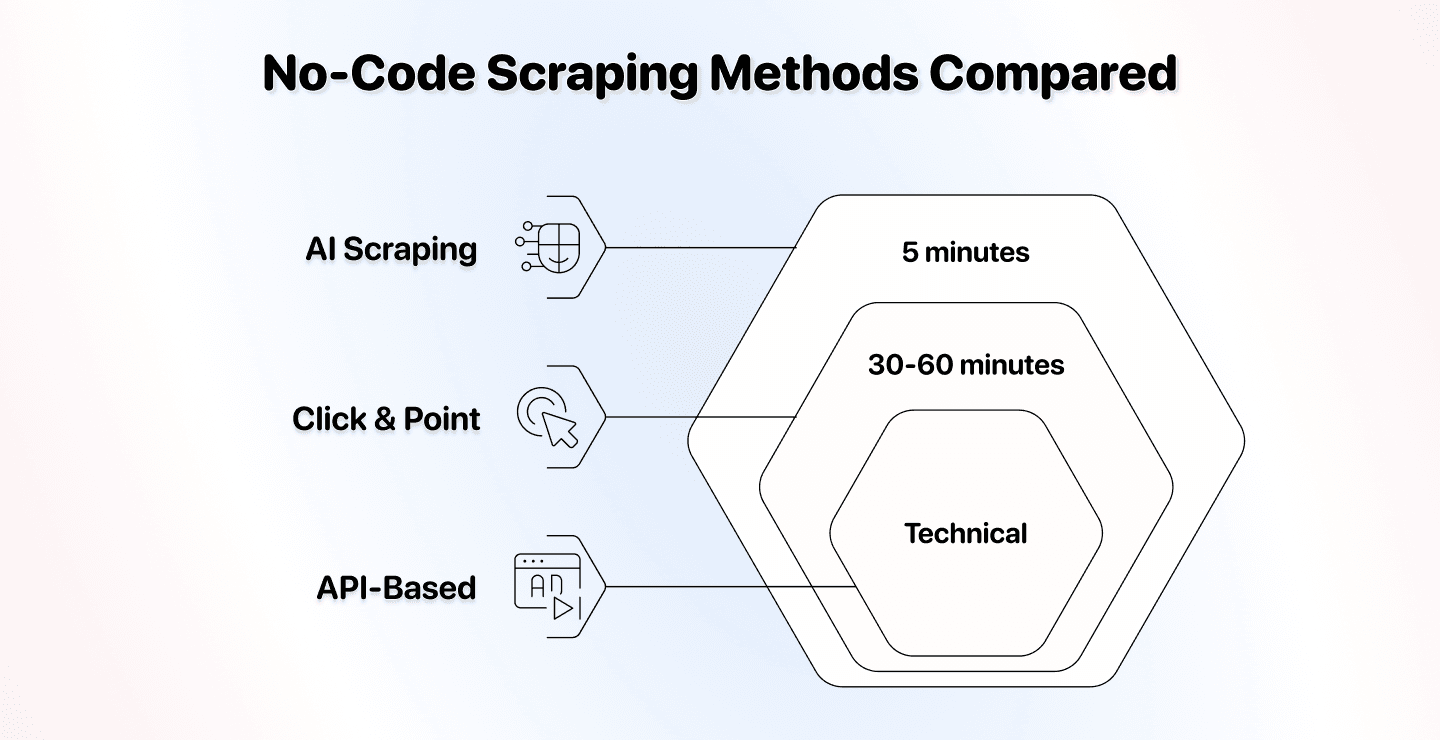

Die Welt des no-code scraping kennt drei klar unterschiedliche Methoden – und wenn Du die falsche wählst, kostet Dich das unnötig Zeit und Geld.

Wir haben AI scraping, klassisches no-code scraping und API-based scraping miteinander verglichen, damit Du die echten Unterschiede siehst. Kein Marketing-Blabla – nur Fakten zu Setup-Zeit, Flexibilität, Preis und den besten Use Cases.

Nach diesem Guide weißt Du ganz genau, welche Methode zu Deinem Setup passt.

📌 Kurzfassung für Eilige

Dieser Artikel vergleicht drei no-code scraping Methoden, damit Du für Deine Projekte die richtige auswählst.

Die Frage: Welche no-code scraping Methode solltest Du für Deine Projekte nutzen?

Was wir verglichen haben: AI scraping, klassische Click-and-Point Tools und API-based Scraper – nach Setup-Aufwand, Flexibilität, Preis, Use Cases und den besten Tools.

Die schnelle Antwort:

- AI scraping ist am einfachsten für nicht-technische Nutzer und passt sich an Website-Änderungen an

- Click-and-Point Tools funktionieren am besten, wenn Du maximale Kontrolle brauchst und Websites sich selten ändern

- API-based scraping ist am günstigsten pro Seite, braucht aber technisches Know-how

Was Du lernst: Wie jede Methode funktioniert, worin sie sich unterscheiden, wann Du welche nutzen solltest – und welche Tools am zuverlässigsten liefern.

Was Dich in diesem Artikel erwartet

- AI Scraping: Die Methode, die natürliche Sprache versteht

- Klassisches No-Code Scraping: Click-and-Point Tools

- API Based Scraping: Der technische Mittelweg

- Fazit: Welche Methode solltest Du wählen?

AI Scraping

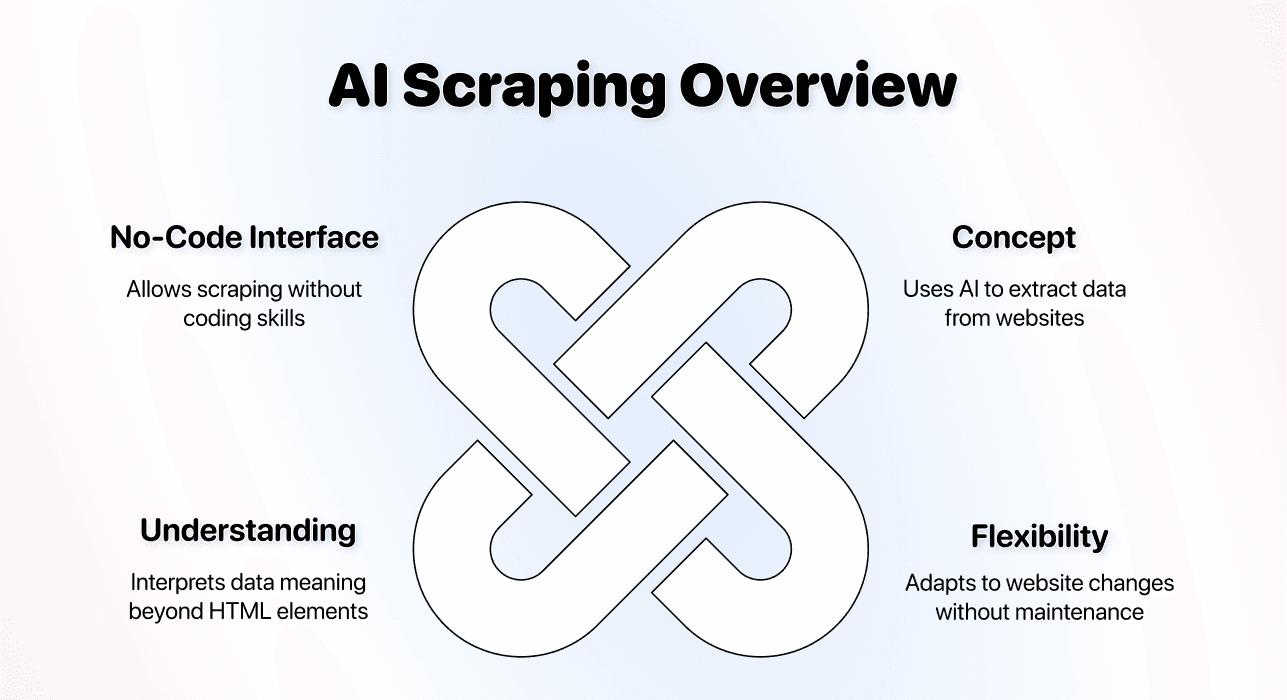

AI scraping ist die modernste Form der no-code Datenextraktion. Statt dass Du der Software Regeln beibringst, versteht sie, was Du willst – und findet selbst heraus, wie sie es bekommt.

Das Prinzip

AI scraping Tools nutzen Large Language Models und Machine Learning, um Daten aus Websites zu extrahieren. Du beschreibst in normaler Sprache, welche Daten Du brauchst – und die AI übernimmt den technischen Teil.

Du findest dafür verschiedene Begriffe (AI no-code scraping, AI data scraping, AI web scraping) – am Ende ist es immer dasselbe: Webseiten scrapen, ohne Code zu schreiben oder technische Selektoren zu konfigurieren.

Was daran anders ist:

↳ Klassische Scraper folgen starren Regeln, die Du selbst festlegst

↳↳ AI Scraper verstehen Kontext und passen sich Veränderungen an

↳↳↳ Ergebnis: weniger Maintenance und deutlich mehr Flexibilität

Die AI sucht nicht einfach nach bestimmten HTML-Elementen. Sie versteht, dass „Produktpreis“ bedeutet, den Preis eines Artikels zu finden – egal, wie die Website das technisch abbildet.

Setup-Aufwand

AI scraping hat von allen drei Methoden das einfachste Setup.

Der typische Workflow:

- Wähle Dein AI scraping Tool

- Gib die Website-URL ein

- Beschreibe in natürlicher Sprache, welche Daten Du brauchst

- Starte den Scraper

Zeitaufwand: Für die meisten Websites ca. 5 Minuten[1]. Du musst weder HTML noch CSS-Selektoren oder Website-Strukturen verstehen. Die AI findet die relevanten Stellen anhand Deiner Beschreibung.

Hier ist ein Video, in dem ich zeige, wie ich mit einem AI scraping Agent einen E-Commerce-Shop scrape – in 6,04 Minuten 📺

Die wichtigste Fähigkeit: klar formulieren. Wenn Du beschreiben kannst, was Du willst, kannst Du AI scraping in wenigen Minuten einrichten.

Ein paar AI Scraping Templates, die Dir gefallen könnten

Wir bauen für unsere Nutzer regelmäßig Scraping-Templates ❤️. Hier ein paar Beispiele:

- How to scrape the YC Startup directory

- How to scrape properties from Zillow

- How to scrape real estate agents from Zillow

- How to scrape properties from AirBnB

- How to scrape businesses from Yellow Pages

- How to scrape an e-commerce shop

- How to scrape case studies from a website

Diese Templates findest Du auch in der Datablist App und kannst sie mit wirklich nur ein paar Klicks starten. Wenn Du willst, dass wir ein Template speziell für Dich erstellen, melde Dich hier 👈🏽

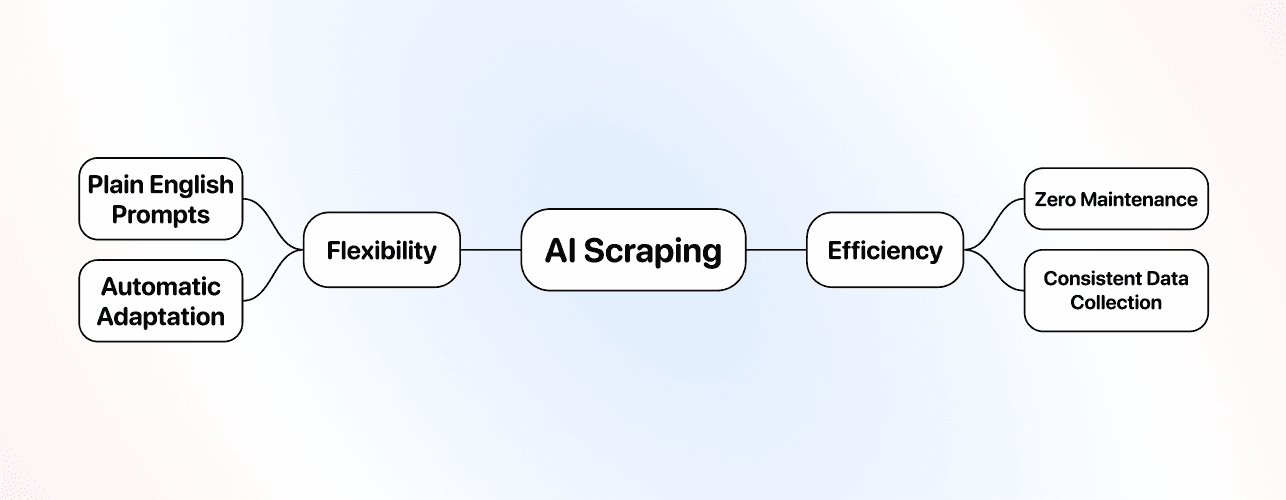

Flexibilität

Hier spielt AI scraping seine größte Stärke aus.

AI scraping passt sich automatisch an, wenn:

↳ Websites ihr Layout redesignen

↳↳ Inhalte an unerwarteten Stellen auftauchen

↳↳↳ Unterschiedliche Seiten unterschiedliche HTML-Strukturen nutzen

Klassische no-code oder Code-Scraper brechen bei Änderungen, weil sie auf konkrete HTML-Elemente angewiesen sind. AI Scraper verstehen Bedeutung – dadurch laufen sie oft weiter, selbst wenn sich die technische Struktur ändert. Heißt: Einmal eingerichtet, funktioniert der Scraper deutlich konstanter.

Beispiel: Du scrapest Produktdaten von mehreren E-Commerce-Seiten. Jede Seite baut ihr HTML anders. Mit AI scraping verwendest Du denselben Prompt – und der AI scraping Agent passt sich an jede Struktur an.

Die Grenze: AI scraping ist am stärksten bei öffentlich sichtbaren Daten. Komplexe Logins oder Auth-Flows hinter einer Login-Wall sind deutlich schwieriger als bei einem custom-built Scraper.

Preis

AI scraping ist pro Vorgang meist teurer als die anderen Methoden, weil Rechenleistung benötigt wird, um Seiten zu verstehen und zu verarbeiten.

Typische Preismodelle:

- Subscription-Pläne mit inkludierten Credits

Was die Kosten treibt:

- JavaScript-lastige Seiten sind teurer (weil Rendering nötig ist)

- Pagination und Multi-Step-Tasks erhöhen die Kosten

- Einfache Directory-Seiten sind günstiger

Praxisbeispiel: 1.000 Business-Listings aus einem Verzeichnis zu scrapen kostet in vielen AI scraping Tools etwa 500–1.000 Credits. Die genauen Kosten hängen von der Seitenkomplexität und der Menge der extrahierten Daten ab.

Lohnt sich das? Für nicht-technische Nutzer: ja. Du zahlst für Zeitersparnis, quasi keine Maintenance und vor allem: Ruhe im Kopf. Man könnte AI scraping auch „headache-free scraping“ nennen.

Use Cases und Best Practices

AI scraping ist besonders stark in Szenarien, in denen Flexibilität und geringe Maintenance zählen.

Beste Use Cases:

- Mehrere Websites mit unterschiedlichen Strukturen scrapen

- Daten extrahieren, wenn Du nicht technisch bist

- Projekte, bei denen Maintenance-Zeit teuer ist

- Situationen, in denen Websites häufig aktualisiert werden

- Unterschiedliche Datentypen, bei denen Kontext wichtig ist

- Du willst weder einen klassischen no-code Scraper noch eine API einrichten

Wann AI scraping die smarte Wahl ist: Du willst Competitor-Websites für Market Research scrapen – aber jede nutzt andere Website-Builder und Layouts. AI scraping löst das mit demselben Prompt.

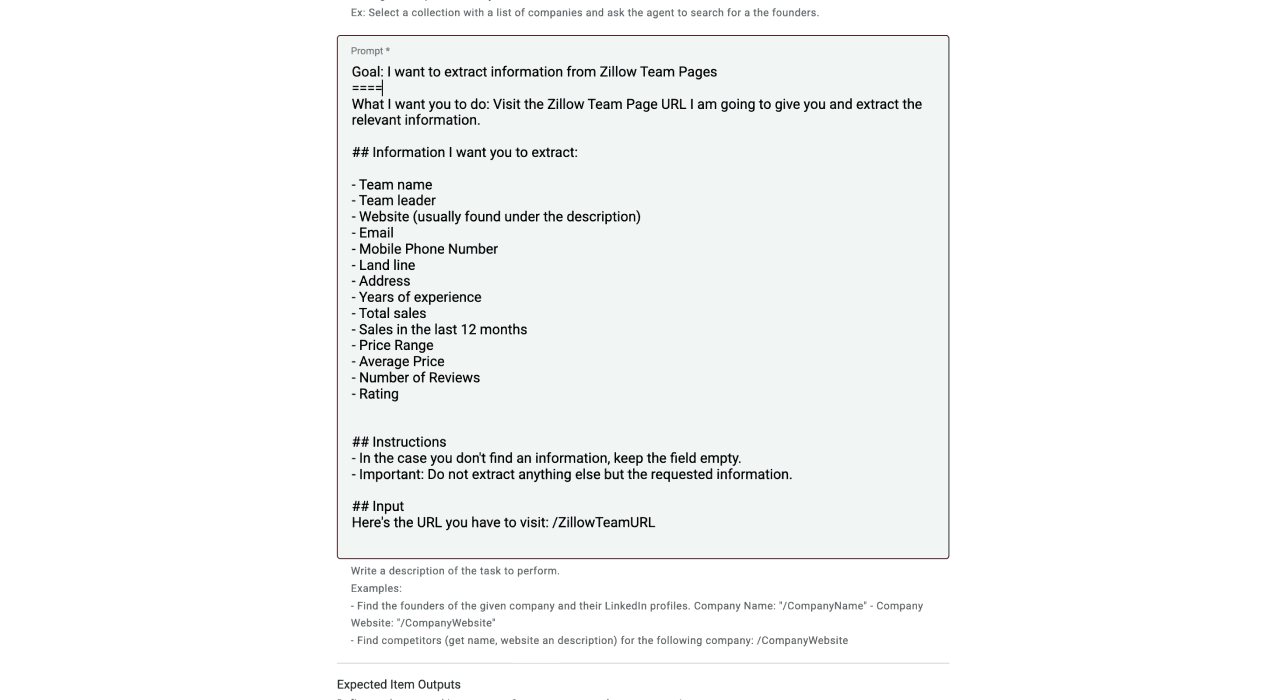

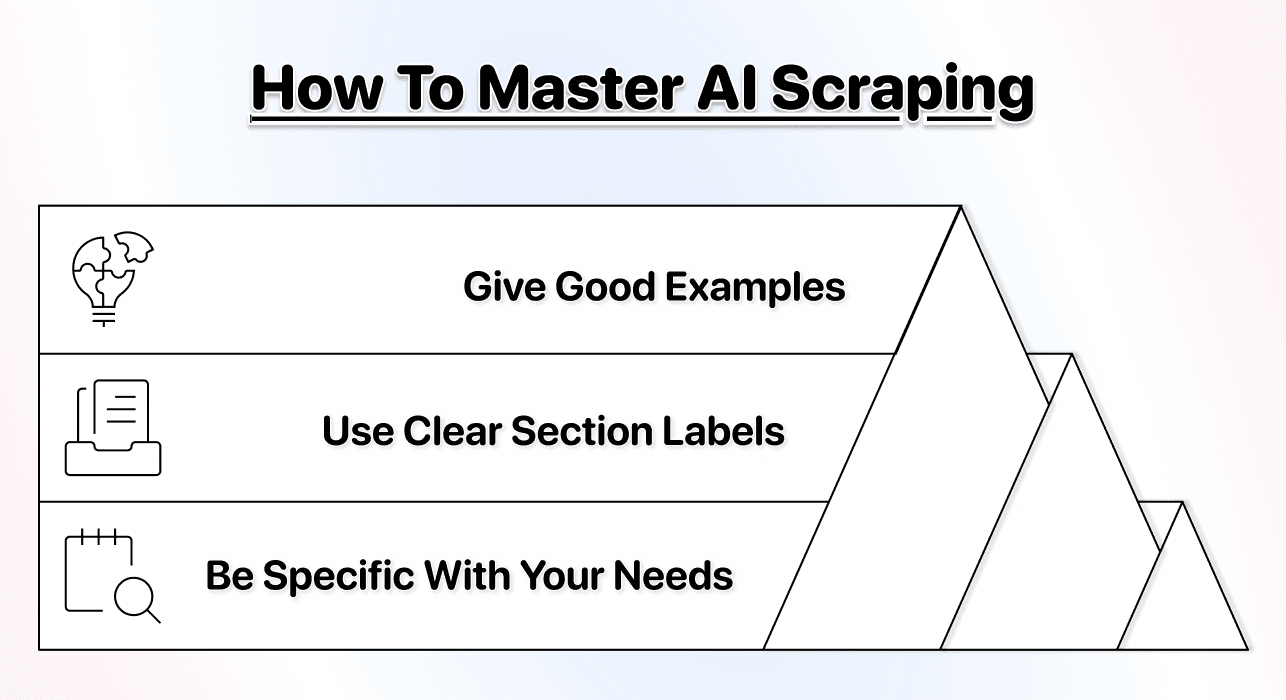

Best Practices für AI scraping:

- Schreibe klare, konkrete Prompts, welche Daten Du brauchst

- Gib Beispiele, wenn möglich – das erhöht die Genauigkeit[2]

- Starte mit kleinen Tests, bevor Du auf große Datensätze skalierst

- Nutze Abschnitt-Labels in Deinen Prompts für bessere Ergebnisse

Hier ist ein hilfreicher Guide, falls Du tiefer einsteigen willst: how to prompt an AI agent 👈🏽

Bestes Tool dafür

Für AI scraping ist Datablist aus unserer Sicht die beste Option für nicht-technische Nutzer[3].

Warum Datablist so gut funktioniert:

- Echtes Prompting in natürlicher Sprache[4] (kein technisches Wissen nötig)

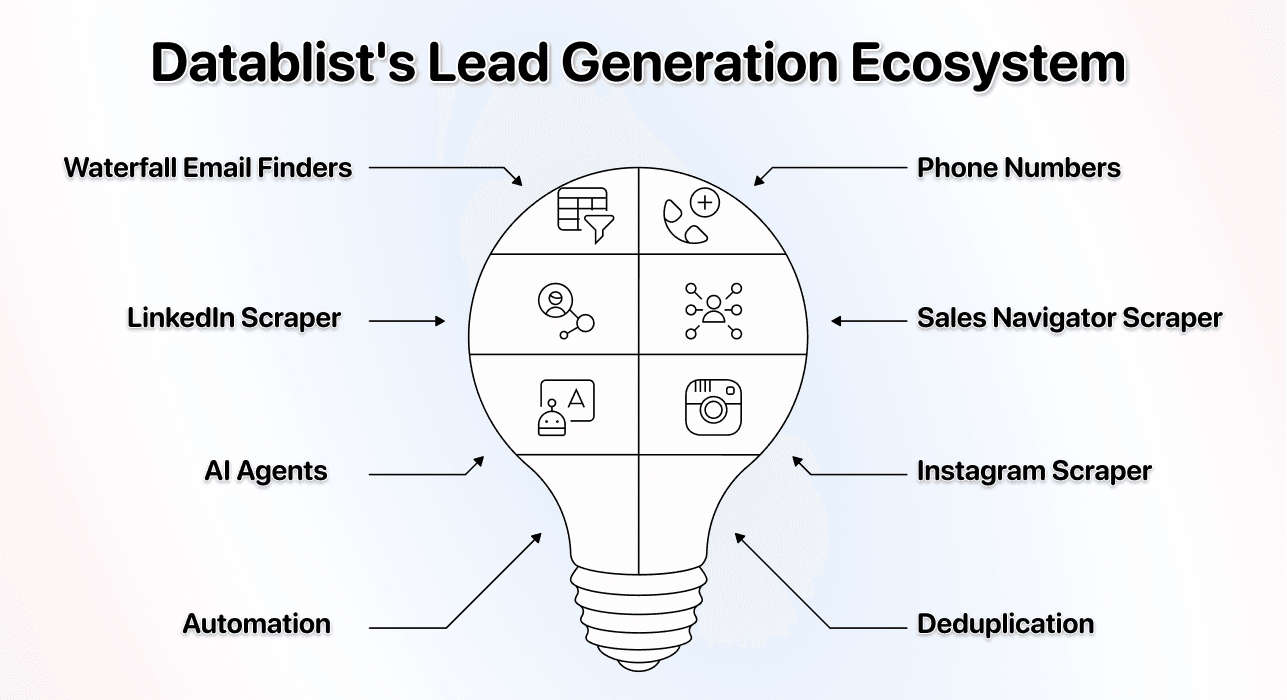

- Mehrere spezialisierte AI Agents für unterschiedliche Scraping-Tasks[5]

- Integriertes Ökosystem mit 60+ lead generation Tools

- JavaScript-Rendering und Pagination laufen automatisch[6]

- Fairer Einstiegspreis ab 25$/Monat

- Integriertes bulk enrichment

Was Datablist anders macht: Datablist ist nicht nur ein AI Scraper. Es ist eine komplette lead generation Plattform, die AI scraping direkt mit email finder, sales navigator scraper und Cleaning-Tools kombiniert. Du kannst eine Liste scrapen und sie sofort mit Kontaktdaten anreichern – ohne Tool-Hopping.

Der größte Vorteil: Du bekommst AI scraping plus eine komplette Workflow-Plattform für Data Enrichment, lead list building oder jeden anderen LeadGen-Workflow – für weniger als viele reine Scraping-Tools allein kosten.

📘 AI Scraping ist technisch gesehen auch No-Code Scraping

AI scraping ist eine Unterkategorie von no-code scraping, weil Du keinerlei Coding-Skills brauchst. Es ist die einfachste no-code Methode, weil Du nur in natürlicher Sprache erklärst, was Du willst – statt Website-Strukturen verstehen zu müssen.

Klassisches No-Code Scraping (Click-and-Point Tools)

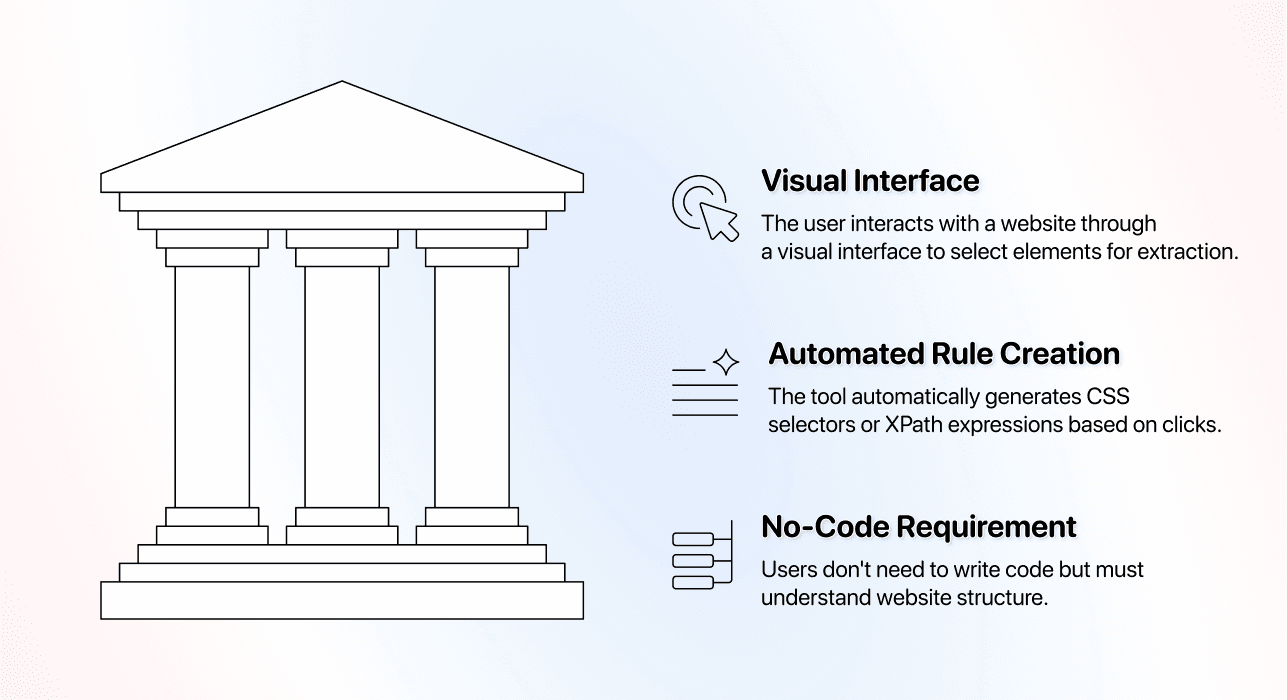

Click-and-Point Scraper waren die ursprüngliche „no-code“ Lösung: Du wählst Daten visuell auf einer Seite aus, statt Code zu schreiben. In diesem Abschnitt nennen wir sie auch „klassischer no-code scraper“.

Das Prinzip klassischer No-Code Scraper

Klassisches no-code scraping funktioniert über visuelle Interfaces: Du klickst auf Elemente einer Webseite und sagst dem Tool damit, was extrahiert werden soll.

Der grundlegende Ablauf: Du öffnest die Website im Tool, klickst auf den Produktnamen, dann auf den Preis, dann auf die Beschreibung. Das Tool merkt sich Deine Klicks und erstellt daraus einen Scraper.

Was im Hintergrund passiert: Das Tool übersetzt Deine Klicks in CSS-Selektoren oder XPath-Ausdrücke. Du schreibst keinen Code – aber Du erzeugst starre technische Regeln, die davon abhängen, dass das HTML der Website gleich bleibt.

Warum das „no-code“ heißt: Du schreibst kein Python oder JavaScript. Trotzdem musst Du verstehen, wie Websites Informationen strukturieren – und oft auch Troubleshooting machen, wenn Elemente nicht sauber ausgewählt werden.

Setup-Aufwand

Click-and-Point Tools haben eine mittlere Lernkurve – und die überrascht viele Einsteiger.

Der Setup-Prozess:

- Tool herunterladen und installieren (viele sind Desktop-Apps)

- Ziel-Website im Tool öffnen

- Jeden Datenpunkt anklicken, den Du extrahieren willst

- Pagination-Regeln konfigurieren (falls nötig)

- Testen, ob die richtigen Daten kommen

- Debuggen, wenn falsche Elemente ausgewählt werden

- Scraper speichern und laufen lassen

Zeitaufwand: 30–60 Minuten für eine mittelkomplexe Website.

❗️ Wichtig zu wissen

Click-and-Point Tools haben eine versteckte Komplexität: Elemente werden nicht immer sauber ausgewählt. Manchmal klickst Du auf eine Telefonnummer und das Tool markiert den kompletten Kontaktbereich – und Du bekommst das nicht wirklich „gefixt“, weil die Ursache in der Website liegt, nicht im Scraper. Wenn Dir das passiert, musst Du die Daten nach dem Scraping bereinigen.

Typische Frustpunkte für Anfänger:

- Du klickst ein Element an, aber es wird etwas völlig anderes selektiert

- Support-Chats werden zur Routine

- Pagination läuft nicht wie erwartet

- Daten landen gemischt statt sauber in getrennten Feldern

- Scraper brechen nach Website-Updates

Für wen es sich leicht anfühlt: Wer tech-affin ist und Tutorials durchzieht, kommt damit gut klar. Rechne aber mit ein paar Stunden Lernzeit, bis Du wirklich produktiv wirst.

Flexibilität

Click-and-Point Tools sind per Design starr. Sie extrahieren exakt das, was Du konfiguriert hast – genau so, wie Du es konfiguriert hast.

Wenn Websites sich ändern, passiert Folgendes:

↳ Layout-Redesigns zerstören Deinen Scraper komplett

↳↳ Kleine CSS-Updates können die Extraktion stoppen

↳ ↳↳ Du baust den Scraper praktisch neu

Maintenance-Belastung: Websites ändern sich ständig. Beliebte E-Commerce-Seiten werden gerne quartalsweise überarbeitet. Jedes Update bedeutet: neu konfigurieren – und das dauert oft genauso lange wie beim ersten Mal.

Mehrere Websites scrapen: Wenn Du fünf Competitor-Websites scrapest, brauchst Du fünf verschiedene Konfigurationen. Und jede bricht unabhängig, sobald diese Website ein Update macht.

Der Vorteil: Wenn Websites selten ändern (z. B. stabile Verzeichnisse oder bestimmte Behörden-Datenbanken), liefern Click-and-Point Tools nach sauberem Setup sehr zuverlässige Ergebnisse.

Preis

Click-and-Point Tools arbeiten meist mit Subscription-Plänen und mehreren Tiers.

Typische Preisstrukturen:

- Einstieg: 50–100$/Monat

- Pro: 150–300$/Monat

- Enterprise: 500$+/Monat

Was Deine Kosten beeinflusst:

- Wie viele Scraping-Tasks Du anlegen kannst

- Wie viele Seiten Du pro Monat scrapen kannst

- Cloud-Scheduling

- Priority Support und Advanced Features

Versteckte Kosten: Deine Maintenance-Zeit. Wenn Du z. B. 5 Stunden pro Monat mit kaputten Scrapers verbringst, ist das ein echter Kostenblock – auch wenn die Subscription „okay“ wirkt.

Kosten/Nutzen: Für Websites, die sich selten ändern, sind Click-and-Point Tools nach dem Setup oft kosteneffektiv. Bei häufigen Änderungen wird es durch die Maintenance schnell teuer. Dann ist ein AI scraping agent häufig die bessere Wahl.

Use Cases und Best Practices

Click-and-Point Tools sind stark in Situationen, in denen ihre Schwächen kaum ins Gewicht fallen.

Beste Use Cases:

- Stabile Websites scrapen, die selten updaten

- Projekte, bei denen Du sehr präzise Kontrolle über die Extraktion brauchst

- Wenn Du immer wieder dieselbe Website scrapest

- Desktop-Workflows, bei denen Cloud-Tools nicht nötig sind

Wann Click-and-Point richtig ist: Du willst eine Behörden-Datenbank scrapen, die zwar täglich neue Einträge hat, aber ihre Struktur nie ändert. Einmal korrekt eingerichtet, zieht das Tool zuverlässig jeden Tag die neuen Daten – vorausgesetzt, das Tool ist grundsätzlich in der Lage, die richtigen Elemente sauber zu extrahieren.

Best Practices:

- Dokumentiere Deine Konfigurationen (für den Moment, wenn es bricht)

- Setze Monitoring auf, um Ausfälle schnell zu merken

- Plane monatliche Maintenance-Zeit ein

- Teste gründlich, bevor Du auf große Datensätze gehst

Wann Du Click-and-Point vermeiden solltest: Wenn Du mehrere moderne Websites scrapest, die sich häufig ändern (z. B. E-Commerce), wird die Maintenance zur Dauerbaustelle. Jedes Update braucht manuelle Arbeit.

Bestes Tool dafür

Octoparse ist eines der etabliertesten Click-and-Point Scraping Tools am Markt.

Übrigens: Hier ist ein aktueller Artikel, in dem ich die besten no-code scrapers nach Bedienbarkeit, Integrationen und Preis verglichen habe 👈🏽

Warum Octoparse:

- Reifes Interface mit jahrelanger Entwicklung

- Viele Tutorials für typische Use Cases

- Desktop-App mit starken Features

- Gute Doku und Community-Support

Die Trade-offs: Octoparse braucht Einarbeitung. Das Interface ist mächtig, aber komplex. Pricing startet bei 83$/Monat – für Einzelpersonen und kleine Teams nicht gerade günstig.

Für wen es passt: Teams, die tech-affin sind, stabile Websites regelmäßig scrapen müssen und Lernkurve + Subscription rechtfertigen können.

💡 Klassische Scraper haben ihren Platz

Click-and-Point Tools sind nicht „schlecht“ – sie haben nur ihre besten Tage hinter sich, seit es mit AI scraping deutlich einfachere Wege gibt. Für alte, kaum veränderte Websites (z. B. bestimmte Behörden-Verzeichnisse) funktionieren sie weiterhin sehr gut.

API Based Scraping

API-based scraping liegt irgendwo zwischen Code und no-code. Du schreibst zwar keine Scraping-Logik, brauchst aber technisches Verständnis, um es sinnvoll zu nutzen.

Das Prinzip

API-based Scraper liefern fertige Endpoints, die Scraping für bestimmte Websites oder Use Cases übernehmen.

So funktioniert’s: Du machst einen API Call mit Parametern (z. B. welche URL gescraped werden soll und welche Daten Du brauchst) – und der Service gibt Dir strukturierte Daten zurück. Die Scraping-Logik ist bereits gebaut; Du steuerst sie nur über Parameter.

Technisch ist es no-code, aber Du musst wissen, wie man API Calls macht, Authentication Tokens nutzt, JSON Responses verarbeitet und das Ganze in Deinen Workflow integriert. Dafür braucht es Programmierkenntnisse oder zumindest Sicherheit mit Tools wie Postman.

Häufige API scraping Ansätze:

- Website-spezifische APIs (z. B. LinkedIn scraper APIs)

- General Scraping APIs, die mit jeder URL funktionieren

- Template-basierte APIs mit vorkonfigurierten Scrapers für bekannte Websites

Warum es Begriffschaos gibt: Manche nennen es „no-code“, weil Du keine Scraping-Logik schreibst. Andere nennen es „low-code“, weil Du technische Skills brauchst. Die Wahrheit liegt dazwischen.

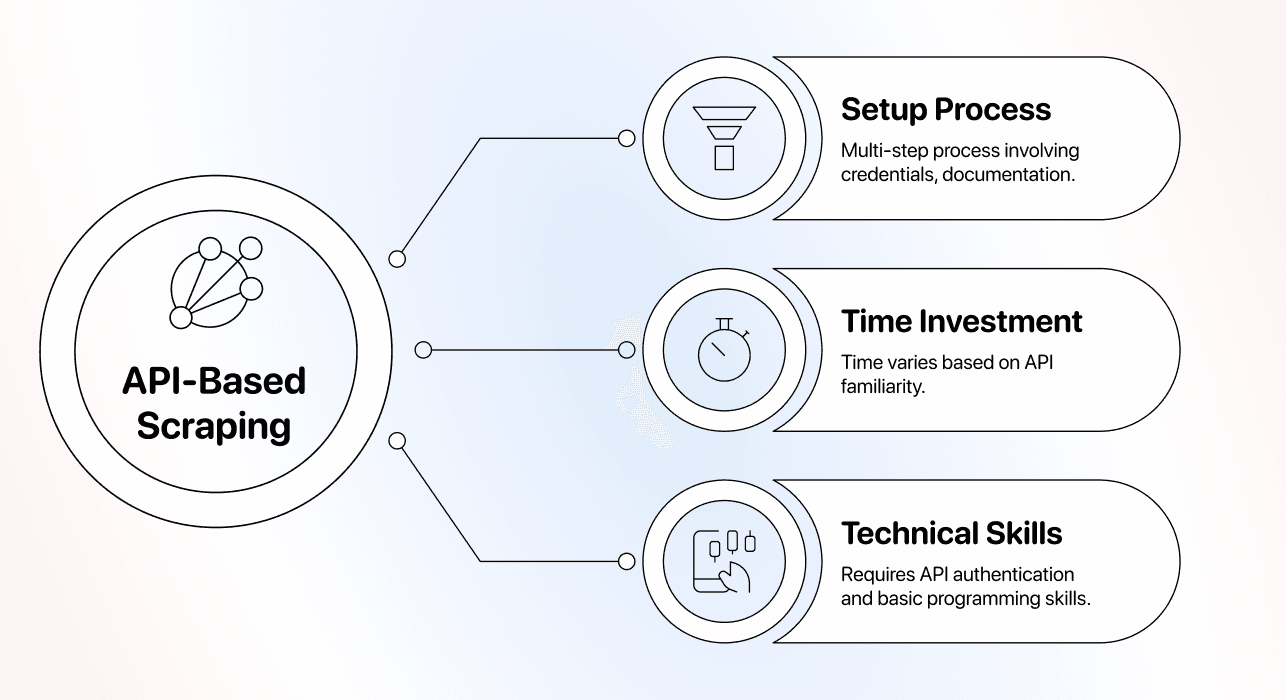

Setup-Aufwand

API-based scraping erfordert technisches Wissen – und ist damit für viele nicht mehr „echtes“ no-code.

Der Setup-Prozess:

- Registrieren und API Credentials holen

- Doku lesen und Parameter verstehen

- API Calls testen (z. B. mit Postman oder curl)

- Authentication und Rate Limiting handhaben

- JSON- oder XML-Response parsen

- Ergebnisse in Deine App oder Deinen Workflow integrieren

- Error Handling für fehlgeschlagene Requests implementieren

Zeitaufwand: 1–2 Stunden, wenn Du mit APIs vertraut bist – deutlich länger, wenn Du es nebenbei lernst.

Technische Skills, die Du brauchst:

- REST APIs und HTTP Requests verstehen

- Mit JSON-Strukturen arbeiten

- Tokens, Headers und Auth sauber handhaben

- Basic Programming für die Integration

Flexibilität

API-based Scraper bieten eine mittlere Flexibilität – und die hängt komplett vom Provider ab.

Was Du steuern kannst: Bei vielen APIs kannst Du Datenfelder auswählen, Rate Limits setzen, Output-Formate wählen und Verhalten über Parameter konfigurieren.

Was Du nicht steuern kannst: Die Scraping-Logik ist eine Blackbox. Wenn die API eine Website oder einen Datentyp nicht unterstützt, bist Du blockiert. Du kannst das Verhalten nicht anpassen.

Website-Änderungen: Gute Provider halten ihre Scrapers aktuell und reagieren schnell auf Änderungen. Schlechte Provider sind manchmal wochenlang kaputt.

Abhängigkeits-Risiko: Du bist zu 100% vom Provider abhängig. Wenn er schließt, Preise ändert oder Scrapers nicht mehr pflegt, bricht Dein Workflow – ohne echte Alternative.

Wenn Flexibilität entscheidend ist: Wenn Du Websites scrapen musst, die die API nicht kann, oder Daten auf eine Art extrahieren willst, die nicht unterstützt wird, hast Du Pech. Dann ist ein custom Scraper oder AI scraping oft sinnvoller.

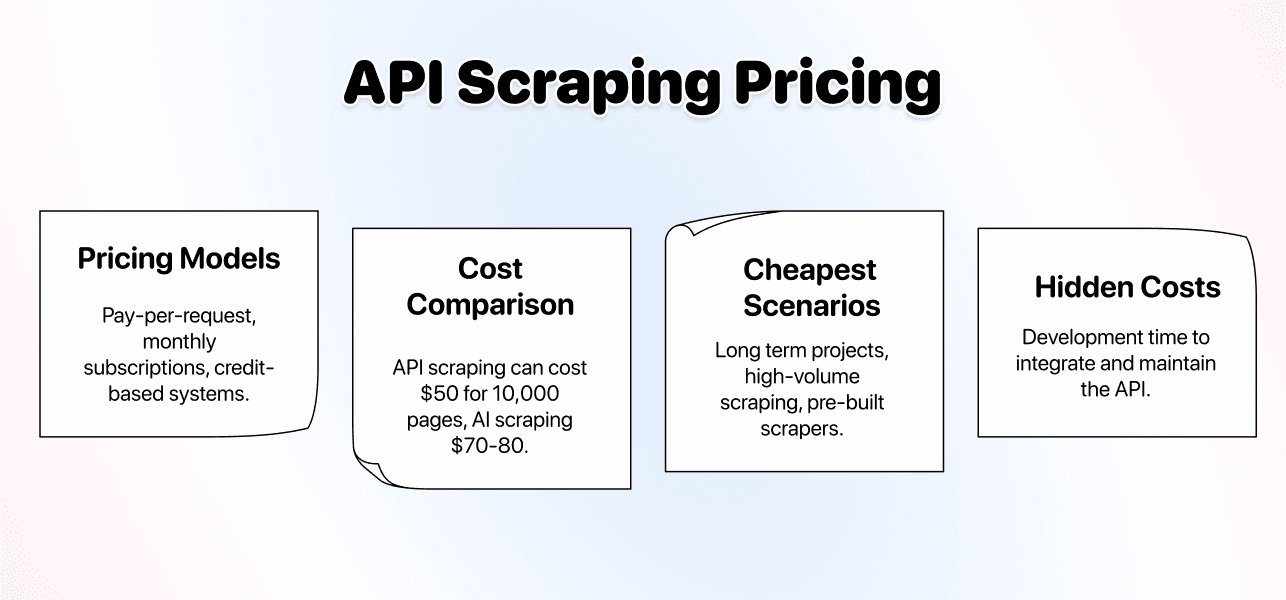

Preis

API-based scraping ist häufig die kosteneffektivste Option für hohe Volumina und eher einfache Scraping-Tasks.

Typische Preismodelle:

- Pay-per-request (oft nur Cent-Beträge pro erfolgreichem Scrape)

- Monatliche Subscriptions mit inkludierten Requests

- Credit-basierte Modelle mit Mengenrabatten

Kostenvergleich: Für 10.000 einfache Seiten pro Monat kann eine API-based Lösung um die 50$ kosten. Mit AI scraping kann dasselbe Volumen eher bei 70–80$ liegen – dafür ist der Setup-Aufwand viel geringer.

Wann API scraping am günstigsten ist:

- Langfristige Projekte, bei denen Dev-Time nicht entscheidend ist

- High-volume scraping von einfachen, stabilen Websites

- Nutzung von fertigen Scrapers für bekannte Plattformen

Wann es teuer wird: Wenn Du Custom-Scraping brauchst und die API das nicht gut abbildet, verbrennst Du Zeit und Budget. Die „günstige“ Lösung bringt dann keinen Output.

Versteckte Kosten: Entwicklungszeit für Integration und Maintenance. Wenn Du nicht technisch bist, musst Du jemanden einkaufen – und dann kippt die Kostenrechnung komplett.

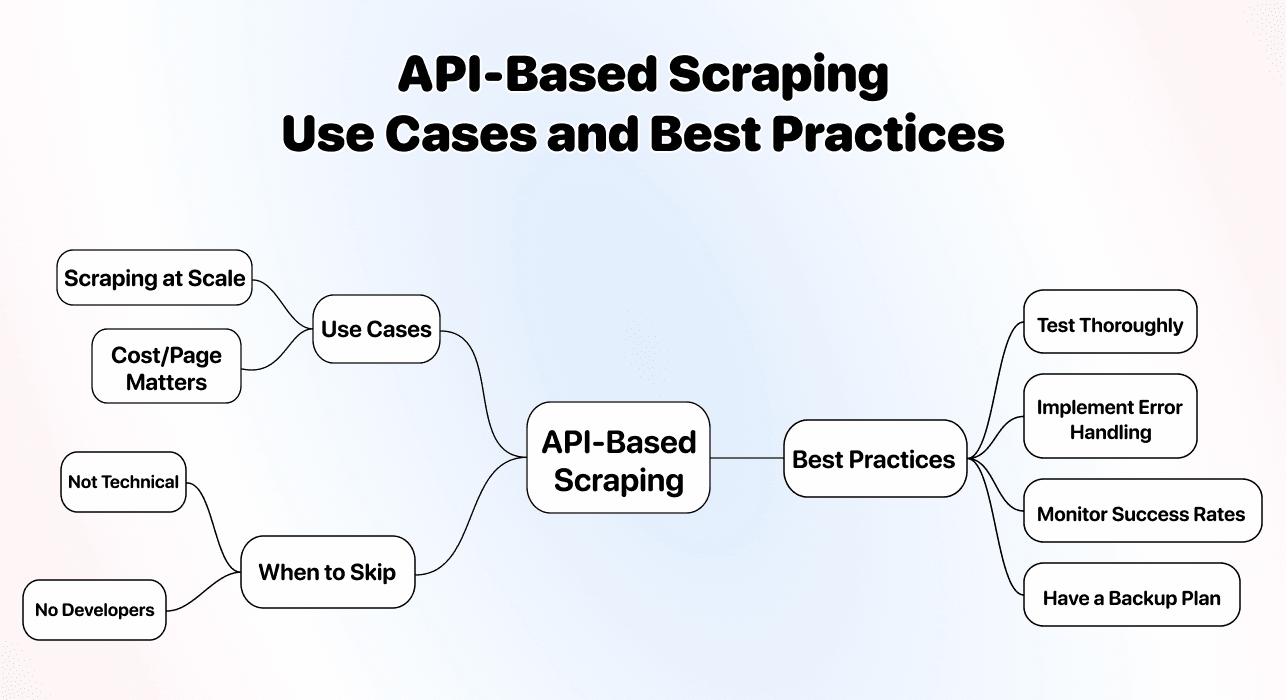

Use Cases und Best Practices

API-based scraping passt am besten zu technischen Teams, die viel und wiederholt scrapen.

Beste Use Cases:

- Scraping in großem Maßstab (tausende bis Millionen Seiten)

- Scraping direkt in Anwendungen integrieren

- Projekte, bei denen der Preis pro Seite wichtiger ist als Usability

Best Practices:

- Vorab gründlich testen, bevor Du Dich festlegst

- Robustes Error Handling für failed Requests

- Success Rates monitoren, um Breaks schnell zu erkennen

- Backup-Plan haben, falls der Provider schließt oder Bedingungen ändert

Wann Du API scraping skippen solltest: Wenn Du nicht technisch bist und keine Devs im Team hast, wird Dich API scraping eher frustrieren. Die Ersparnis hilft Dir nicht, wenn Du das Setup nicht sauber umgesetzt bekommst.

Bestes Tool dafür

Der „beste“ API-based Scraper hängt davon ab, was Du scrapen willst – aber diese Optionen sind solide:

-

Für allgemeines Web Scraping: ScrapingBee und Bright Data liefern zuverlässige API-based Lösungen für die meisten Websites. Proxies, Browser-Rendering und Anti-Bot-Maßnahmen sind in der Regel mit abgedeckt.

-

Für spezifische Plattformen: Nutze spezialisierte APIs (LinkedIn Scraper, Amazon Scraper etc.). Die sind dafür optimiert und lösen die typischen Probleme dieser Plattformen.

Worauf Du achten solltest:

- Klare Doku und Beispiele

- Zuverlässige Uptime und Support

- Transparente Preise ohne versteckte Gebühren

- Gute Success Rates für Deine Target-Websites

Real Talk: Selbst die besten API-based Scraper brauchen technische Skills. Wenn „API calls machen“ für Dich nach Stress klingt: nimm AI scraping – Du hast mehr Kontrolle und deutlich mehr Ruhe.

💡 API Scraping ist günstig, aber technisch

API-based scraping hat oft den besten Preis pro Seite bei High-Volume-Projekten – aber Du brauchst technische Skills, um es sinnvoll zu nutzen. Nimm es nicht nur, weil es billig ist. Sonst gilt schnell: billig gekauft, doppelt gezahlt.

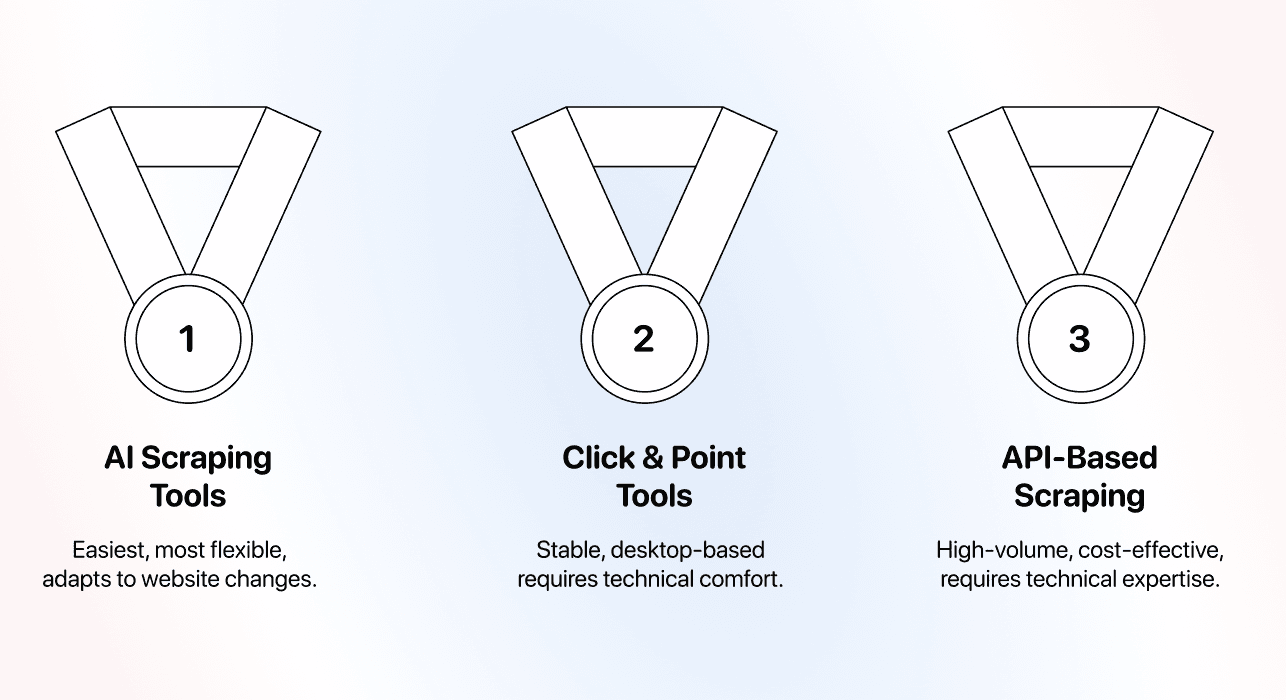

Fazit: Welche Methode solltest Du wählen?

Nach dem Vergleich der drei Ansätze kannst Du so entscheiden:

Wähle AI Scraping, wenn:

- Du nicht technisch bist und die einfachste Option willst

- Maintenance-Zeit für Dich teuer ist

- Die Websites, die Du scrapest, sich häufig ändern

- Du flexibel bleiben willst, was genau Du extrahierst

Am besten für: Nicht-technische Nutzer, kleine Teams, lead list building, Market Research, Competitive Intelligence und Projekte, bei denen Zeit/Usability wichtiger sind als ein paar Cent pro Seite.

Bestes Tool: Datablist für echtes no-code mit natürlicher Sprache.

Wähle Click-and-Point Tools, wenn:

- Du stabile Websites scrapest, die sich selten ändern

- Du kein Problem damit hast, technische Konzepte zu lernen

- Du Maintenance in Kauf nimmst, wenn Seiten updaten

- Du Desktop-Apps lieber magst als Web-Tools

Am besten für: Teams mit technischer Affinität, stabile Behörden-/Institutionen-Websites und Projekte, bei denen Setup-Zeit nicht das Hauptkriterium ist.

Bestes Tool: Octoparse – starke Features, gute Dokumentation.

Wähle API-Based Scraping, wenn:

- Du technisch bist oder Entwickler im Team hast

- Du High-Volume scrapest (tausende Seiten pro Tag)

- Preis pro Seite Deine Top-Priorität ist

- Du Scraping in Anwendungen integrieren willst

Am besten für: Technische Teams, High-Volume-Projekte, App-Integrationen, Situationen mit verfügbarer Dev-Time und klarem Fokus auf Kosten pro Seite.

Beste Tools: ScrapingBee oder Bright Data für general scraping, spezialisierte APIs für konkrete Plattformen.

Unsere Empfehlung für die meisten

Für 80% der Nutzer ist AI scraping die richtige Wahl. Bedienbarkeit, Flexibilität und minimale Maintenance sind den leicht höheren Preis pro Seite meistens wert.

Die no-code scraping Welt hat sich weiterentwickelt. Was früher technisches Wissen oder Stunden an Konfiguration gebraucht hat, dauert heute oft nur noch Minuten – wenn Du sauber erklärst, was Du willst.

Hier sind 3 einfache Gründe, warum AI scraping der beste Startpunkt ist:

- Es ist die einfachste Methode

- Es ist die flexibelste Methode

- Es braucht praktisch keine Maintenance

Und wenn Du später auf ein Volumen von 10.000+ pro Tag skalieren willst, kannst Du für genau diese High-Volume-Tasks auf API-based Scraper wechseln.

Frequently Asked Questions

Was ist die effizienteste No-Code Scraping Methode?

Effizienz hängt davon ab, was Du genau misst. API-based scraping ist am kosteneffizientesten für High-Volume-Projekte, wenn Du technisch bist. AI scraping ist am zeiteffizientesten bei Setup und Maintenance, wenn Du nicht technisch bist. Für die meisten ist AI scraping insgesamt am effizientesten, weil technische Hürden und Maintenance praktisch wegfallen.

Ist AI Scraping besser als No-Code Scraping?

AI scraping ist eine Form von no-code scraping – nur die modernste. Wenn Leute diese Frage stellen, meinen sie meistens: „Ist AI scraping besser als Click-and-Point Tools?“ In den meisten Fällen: ja. AI scraping passt sich automatisch an Website-Änderungen an, braucht weniger technisches Wissen, weniger Maintenance und ist insgesamt oft günstiger als Click-and-Point Tools.

Ist AI Scraping teuer?

AI scraping kostet pro Seite mehr als API-based Methoden, aber meist weniger als die Gesamtkosten von Click-and-Point Tools. Für 1.000 Directory-Listings solltest Du grob mit 800–1.200 Credits rechnen (je nach Tool und Seitenkomplexität). Der Wert kommt durch null Maintenance und kein technisches Setup – was nicht-technischen Nutzern Zeit und Geld spart.

Was ist AI No-Code Scraping?

AI no-code scraping, also AI scraping, bedeutet: Daten mit künstlicher Intelligenz aus Websites extrahieren, ohne Code zu schreiben oder technische Selektoren zu konfigurieren. Du beschreibst in normaler Sprache, welche Daten Du brauchst, und die AI versteht Dein Ziel und erledigt den technischen Teil. Damit kombiniert es die Zugänglichkeit von no-code Tools mit der Fähigkeit, sich automatisch an verschiedene Website-Strukturen anzupassen.

Kann ich mehrere Scraping Methoden kombinieren?

Ja – und viele Teams machen das genauso. Nutze AI scraping für Exploration, neue Websites und alles, wo Flexibilität zählt. Sobald Du High-Volume- und repetitive Tasks identifiziert hast, kannst Du diese gezielt auf API-based Methoden umstellen, um Kosten zu sparen – mit dem Trade-off, dass Du technische Themen managen musst und es Setup-Zeit kostet.